如何设定网站关键词搜索引擎优化seo包括

随着“中国制造2025”战略加速落实,制造业生产线正在加紧向智能化、自动化和数字化转型之路迈进。而人工智能技术的兴起以及边缘算力持续提升的同时,机器视觉及其相关技术也在飞速发展,并不断渗透进工业领域,拓展应用场景的同时,催生了巨大的市场。据GGII数据预计,到2027年我国机器视觉市场规模将达到565.65亿元。

在智能制造的浪潮下,制造行业生产线对生产设备有了新的要求,对于质量检验和生产的需求不断增加。而机器视觉系统凭借着更高精度、更高效率、更高准确率,以及短时间内处理大量信息的能力,为机器视觉技术在工业领域的进一步铺开奠定了基础。

机器视觉技术升级,制造业获转型新路径

近年来,深度学习、3D视觉技术的迅速崛起,为制造业转型打造了新的路径。深度学习技术不同于传统机器视觉,不需要专业人士定制开发算法,其采用多层神经自学习算法网络,能够更好地对图像进行识别分类处理,只需要一部分NG和OK样本图片用于缺陷标注训练就可以完成模型的建立,且在面对新的缺陷类型时,也只需要完成新类型缺陷样本训练优化模型,从而完成对新的缺陷类型的检测,以更高性能的对物体进行自主检测与识别。

此外,3D机器视觉也在技术发展以及市场的“双动力”下应运而生。3D视觉利用光学技术模拟人类视觉系统,能够检测物体长、宽、高等三维上的数据,以精确坐标的三维点云,定位目标物体的高精度三维数字化模型,更详细的检测物体对象。3D视觉还能突破2D视觉受光源变化、无法处理高度信息等限制,能够测量2D视觉不能测量的形状信息,如物体平直度、表面角度、体积等,并为工业拆码垛、自动分拣等“痛点型”应用场景提供专业的技术支持。

目前,这些技术都是在工业领域的质量控制环节至关重要的技术,其在各行各业都有大量的应用案例,其案例包括外观缺陷检测、字符识别、以及视觉引导定位、自动分拣等。

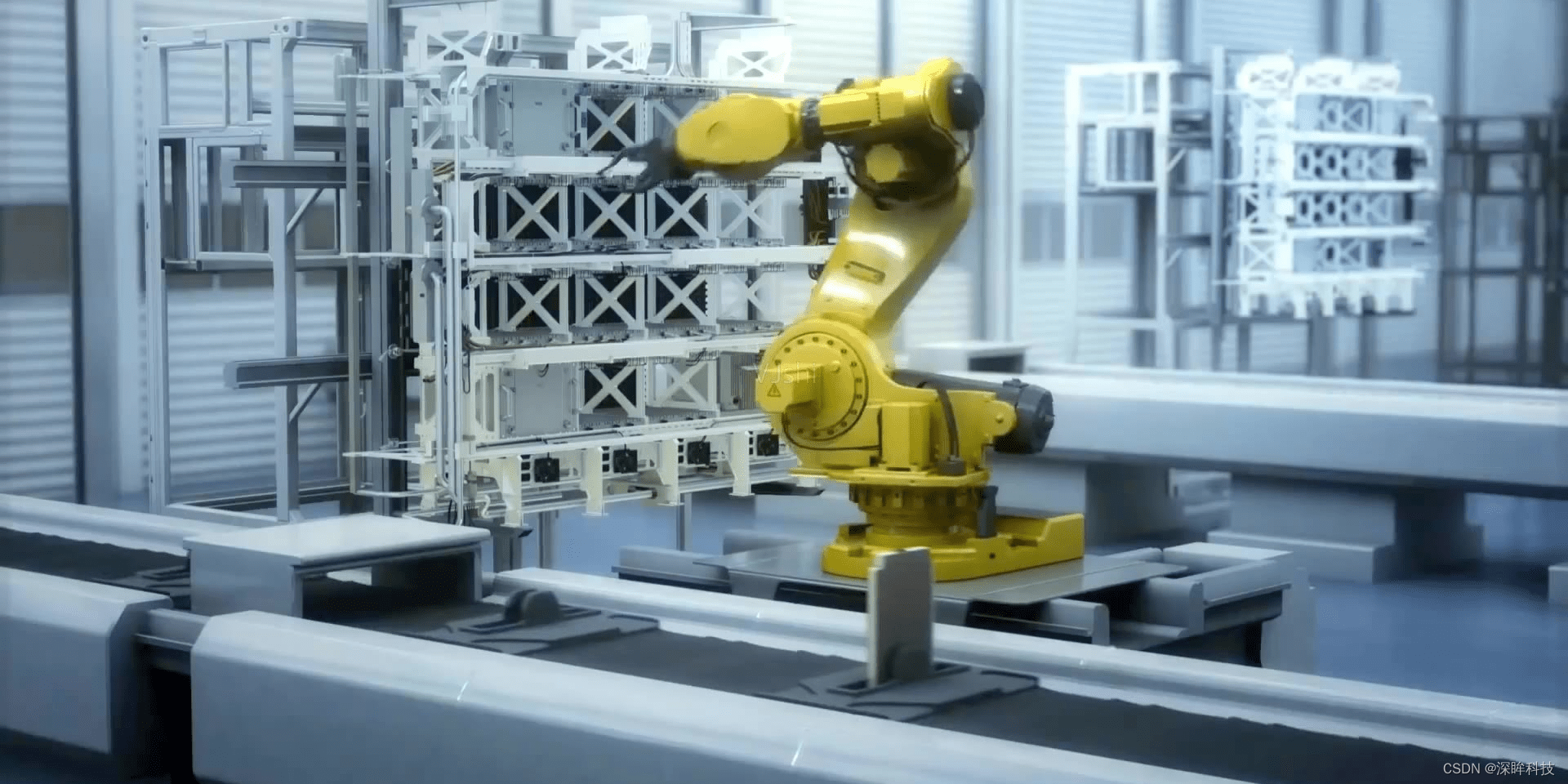

工业4.0进程加快,生产线智能化发展

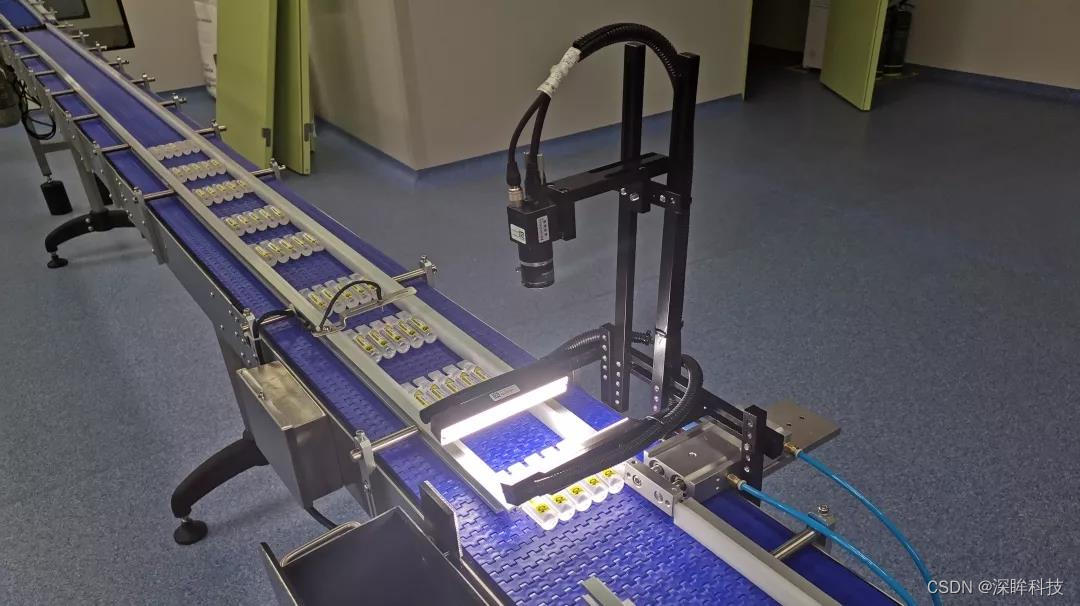

随着工业4.0和工业物联网的快速发展,机器视觉系统加速渗透进工业领域,并成为了工业生产领域不可或缺的一部分。在制造业生产线上,机器视觉系统主要负责图像的采集处理以及测量,根据不同质量和安全参数捕获产品图像以进行分析,以较高性能可靠的解决复杂工业任务。

对于制造业生产线来说,人工智能与机器视觉技术以其精确性、持续性、高效性和可重复性等优势加速代替传统人工不稳定检测,在识别物体位置、大小、颜色、形状等场景中,发挥着重要作用。目前机器视觉技术已经实现在众多行业生产线实现应用,以识别、定位、检测、测量、分拣等能力,大幅提升产线智能化程度,同时推动信息技术工程自动化发展,促进制造业转型升级。

目前,智能制造已经成为全球制造业升级发展的的重要方向,未来制造业工厂将采用越来越多的自动化技术,机器视觉将在智能制造进程中发挥关键作用。而深眸科技也将继续深耕机器视觉领域,持续创新技术与研发视觉应用产品,凭借着机器视觉凭软件水平和硬件技术的发展,以及人工智能算法的助力,赋能产线的自我调整,以最大限度提高质量、产量和盈利能力,加速生产线的数智化发展进程。