如何提高网站的访问量上海中风险地区清零

ChatGPT是一个非常先进的AI工具,它使用GPT-4架构,能够生成自然的语言回应。它的多功能性和理解复杂指令的能力,使得很多人用它来回答各种问题,就像用Google一样输入关键词。不过,ChatGPT还能做更多事情,下面我们来介绍一些技巧和提示,帮助你更好地使用ChatGPT。

使用ChatGPT的步骤

- 输入问题:在首页的消息框里输入你的问题或提示。

- 获取回答:ChatGPT会根据你的问题生成答案,显示在你的问题下方。

- 互动:

- 输入新问题

- 重新生成答案

- 复制答案

- 分享答案

- 点赞或不喜欢答案

10个有效使用ChatGPT的技巧

- 提供清晰简洁的指示

- 给ChatGPT明确的指示,这样它才能理解你想要的内容。如果指示不清晰,ChatGPT可能会给出不准确的回答。

- 把复杂问题分成小部分

- 把大问题拆成几个小问题,这样ChatGPT更容易理解和回答。

- 用例子说明

- 给ChatGPT一些例子,它会更容易理解你想要的格式和内容。

- 尝试不同的措辞

- ChatGPT对措辞很敏感,试着用不同的方式提问,看看哪个得到的答案更准确。

- 使用系统级指示

- 用“系统:”开头的提示来指导ChatGPT的行为,设置上下文或特定指示。

- 模拟用户行为

- 通过假装是用户或提供示例用户的回应,引导ChatGPT按特定方式回应。

- 指定格式

- 如果你想要特定格式的回答,比如项目符号、列表或段落,在提示中明确说明。

- 反复修改

- 如果ChatGPT的初次回答不满意,可以修改提示,提供更多上下文或重写问题,以获得更好的回答。

- 控制生成

- 在提示中加入指导,比如“答案要简短”或“使用简单语言”,来控制回答的风格和长度。

- 从例子中学习

- 与社区互动,学习其他人分享的提示和回答,从中获得灵感和技巧。

像专家一样使用ChatGPT

ChatGPT不仅可以回答你的问题,还可以根据你的需要修改和定制回答。以下是一些使用ChatGPT的方法,帮助你得到个性化的结果:

总结以更好地理解

有时ChatGPT的回答可能很长或复杂。你可以让它总结关键点,使内容更容易理解。你也可以用它来总结一些长文档或文章。

示例提示: “请将这篇文章总结成10个最重要的信息点-[链接到网页]。”

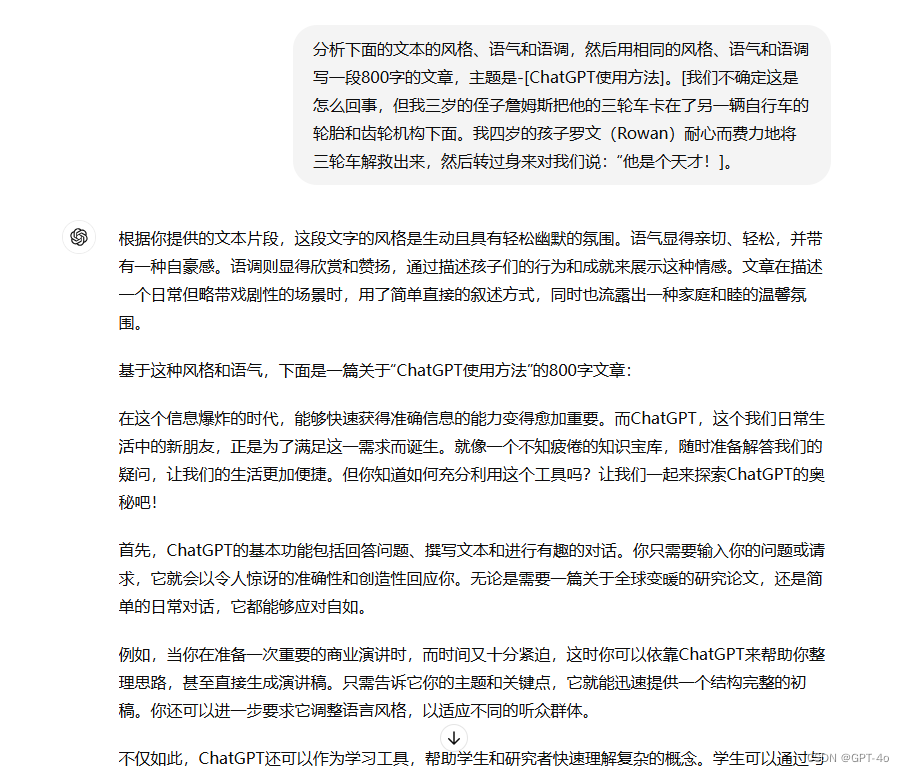

训练ChatGPT学习你的写作风格

ChatGPT可以从与用户的互动中学习。通过频繁互动和提供反馈,让ChatGPT了解你的写作风格,生成更符合你需求的回答。

示例提示: “分析下面的文本的风格、语气和语调,然后用相同的风格、语气和语调写一段800字的文章,主题是-[主题]。[段落]。”

改变写作风格以提高可读性

有时候,长篇或复杂的文章可能难以阅读或枯燥。你可以让ChatGPT用更易懂或更有趣的方式重写文本。

示例提示: “把下面的文本改写成适合12岁小朋友理解的风格-[文本]。”

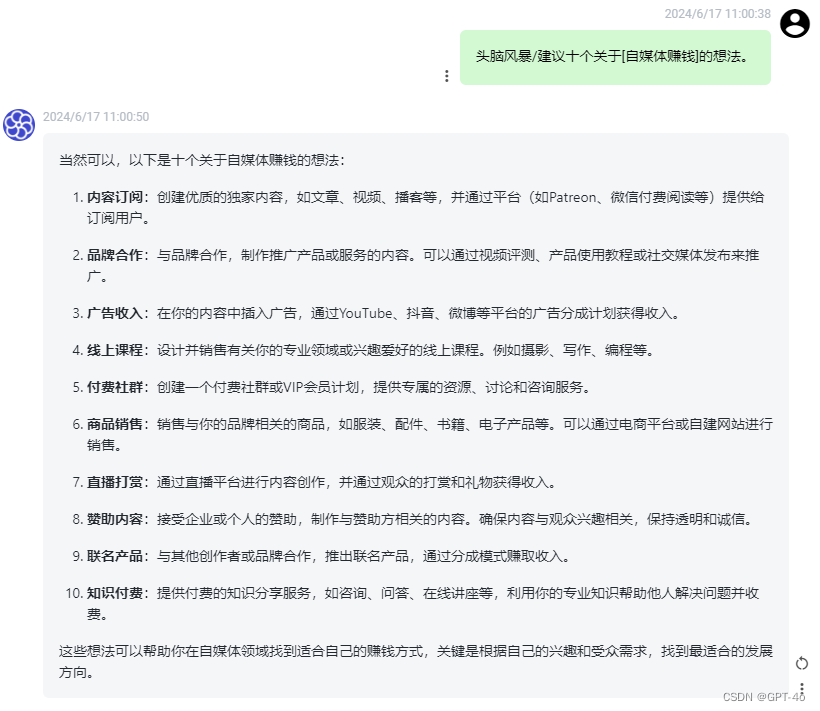

头脑风暴新想法

如果你需要为社交媒体帖子、博客或新闻简报找新点子,ChatGPT可以帮助你头脑风暴,产生有创意的想法。

示例提示: “头脑风暴/建议十个关于[你的目标]的想法。”

编写和调试代码

许多人使用ChatGPT来编写和调试代码。它可以帮你找出代码中的错误,并提供正确的代码。

示例提示: “这是一个[语言]代码片段。当我运行它时,出现了错误[错误]。请重写代码,以便我参考,尽量保证正确无误。”

指定详细内容

如果你想要更详细的回答,可以指定内容类型。例如,想要增长小红书粉丝,你可以指定希望获得激励性的语调,教小红书用户如何简单地增长粉丝。

示例提示: “使用以下要点创建一个详细的指南。生成的回答应具有适当的结构,包括副标题和项目符号。

回答的语调:[语调]

目标读者:[用户]

要点列表:[要点列表]。”

用ChatGPT编辑你的作品

无论是写简历、文章还是社交媒体帖子,ChatGPT都能帮你编辑,提供结构、语法、语气等方面的反馈,让你的作品更有效。

示例提示: “编辑以下文本,使其对我的[博客/社交媒体/简历/其他]更有吸引力。”

准备好使用ChatGPT了吗?

ChatGPT是一个强大的AI工具,能够帮助个人和企业实现目标。通过应用这些提示和策略,你可以生成个性化和准确的回答,满足你的所有需求。