建网站地址房地产系统软件

一、功能位置

二、脚注和尾注区别

1.首先脚注是一个汉语词汇,论文脚注就是附在论文页面的最底端,对某些内容加以说明,印在书页下端的注文。脚注和尾注是对文本的补充说明。

2.其次脚注一般位于页面的底部,可以作为文档某处内容的注释;常用在一些说明书、标书、论文等正式文书用来引注的内容。

3.脚注由两个关联的部分组成,包括注释引用标记和其对应的注释文本。作者可Word让自动为标记编号或创建自定义的标记。 在添加、删除或移动自动编号的注释时,Word 将对注释引用标记重新编号。

4.脚注一般位于页面的底部,可以作为文档某处内容的注释;尾注一般位于文档的末尾,列出引文的出处等。

三、如何使用*(以尾注举例)

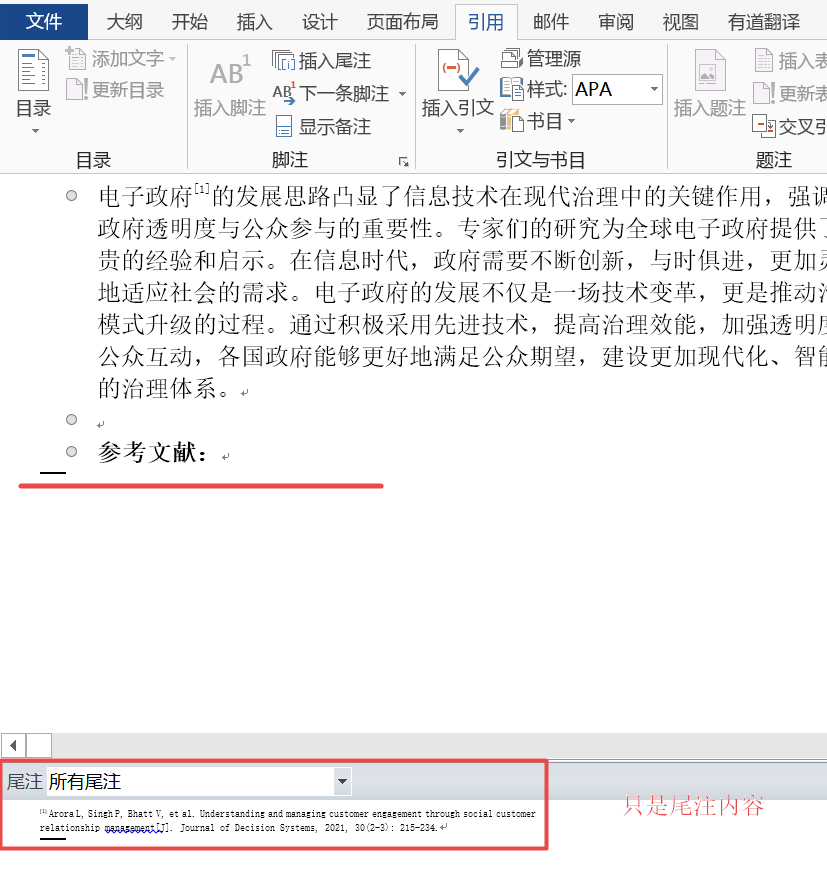

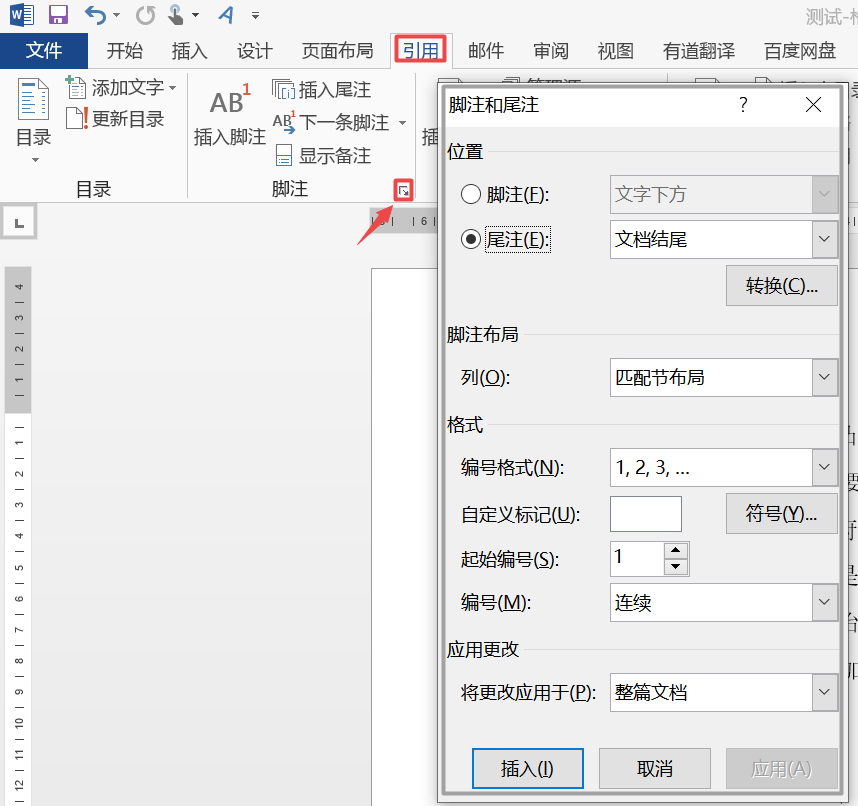

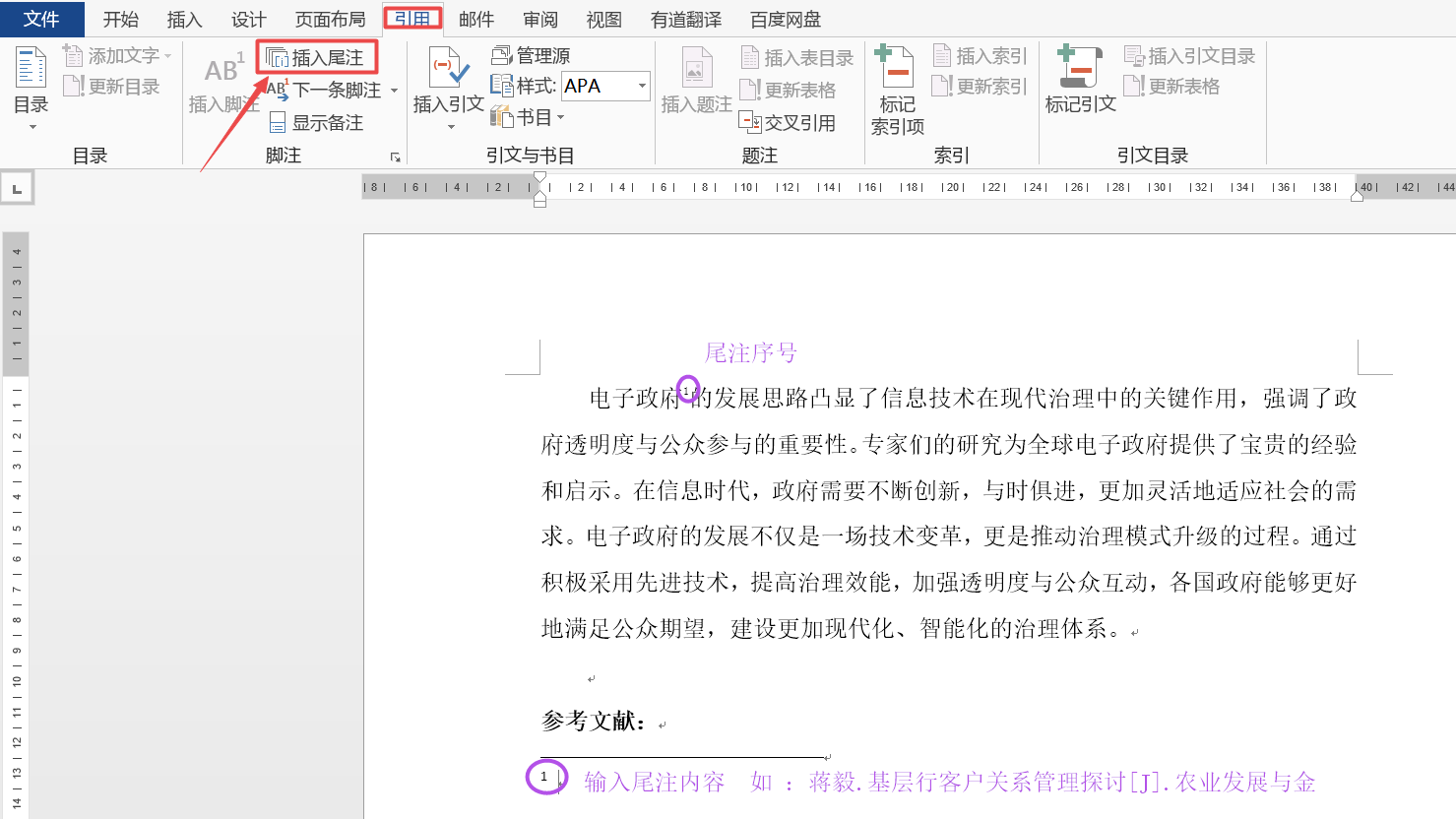

3.1 尾注序号设置

3.2 在光标位置,插入尾注

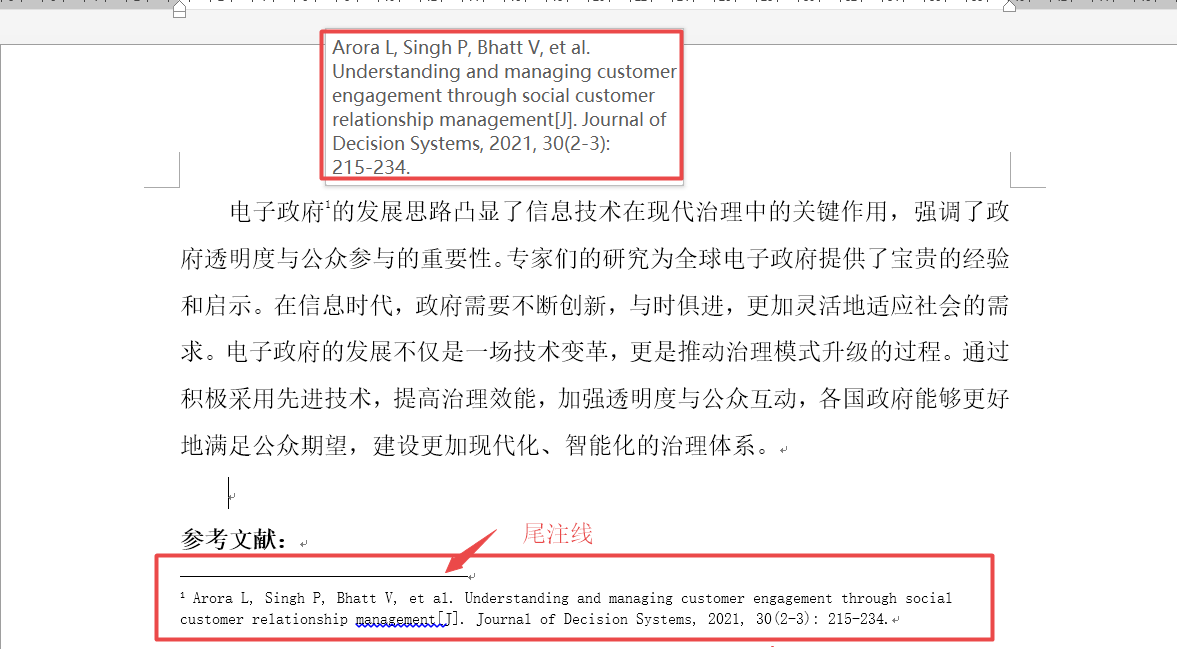

3.3 修改样式去除尾注线、标号替换为[1][2]格式

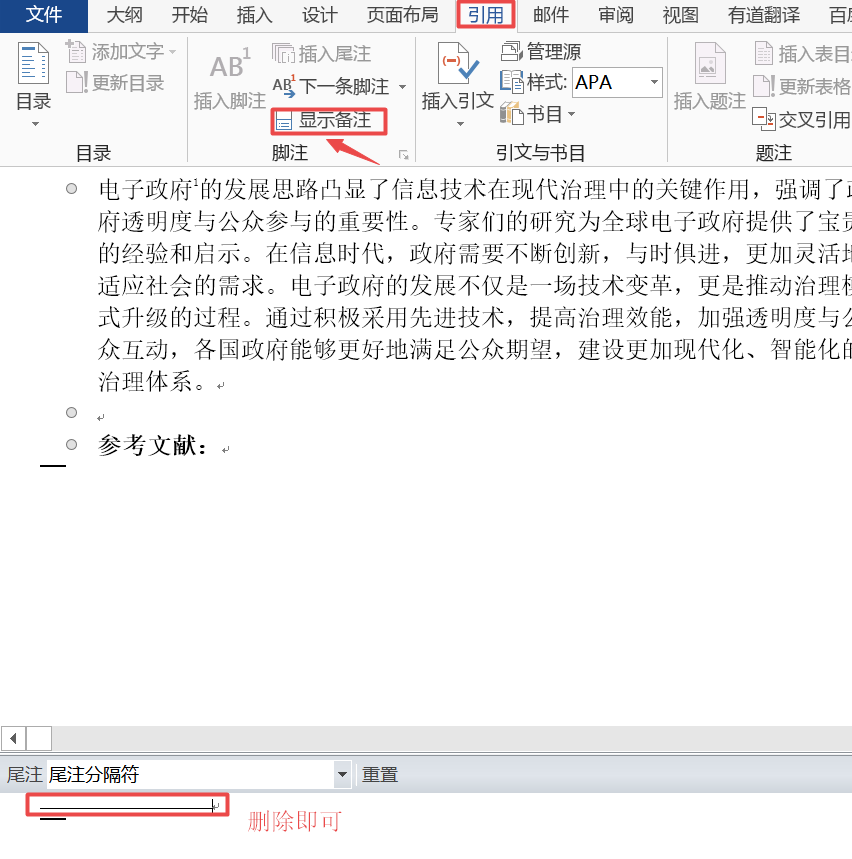

3.3.1 去除尾注线

切换为“大纲视图”模式,显示备注,

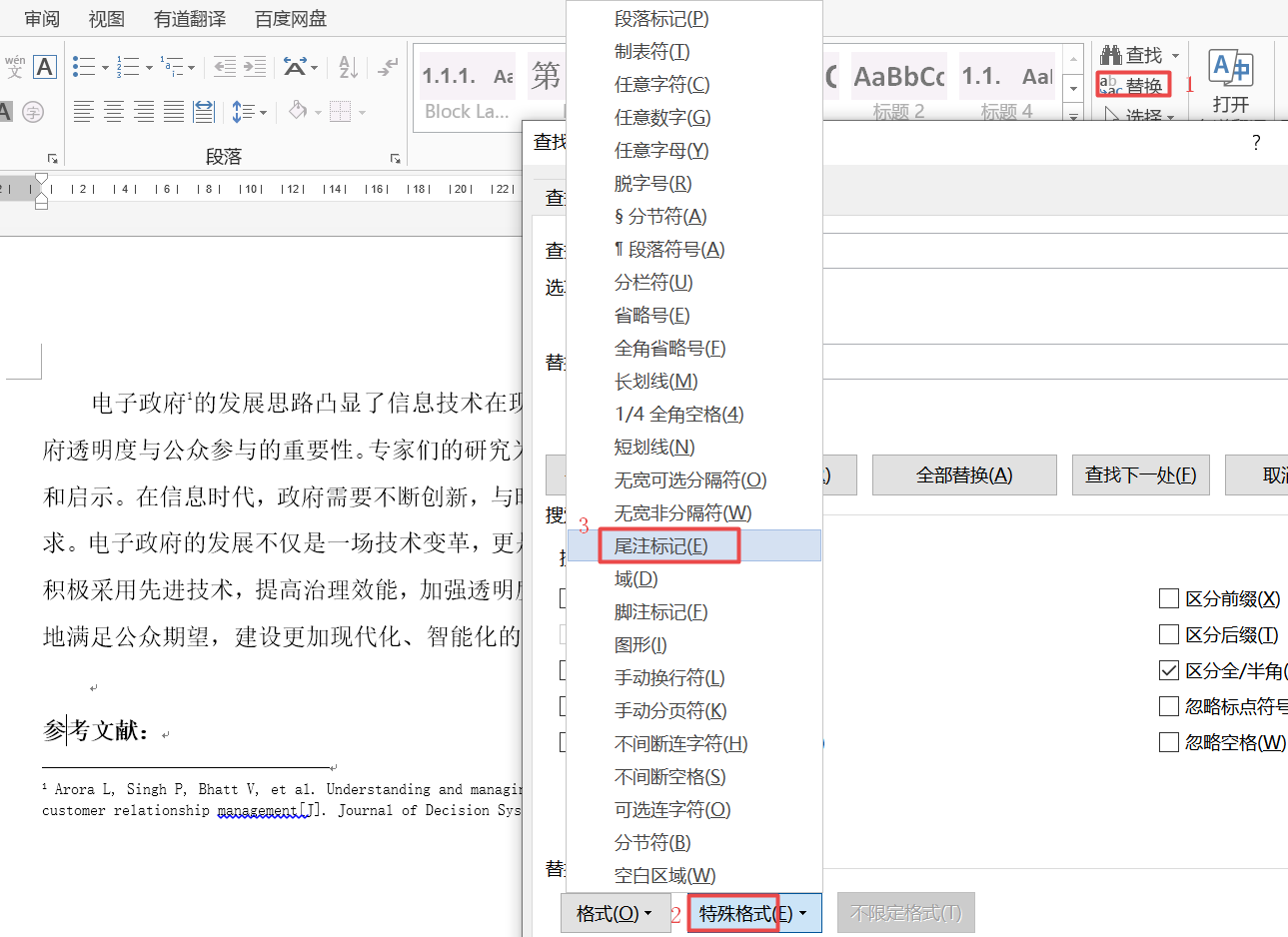

3.3.2 替换格式为[1] [2]

替换后的结果:

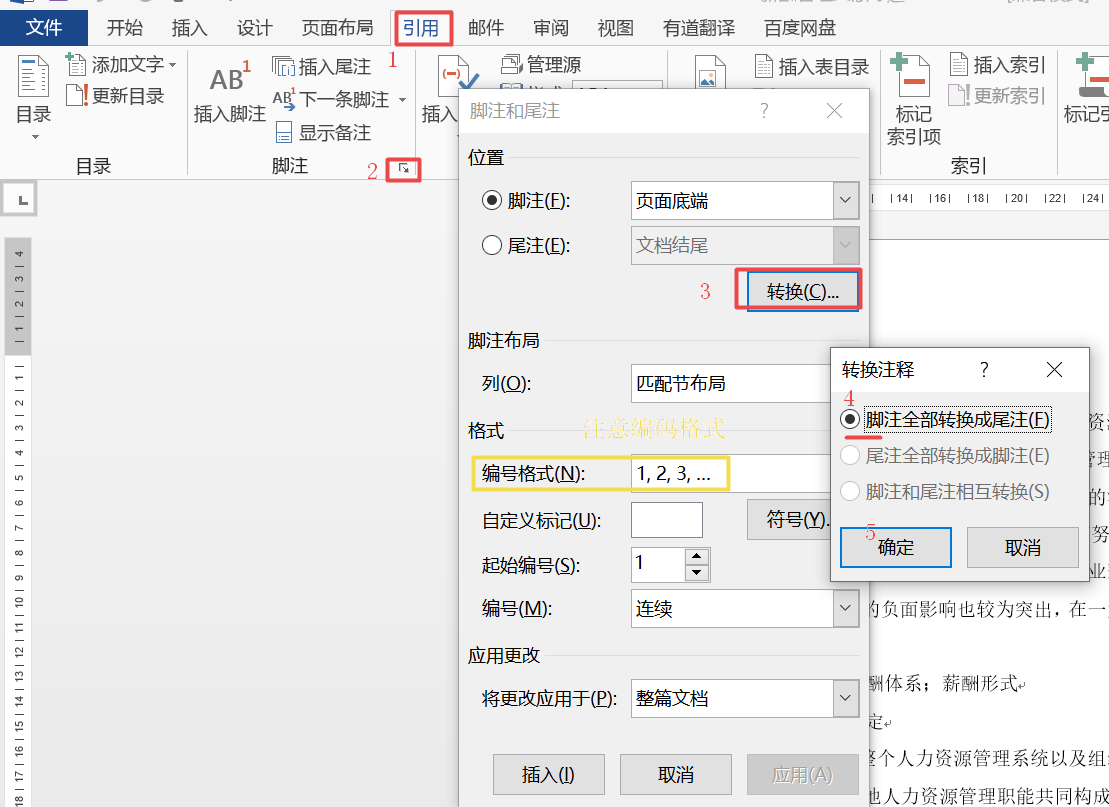

3.4 尾注和脚注如何转换

例如:脚注转为尾注

1)尾注格式先设置好

2)开始转换

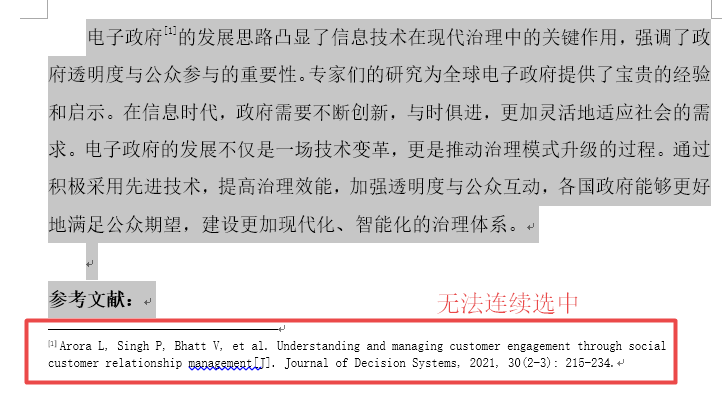

四、其他小坑-word内容不能全选中

正文内容和尾注内容虽然都显示在word里,复制的时候,会发现无法 全选复制所有内容,就是因为尾注 不算是正文内容。