旅游网站开发的背景及意义做网站需要基础吗

前面的文章中我们为大家介绍了市面上常见自动化测试框架的解读以及Robot Framework的环境搭建,本文我们继续为大家介绍Robot Framework命令和Tag的运用,首先我们先一起看一下Robot Framework有哪些命令。

前面的文章中我们为大家介绍了市面上常见自动化测试框架的解读以及Robot Framework的环境搭建,本文我们继续为大家介绍Robot Framework命令和Tag的运用,首先我们先一起看一下Robot Framework有哪些命令。

Robot Framework命令

先来看这一条:robot -d xxx(报告地址) xxx(用例地址)

这一条的意思是我们通过调robot的指令就可以去执行自动化测试,第一个参数是你要生成的报告的地址在哪,第二个是你当前编写的.robot的文件用例放在哪。

robot –h(robot --help)帮助命令,通过这个指令我们可以看到常用的参数有哪些。

1. -i --include tag *通过标签控制测试执行范围,可以使用 AND,OR,NOT 操作符

-- include B0-Single-API-i B0-Single-APIANDB1-stock-center

2. -e --exclude tag *通过标签控制测试不执行范围

--exclude tag1-e tag2

在公益直播中还延伸了一些其他内容,大家如果感兴趣的话可以私信我获取回放链接,观看完整直播回放。

Robot Framework Tag的运用

接下来我们一起看一下Tag的运用:

1、合理使用标签可以提升测试报告可读性

2、使用标签可以对用例进行筛选调试

第一条很好理解,我们在生成报告的时候,测试报告可以根据Tag去进行分类,后面的实战演示中也会跟大家一起去看一下测试报告是什么样的。第二条讲的是,如果我需要对一部分用例进行调试,这时候就可以通过标签的方式去进行筛选调试。

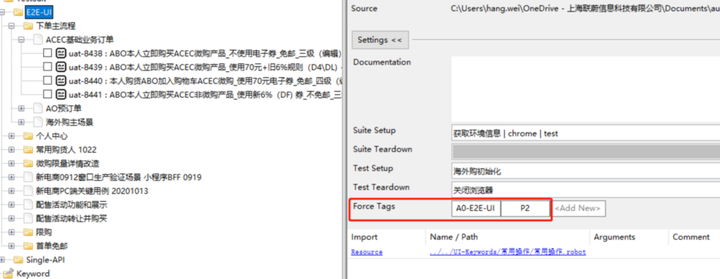

接下来我们一起看一下标签在哪里打。通过下面的截图我们可以看到,如果你在suite下面,所有的测试用例都被打上Force Tags标签,如果在Testcase用例层级,那就是只针对当前用例打标签。

后面会针对案例,为大家详细演示Robot Framework的使用过程,欢迎大家继续关注。

(本系列文章根据《优品软件培育计划》公益直播内容整理,可以私信我获取直播回放链接。)