永康门业微网站建设wordpress手机上图片

一.题目描述

假设共有鸡、兔30只,脚90只,求鸡、兔各有多少只?

二.思路分析

本题是一个典型的穷举法例题,而穷举法,最重要的就是条件判断。⭐⭐

本题中的条件很容易发现:

假设鸡有x只,兔有y只⭐

那么:x+y==30,2*x+4*y==90⭐

if(x+y==30&&2*x+4*y==90)三.代码实现

#include<stdio.h>

int main()

{int x=0; //鸡的数量int y=0; //兔的数量for (int x = 0; x < 90 / 2; x++)//鸡不能多于45只{for (int y = 0; y < 90 / 4; y++)//兔不能多于22只{if(2*x+4*y==90&&x+y==30)//判断的条件printf("鸡有%d只\n兔有%d只", x, y);}}

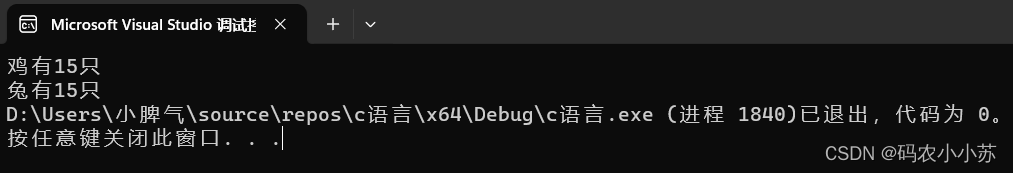

}四.运行结果

创作不易, 如果这份博客👍对你有帮助,可以给博主一个免费的点赞以示鼓励。

欢迎各位帅哥美女点赞👍评论⭐收藏⭐,谢谢!!!

如果有什么疑问或不同的见解,欢迎在评论区留言哦👀。

祝各位生活愉快⭐