手机膜+东莞网站建设网站系统建设系广告经营者

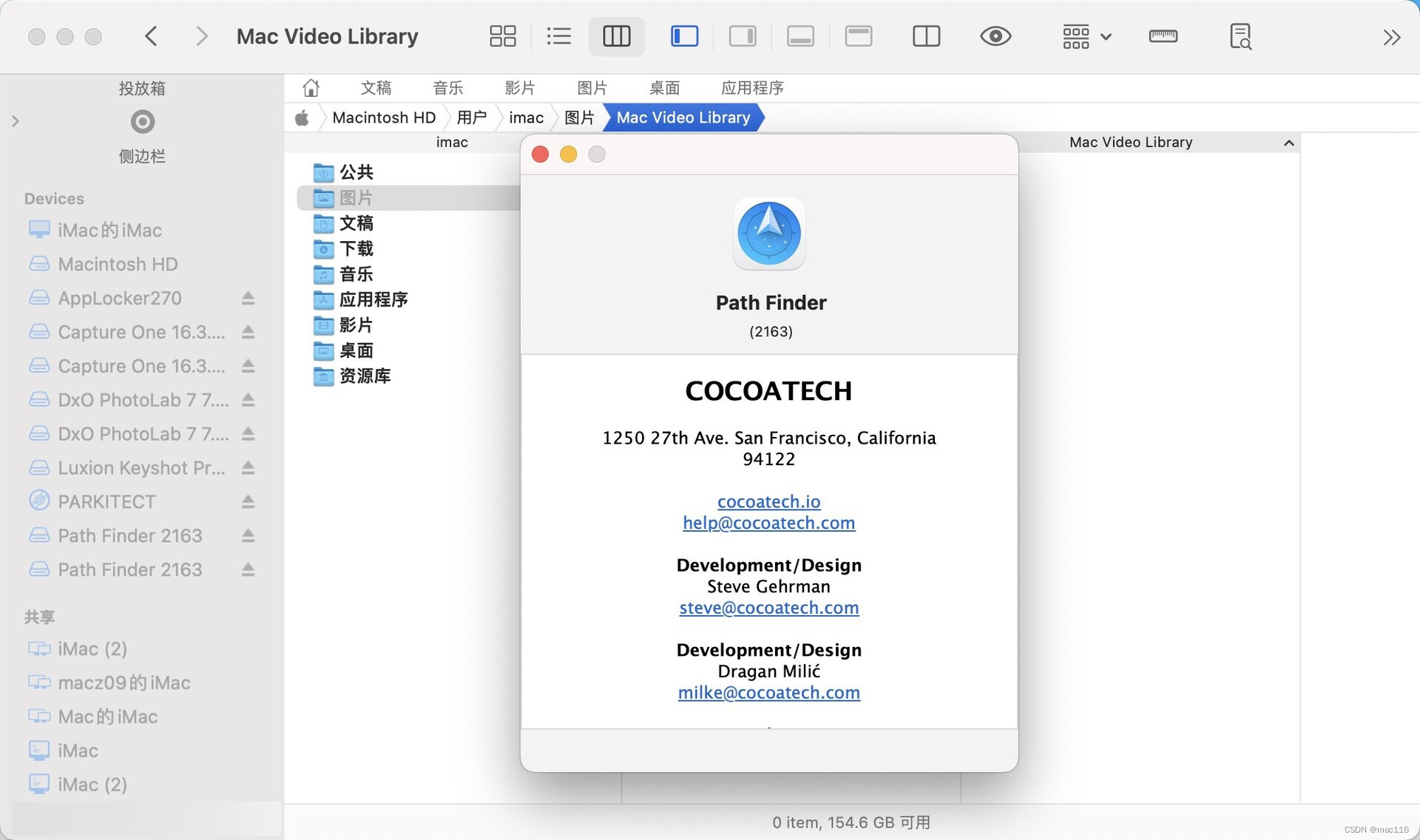

Path Finder mac是一款Mac平台上的文件管理和操作工具,提供了比Finder更丰富的功能和更直观的用户界面。它可以帮助用户更高效地浏览、复制、移动、删除和管理文件,以及进行各种高级操作。

Path Finder mac软件功能

- 文件浏览:可以快速浏览文件夹、文件和磁盘,并支持多标签页和侧边栏视图等增强功能。

- 文件操作:可以复制、移动、重命名、删除和压缩文件,并支持自定义操作和脚本插件。

- 文件预览:可以预览各种文件类型的内容,如文本、图片、音频、视频、PDF等。

- 文件搜索:可以进行快速和高级搜索,并支持智能文件搜索和过滤器等功能。

- 文件同步:可以将文件同步到其他位置或设备,并支持自动同步和增量同步。

- 自定义设置:可以自定义外观和行为设置,并支持扩展和脚本。

总之,Path Finder是一款功能丰富、高效的文件管理和操作工具,适用于需要高效管理和处理大量文件的用户。

苹果:Path Finder mac(可以替代访达的文件管理器) v2163中文版

Win:Total Commander(文件管理器)