网站域名注册证书查询搭建wordpress服务器

来看看iPhone 16和Plus这两个新成员,实话说,它们和之前曝光的样子几乎完全一致。下面我们就一起来细数一下这次的几大变化吧。

外观设计:焕然一新

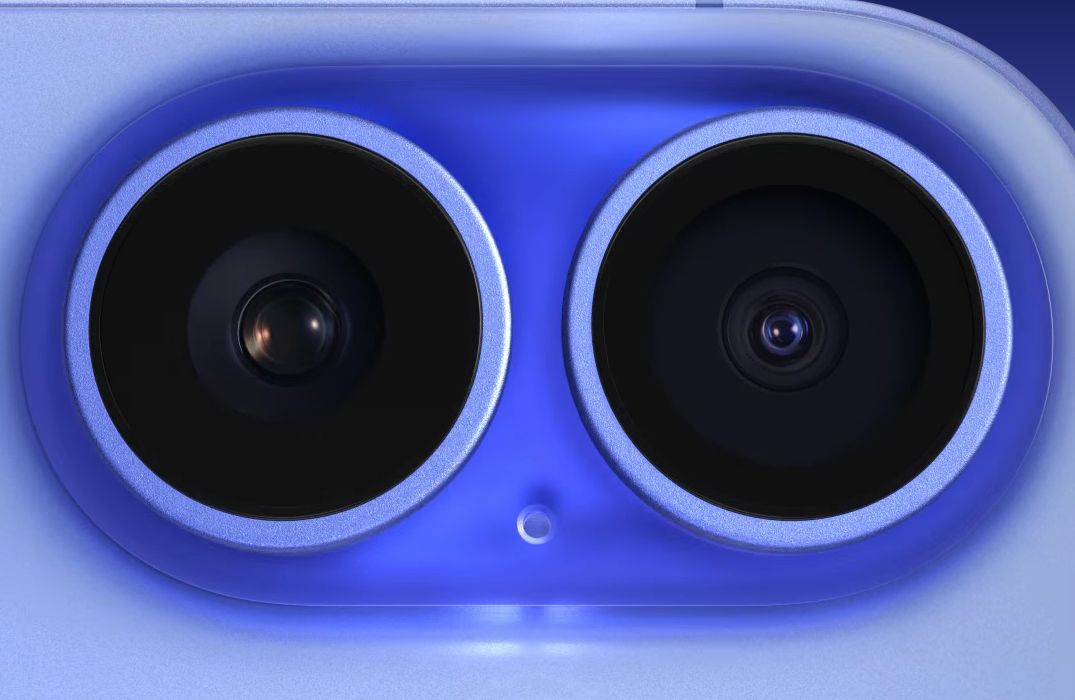

首先,最显眼的变化就是后置镜头模组的布局调整为了垂直排列。这一改变使得整个背面看起来更为整洁有序。除此之外,新增的操作按钮和相机控制按键也为日常使用带来了更多的便利性。

在屏幕尺寸方面,iPhone 16维持了6.1英寸的标准大小,而Plus版则保持了6.7英寸的大屏设计。这两款新机的屏幕亮度范围相当广泛,峰值亮度达到了2000nit,而最低亮度则可以低至1nit,这意味着无论是在强烈的阳光下还是在漆黑的夜晚,都能获得舒适的观看体验。

材质与色彩:质感与个性并重

机身材料方面,苹果选择了航空级铝材,既轻巧又坚固。屏幕盖板则采用了玻璃陶瓷配方,官方称之为新一代超瓷晶玻璃,相比初代产品,硬度提升了50%,这意味着屏幕将更加耐刮擦,更耐用。

在颜色选择上,除了经典的黑白双色之外,iPhone 16系列还新增了群青色、深青色以及粉色三种新配色。这些新颜色不仅丰富了用户的个性化选择,也让新款iPhone显得更具时尚感。

屏幕刷新率:神秘依旧

关于屏幕刷新率,苹果在这次发布会上并没有给出具体的数据。因此,我们可以推测,这一参数可能并未发生明显变化。不过,考虑到苹果一贯的技术实力,即便没有特别强调,日常使用的流畅度应该还是有所保障的。

新增按键:触控与操作的革新

正如之前的爆料所言,iPhone 16和Plus确实加入了新的相机控制按键。这个按键配备了Taptic Engine触觉反馈机制,也就是说,通过电容式感应器,它可以感知不同的按压力度,从而实现完全点击和轻触之间的区分。

简单来说,这个按键可以让你一键快速唤醒相机应用,长按则可以启动录像模式。如果你只是轻触它,则可以打开各种相机控制选项,比如变焦功能。另外,连续轻触两次还可以切换其他相机设置,一旦选定,只需滑动手指就可以轻松调整相应的参数了。

总的来说,iPhone 16和Plus在继承了前代产品的优点的同时,通过一些细节上的优化和创新,让用户体验变得更加便捷和有趣。无论是对于追求高效操作的专业人士,还是喜欢个性化定制的年轻人,这两款新机都有足够的吸引力。