网站及备案网站建设合同范本大全

在处理大量文件时,我们常常需要借助一些工具来提高工作效率。例如,在需要对Excel文档名称进行批量翻译时,一个方便快捷的工具可以帮助我们省去很多麻烦。今天,我将介绍一款名为固乔文件管家的软件,它能够帮助我们轻松实现Excel文档名称的批量翻译,从而让工作变得更加简单高效。

以下是使用固乔文件管家进行Excel文档名批量翻译的详细步骤:

1.首先,下载并安装固乔文件管家。这款软件界面简洁直观,操作简单方便,非常适合办公使用。

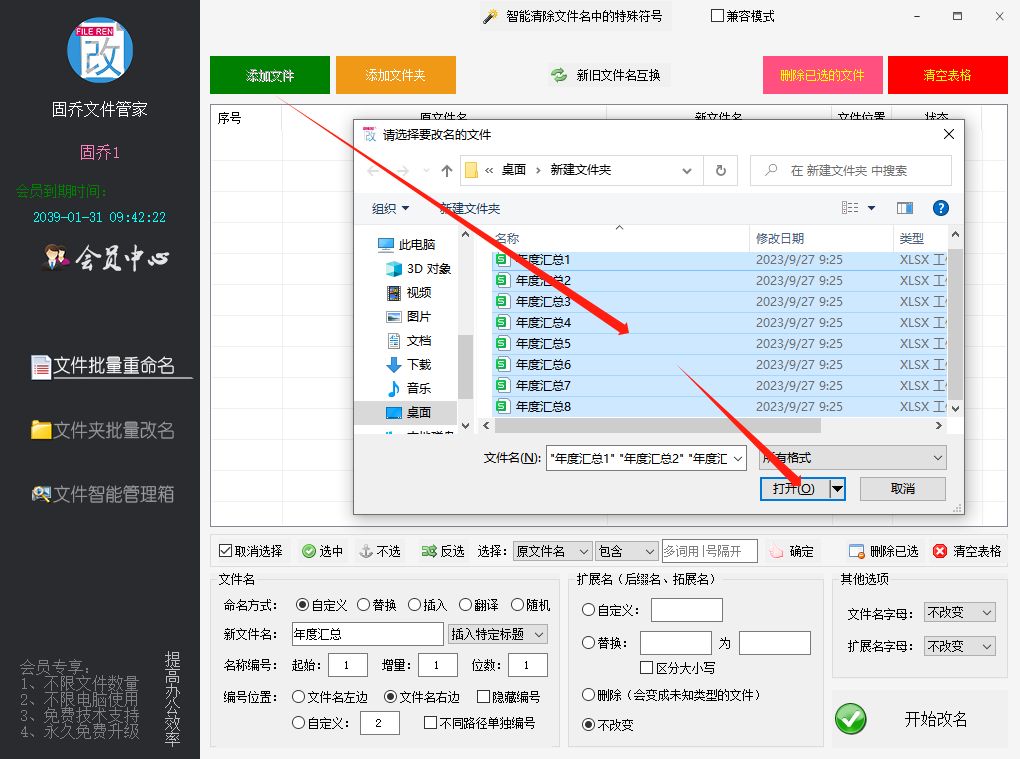

2.打开固乔文件管家,在主界面中找到并点击“文件批量重命名”功能。

3.在“文件批量重命名”功能界面中,选择需要修改的Excel文档。如果你希望对整个文件夹中的文件进行批量修改,可以通过“添加文件夹”功能来实现。

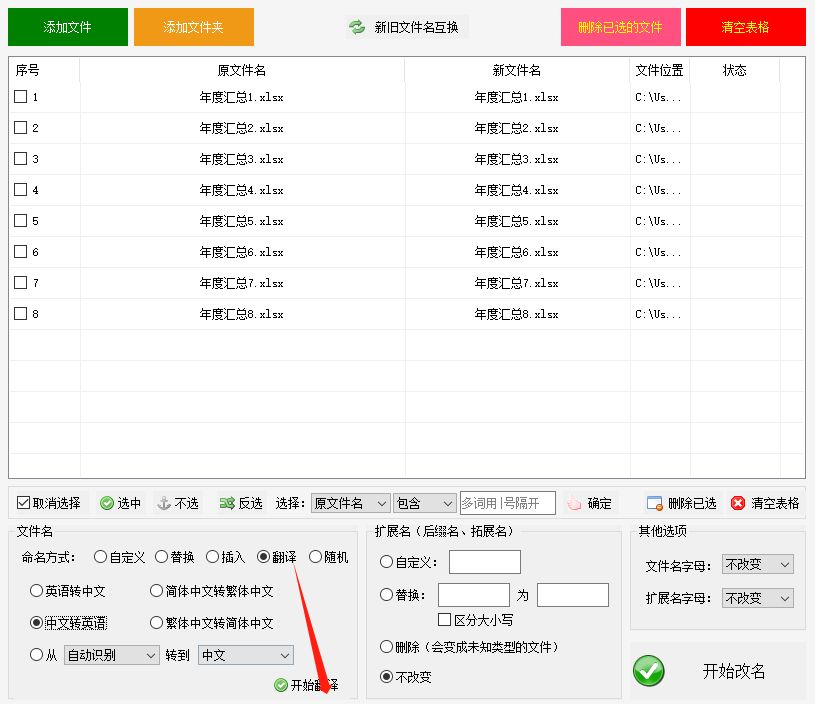

4.选择好文件后,在功能区中选择“翻译”功能。这里提供了多种翻译选项,例如“中文转英语”、“中文转日语”等,你可以根据自己的需要来选择。

5.勾选需要翻译的Excel文档,然后点击“开始翻译”。

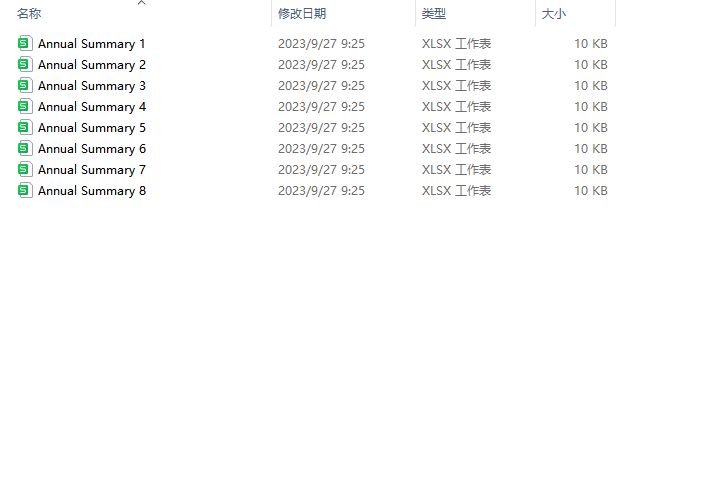

6.等待几秒钟,固乔文件管家就会自动完成批量翻译和重命名。

7.最后,检查修改后的Excel文档名是否符合你的预期。

通过以上步骤,我们可以轻松实现Excel文档名的批量翻译。如果你也有需要,那就快去试试吧!