网站建设与网页制作实训报告wordpress4.7 php版本

计算机网络基础

- 计算机网络和因特网

- 什么是 Internet?

- 具体构造的的角度

- 服务角度

- 网络结构

- 网络边缘

- 网络核心

- 电路交换

- 分组交换

- 概述

- 排队时延和分组丢失

- 转发表和路由选择协议

- 按照有无网络层的连接

- 分组交换 VS 电路交换

- 接入网

- DSL 因特网接入

- 电缆因特网接入

- 光纤到户 FTTH

- 无线接入网络

- 物理媒体

- 导引型媒体

- 非导引性媒体

大家好呀!我是小笙,本章我主要分享计算机网络基础 - 计算机网络和因特网(1)学习总结,这也是计算机网络基础的第一篇文章,希望内容对你有所帮助!!

计算机网络和因特网

什么是 Internet?

网络中的网络

具体构造的的角度

-

节点

- 主机及其上运行的应用程序

- 路由器、交换机等网络交换设备

-

边:通信链路(光纤、同轴电缆以及无线电等等)

- 接入网链路:与主机直接互通的互联网的链路

- 主干链路:网路交换设备间的链路

-

协议:规定语法、语义、时序以及动作

定义了两个或多个通信实体之间交换的报文格式和次序,以及在报文传输、接收或其他事件方面所采取的动作

服务角度

互联是分布式的应用进程以及为分布式应用进程提供通信服务的基础设施

- 使用通信设施进行通信的分布式应用(Web、电子商务、社交网络等等)

- 通信基础设施为 APP 提供通信服务(无连接不可靠服务、面向连接的可靠服务)

网络结构

- 网络边缘

- 主机

- 应用进程(客户端和服务器)

- 网络核心

- 互联着的路由器

- 网络的网络

- 接入网、物理媒体

- 有线或者没线通信链路

网络边缘

组成:端系统(主机):运行应用进程(Web、email)

-

客户端/服务器模式(服务器是主,客服端是从)

客户端向服务器请求、接收服务(Web浏览器/服务器)

-

对等模式(p2p)

端点既是客服端也是服务器(去中心化的分布式服务)

采用网络设施的面向连接服务

目标:在端系统之间传输数据

TCP 服务

HTTP、FTP、Telnet、SMTP

- 可靠地、按顺序地传送数据(确认和重传)

- 流量控制(发送方不会淹没接收方)

- 拥塞控制(当网络拥塞时候,发送方降级发送速率)

UDP 服务

流媒体、远程会议以及DNS等等

- 无连接

- 无可靠数据传输

- 无流量控制

- 无拥塞控制

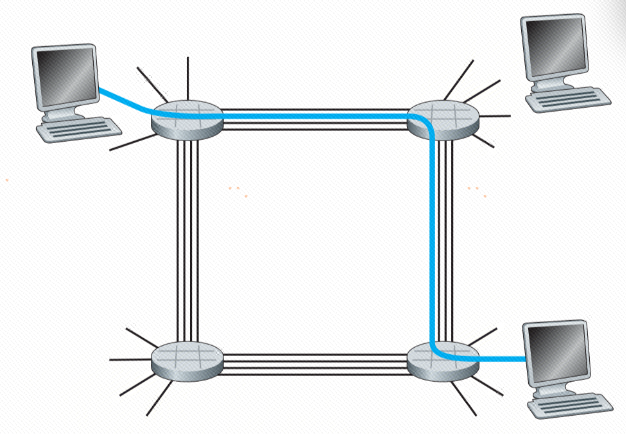

网络核心

路由器的网状结构

网络的核心的关键功能

- 路由:决定分组采用的源到目标的路径(路由算法)

- 转发:将分组从路由器的输入链路转移到输出链路上

电路交换

为每个呼叫预留一条专有电路,如电话网

端到端的资源被分配给从源端到目标端的呼叫(通常被传统电话网络采用)

独享资源(不同享):每个呼叫一旦建立起来就能够保证性能,如果呼叫没有数据发送,被分配的资源就会被浪费

网络资源(如带宽)被分成片

-

频分多路复用(有线电视网络、无线广播等)

- 原理:FDM 将整个传输频带分割成多个独立的子频带,每个子频带分配给一个信号传输使用

- 特点:各个信号在整个传输过程中占用固定的频带,互不干扰

-

时分多路复用(电话网络、数字传输系统等)

- 原理:TDM 将时间分割成一系列的时隙,每个信号在分配给它的时间时隙中传输

- 特点:所有信号共享相同的频带宽度,但在不同的时间传输

-

波分多路复用(长途光纤通信、数据中心内部网络等)

- 原理:WDM类似于频分多路复用,但在光纤通信中,它使用不同的波长(频率)来区分不同的信号

- 特点:每个信号分配一个独特的波长,可以在同一条光纤上同时传输

电路交换不适合计算机之间的通信

- 建立的连接的时间长

- 计算机之间的通信有突发性,如果使用线路交换,则浪费的片较多(独享)

分组交换

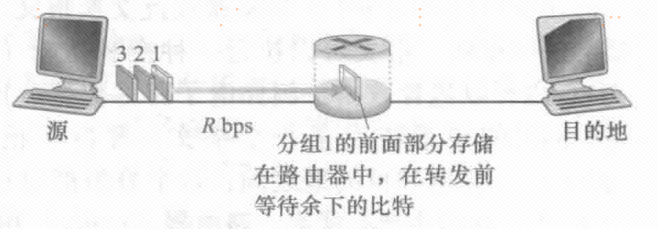

概述

以分组为单位存储-转发方式

- 被传输到下一个链路之前,整个分组必须达到到达路由器/链路层交换机:存储-转发

- 在一个速率为 R bps 的链路上,一个长度为 L bit 的分组的存储转发延时为 L/R s

排队时延和分组丢失

- 如果到达的分组需要传输到某条链路,但发现该链路正忙于传输其他分组,该到达分组必须在输出缓存中等待。因此,除了存储转发时延以外,分组还要承受输出缓存的排队时延

- 如果路由器的缓存用完了,分组将会抛弃,这就是分组丢失

转发表和路由选择协议

- 转发表:用于记录目的地址(或目的地址的一部分)映射输出链路地址的表

- 路由选择协议:用于自动地设置这些转发表。例如,一个路由选择协议可以决定从每台路由器到每个目的地的最短路径,并使用这些最短路径结果来配置路由器中的转发表

按照有无网络层的连接

数据报网络 (类似:问路 )

- 分组的目标地址决定下一跳

- 在不同的阶段,路由可以改变

- Internent

虚电路网络

- 每个分组都带标签(虚电路标识 VCID),标签决定下一跳

- 在呼叫建立时决定路径,在整个呼叫中路径保持不变

- 路由器维持每个呼叫的状态信息

分组交换 VS 电路交换

- 分组交换允许更多的用户,适用于突发式传输,但是会排队延迟以及会出现丢包现象

- 分组交换按需分配链路使用。链路传输能力将在所有需要在链路上传输分组的用户之间逐分组地被共享

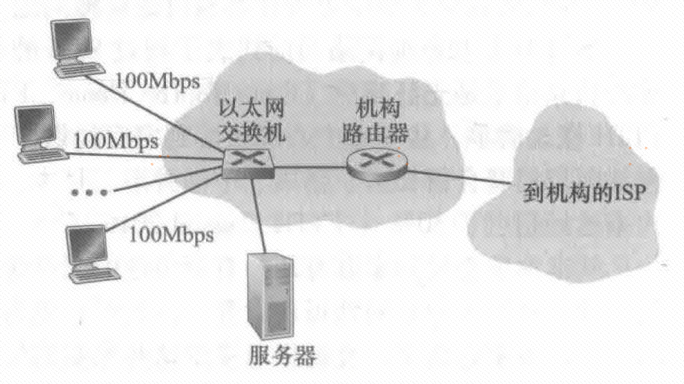

接入网

怎样将端系统和边缘路由器连接?

- 住宅接入网络

- 单位接入网络 (学校、公司)

- 无线接入网络

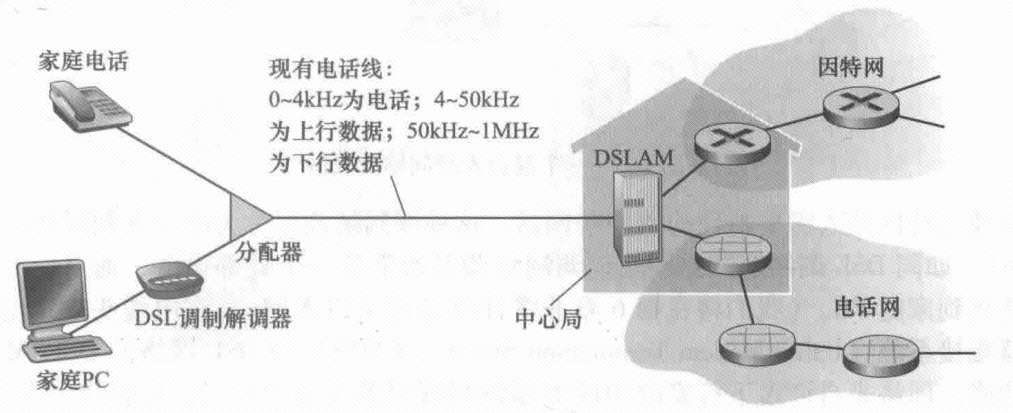

DSL 因特网接入

DSL 数字用户线,住户通常从提供本地电话接入的本地电话公司处获得DSL因特网接入

- 高速下行信道,位于50kHz到1MHz频段

- 中速上行信道,位于4kHz到50kHz频段

- 普通的双向电话信道,位于0到4kHz频段

当使用DSL时,用户的本地电话公司也是它的 ISP。每个用户的 DSL调制解调器使用现有的电话线(即双绞铜线)与位于电话公司的本地中心局(CO)中的数字用户线接入复用器(DSLAM)交换数据

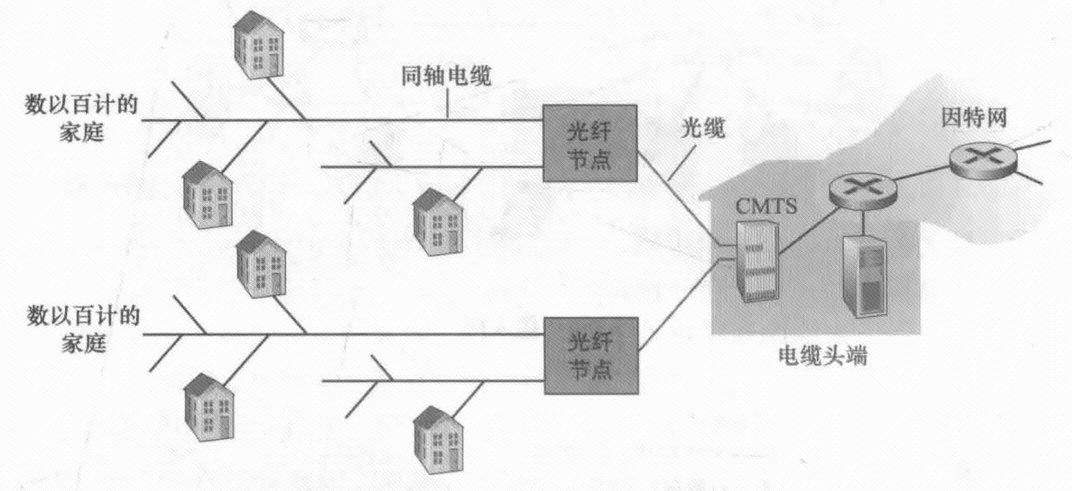

电缆因特网接入

利用了有线电视公司现有的有线电视基础设施。住宅从提供有线电视的公司获得了电缆因特网接入

电缆调制解调器通常是一个外部设备,通过一个以太网端口连接到家庭PC在电缆头端,**电缆调制解调器端接系统(Cable Modem Termination System,CMTS)**与DSL网络的DSLAM具有类似的功能,即将来自许多下行家庭中的电缆调制解调器发送的模拟信号转换回数字形式

注意:与DSL不同,DSL每个用户一个专用线路到CO,电缆因特网接入的各用户共享到线缆头端的接入网络

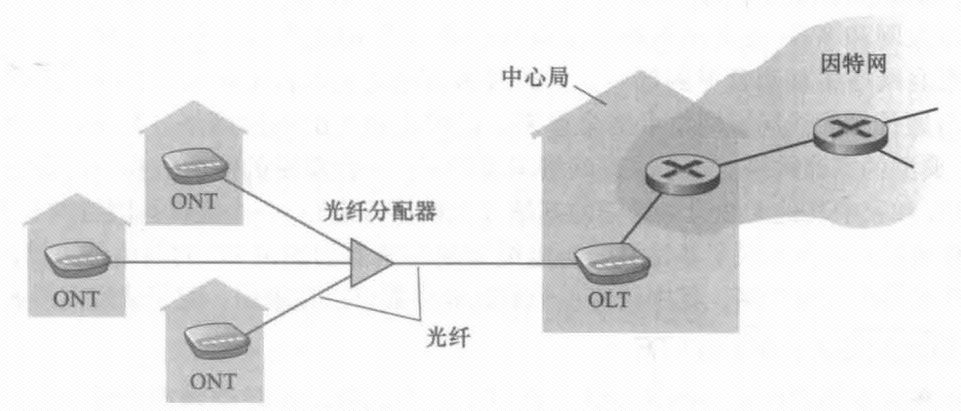

光纤到户 FTTH

一种提供更高速率的新兴技术是光纤到户(Fiber To The Home,TTH)。顾名思义FTTH概念简单,从本地中心局直接到家庭提供了一条光纤路径

无线接入网络

在无线LAN环境中,无线用户从/到一个接入点发送/接收分组,该接入点与企业网连接(很可能使用了有线以太网),企业网再与有线因特网相连。一个无线LAN用户通常必须位于接入点的几十米范围内

物理媒体

物理媒体分成两种类型:导引型媒体和非导引型媒体

导引型媒体

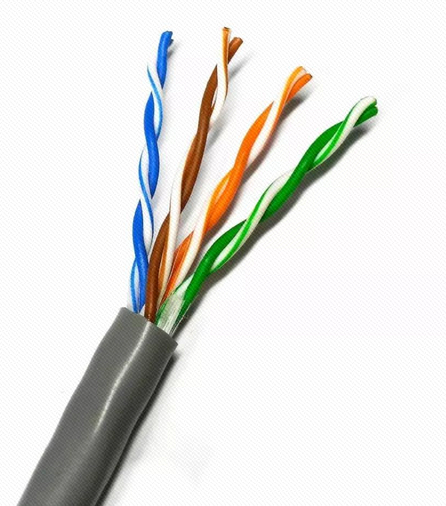

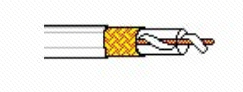

信号沿着固体媒介被导引:同轴电缆、光纤、双绞线

双绞线

两根绝缘铜导线拧合

同轴电缆

两根同轴的铜导线,双向

- 基带电缆: 电缆上一个单个信道 ;Ethernet

- 宽带电缆: 电缆上有多个信道 ; HFC

光纤和光缆:

光脉冲,每个脉冲表示一个 bit,在玻璃纤维中传输

- 高速,点到点的高速传输(如10 Gps-100Gbps传输速率 )

- 低误码率,在两个中继器之间可以有很长的距离,不受电磁噪声的干扰

- 安全

非导引性媒体

开放的空间传输电磁波或者光信号,在电磁或者光信号中承载数字数据

开放空间传输电磁波,携带要传输的数据

- 无需物理“线缆”

- 双向

- 传播环境效应:反射、吸收 、干扰

无线链路类型

地面微波

- e.g. up to 45 Mbps channels

LAN (e.g., WiFi)

- 11Mbps, 54 Mbps,540Mbps…

wide-area

- 4G 10Mbps

- 5G 数Gbps

卫星

- 每个信道Kbps 到45Mbps (或者多个聚集信道)

- 270 msec端到端延迟

- 同步静止卫星和低轨卫星