网站邮箱后台子域名什么是核心关键词

**建议先看一些我安装VMware的教程,有些网络配置需要做一下

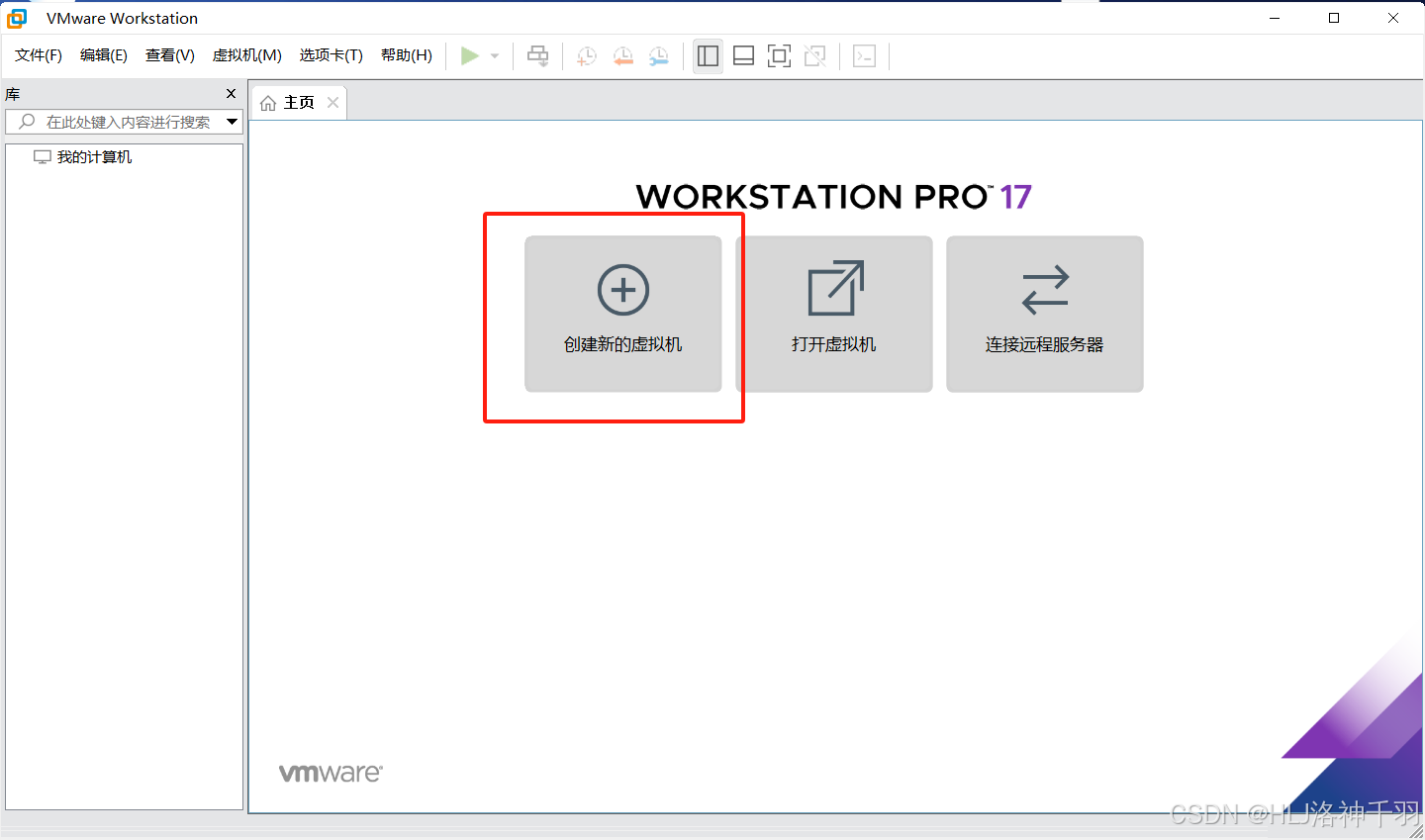

1.打开VMware,创建虚拟机

2.勾选自定义,点击下一步

3.点击下一步

4.勾选“稍后安装操作系统”,点击下一步

5.勾选linux,勾选centos7,点击下一步

6.自定义路径和名称,点击下一步

7.自行配置,点击下一步

8.自行配置,点击下一步

9.勾选NAT,点击下一步

10.如图勾选,点击下一步

11.如图勾选,点击下一步

12.如图勾选,点击下一步

13.如图勾选,点击下一步,(大小一般20就行)

14.点击下一步

15.点击完成

16.镜像文件下载

http://mirrors.ustc.edu.cn/centos/7/isos/x86_64/

17.编辑虚拟机设置

18.选中网络适配器,勾选NAT

19.选中CD/DVD,勾选ISO,选择自己下载好的镜像文件 (xxx.iso),点击确定

20.开启虚拟机

21.选择第一个,Enter

22.选择中文,点击下一步

23.点击安装位置

24.什么都不做,点击完成

25.点击网络和主机名

26.打开网络

27.点击完成

28.点击开始安装

29.点击root密码

30.都设置为root,点击2次完成,等待...

31.点击重启

32.登录

输入账号root

密码root(看不见)

输入ip addr 查看端口 192.168.30.128 (可以看我的VMware17.5.2安装教程结尾有点小配置,先关机再配置)

输入ping www.baidu.com 看看有没有网络 Ctrl+c可以关掉

有问题不用担心做下面步骤

33. 修改网络配置,输入 vi /etc/sysconfig/network-scripts/ifcfg-ens33 按回车

34.按 i 进入插入模式

35.按要求修改

其中IPADDR就是 编辑--->虚拟网络编辑器---> 子网 ip192.168.30.(128)

其中GATEWAY就是NAT设置的网关192.168.30.2

将ONBOOT=no改为yes,将BOOTPROTO=dhcp改为BOOTPROTO=static,并在后面增加几行内容:

IPADDR=192.168.200.128 #ip需要和网关一个网段

NETMASK=255.255.255.0 #子网掩码

GATEWAY=192.168.200.2 #虚拟机中网关需要和vm适配器ip同一个网段,网关需要与虚拟机网关相同

DNS1=114.114.114.114 #dns

36.按 Esc恢复正常模式,按 :wq 退出并保存

37.重启网络

service network restart

38. 输入reboot重启虚拟机

39. 登录后可以 ip addr 看看,然后ping www.baidu.com 看看

40.安装完成,如果没有网络可以 打开任务管理器---> 打开服务 --->搜索VM,如图该运行的运行