南京行业网站建设做落地页的网站

五线谱与简谱作为音乐记谱领域的两大主流系统,各自承载着深厚的历史渊源与独特的表现力,并在全球范围内被不同程度地接受和应用。尽管两者都是为了记录音乐作品中的音高和节奏信息,但其内在机制、适用范围以及学习曲线存在显著差别。下面我们来看看五线谱与简谱有什么区别,五线谱简谱混排怎么打的相关内容。

一、五线谱与简谱有什么区别

五线谱和简谱是两种不同的音乐记谱方法,它们在形式、表现力和复杂度、起源和普及程度以及唱名法和学习难度等方面有着明显的区别。

1.形式差异

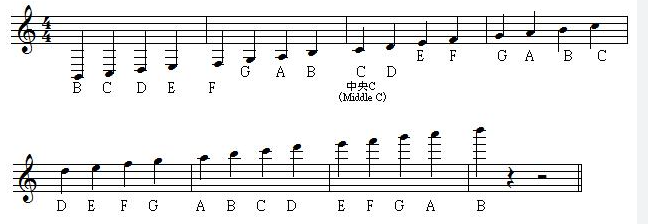

图1:五线谱

五线谱使用五条平行横线来表示音高和节奏,通过音符的位置高低和附点、休止符等音乐记号来表达。音符位置越高,音高越高;位置越低,音高越低。而简谱则采用数字来表示音阶中的音高,数字上方或下方的符号指示音高的升降和音符的时值。

2.表现力和复杂度

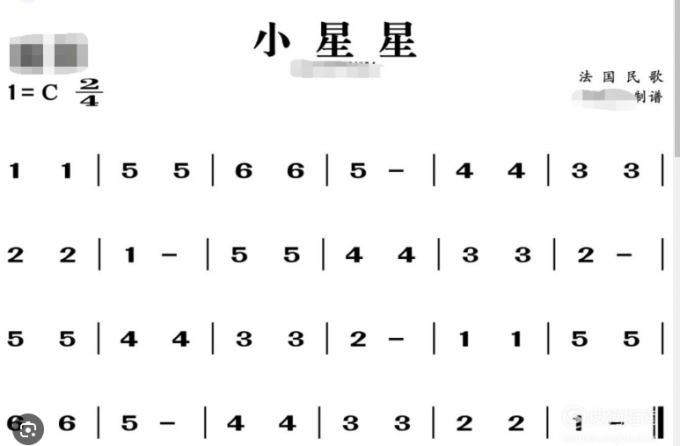

图2:简谱

五线谱因其精细的图形化表示,可以详细记录音乐元素如音高、节奏、强弱变化、速度变化、装饰音等,适用于各种类型和复杂程度的音乐作品。简谱则更适合记录单旋律和简单和弦进行的音乐,对于复杂的音乐结构和多声部音乐表现力有限。

3.起源和普及程度

图3:古五线谱

五线谱起源于古希腊,在中世纪发展成为国际上最广泛使用的标准记谱法,尤其在西方古典音乐和现代流行音乐领域广泛应用。简谱源自欧洲16世纪,在中国得到广泛应用和发展,是中国及其他一些国家和地区常见的记谱方式,尤其在民歌、通俗歌曲和初级音乐教育中使用较多。

4.唱名法和学习难度

图4:唱名

五线谱通常使用固定唱名法或首调唱名法,学习难度相对较高但提供精准的音乐信息。简谱基于首调唱名法,数字直接对应唱名,学习门槛较低但在表现复杂音乐结构时可能显得不够便捷。

二、五线谱简谱混排怎么打

五线谱简谱混排是一种乐谱设计技巧,旨在一个乐谱中同时包含五线谱和简谱,使得熟悉五线谱的演奏者和习惯使用简谱的演奏者都能轻松阅读和学习。

当需要制作一份五线谱与简谱混排的乐谱时,通常会使用专门的音乐制谱软件来进行操作,这里推荐我自己正在使用的Guitar Pro。

Guitar Pro 8中文免费安装包(Win):https://souurl.cn/IYa67P

Guitar Pro 8中文免费安装包(Mac):https://souurl.cn/ze91nQ

Guitar Pro 8激活码获取:https://souurl.cn/HewXrv

1.导入乐谱

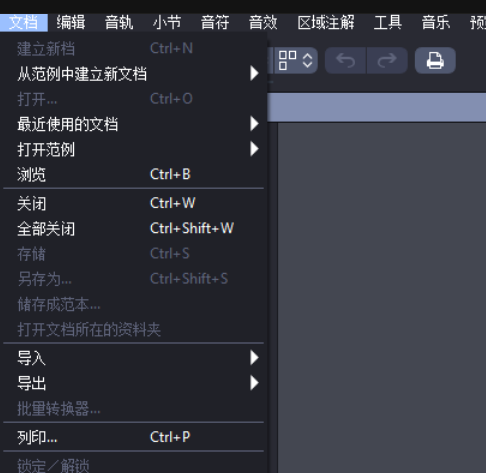

图5:文档下拉菜单

展开Guitar Pro【文档】下拉菜单,通过【打开】导入乐谱。

2.显示简谱

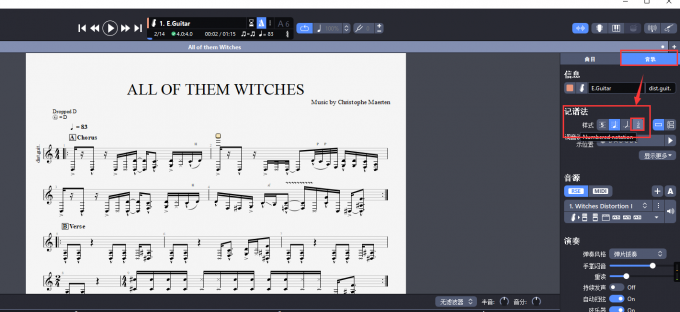

图6:音轨菜单

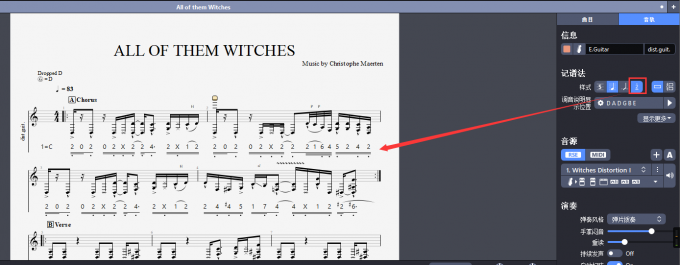

成功导入乐谱后,选择乐谱界面右侧的【音轨】,在【音轨】菜单中找到【记谱法】,直接选择【简谱】便会生成简谱、五线谱混排的情况(如图7)。

图7:混排效果

综上,五线谱与简谱虽然形式各异,各有千秋,但都在各自的领域内发挥着不可替代的作用。五线谱以其精确细致的特点胜任了多样且复杂的音乐作品记录,而简谱凭借简洁易学的优势在民间音乐和初级教学中广受欢迎。随着技术的发展,现代音乐制谱软件能够实现五线谱与简谱的混排,这里重点推荐使用Guitar Pro。