企业网站系统cms固安建设局网站

以下内容除红色字体部分之外,其他均来源于ChatGPT自动撰写。

ChatGPT是基于GPT模型的对话生成模型,旨在通过对话模拟实现自然语言交互。它是为了改善人机对话体验而设计的,主要应用于聊天机器人、智能客服等场景。

与GPT模型相比,ChatGPT在训练过程中引入了特殊的微调和优化方法,以提高在特定领域的对话生成质量和连贯性。ChatGPT在生成对话时更加注重上下文的连贯性和个性化的表达,以实现更加自然的对话体验。

ChatGPT的训练数据通常来自于实际的对话记录,例如聊天记录、社交媒体评论等。它可以通过大规模无监督学习来学习自然语言的规律和语义信息,并能够自动从数据中学习到对话的流畅性、逻辑性和语境敏感性等特征。在生成对话时,ChatGPT会利用上下文信息和语境来生成响应,从而实现更加自然、连贯的对话体验。

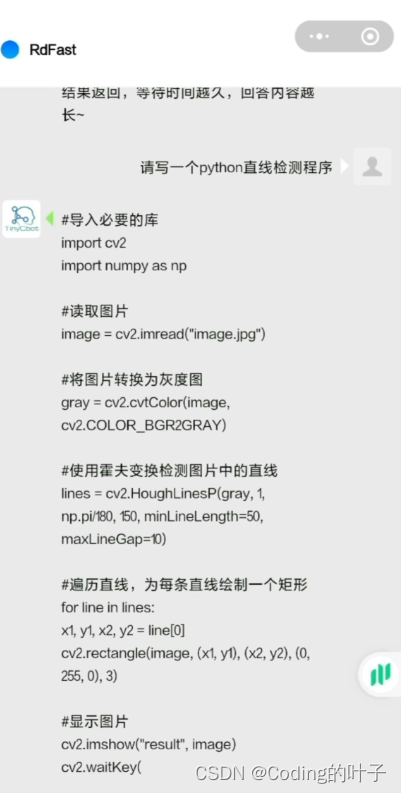

除了以上特点之外,ChatGPT可以编写程序,但当前大多GPT模型(GPT2和GPT3等)都不具备自动编程的能力。大家可以尝试一下“请用Python写一个直线检测程序。”,或者“请用C++写一个直线检测程序。”等。下面内容来源于微信小程序“RdFast智能创作机器人”,大家可直接搜索RdFast小程序,可以测试一下,也可以测试一下别的效果。

下面简单介绍一下ChatGPT模型基础,即GPT、GPT2和GPT3。

1 请介绍什么是GPT。

GPT是Generative Pre-trained Transformer的缩写,是一种基于Transformer的自然语言处理模型。它的设计目标是生成与人类语言相似的文本。GPT模型采用了预训练-微调的方法,先使用大规模语料库进行预训练,然后使用有标注数据进行微调,从而使模型能够适应特定的自然语言处理任务。

GPT模型的核心是一个多层的Transformer编码器,它可以自动学习语言的结构和规律,从而生成具有上下文连贯性和语义一致性的文本。在预训练阶段,GPT模型使用了海量的文本语料库,通过无监督学习方法学习语言的结构和规律。在微调阶段,GPT模型使用有标注的数据对模型进行微调,以适应特定的任务,如文本分类、文本生成、问答等。

GPT模型由OpenAI开发,目前已经推出了多个版本,其中GPT-3模型是目前规模最大、性能最优的版本之一,拥有数万亿个参数,可以生成高质量、多样化的自然语言文本。GPT模型在自然语言处理领域取得了很多成功,并被广泛应用于文本生成、机器翻译、语言理解等任务。

2 请介绍GPT2和GPT3的区别。

GPT-2和GPT-3都是基于Transformer的自然语言处理模型,由OpenAI开发,但它们之间有一些重要的区别。

首先,GPT-3是比GPT-2规模更大的模型,它拥有比GPT-2多得多的参数(GPT-3拥有1.75万亿个参数,而GPT-2只有1.5亿个参数),这意味着它可以处理更加复杂的自然语言任务,并且在一些特定任务上表现得更好。

其次,GPT-3引入了更多的新特性和能力,如一次性学习多种语言的能力、能够执行常见的自然语言处理任务(如翻译、摘要、问题回答、情感分析等)、生成更加多样化的文本等。相比之下,GPT-2更多地集中在单一任务的语言生成能力上。

另外,GPT-3与GPT-2相比在生成文本的质量、连贯性和逼真度上有所提高。GPT-3在许多自然语言处理的任务上都表现得非常优秀,其生成的文本质量和连贯性已经接近人类水平,这使得它在对话生成、文本自动生成、语言翻译等领域有广泛的应用前景。

总之,GPT-3相对于GPT-2在模型规模、任务能力和生成质量等方面都有所提高,这使得它成为目前自然语言处理领域中最具有代表性和最先进的模型之一。

3 请介绍ChatGPT与GPT2的区别。

ChatGPT和GPT-2是两个不同的模型,它们的主要区别在于应用场景和模型结构。

ChatGPT是一种基于GPT模型的对话生成模型,旨在通过对话模拟实现自然语言交互。它经过了特殊的微调和训练,以提高在特定领域的对话生成质量和连贯性。与GPT-2相比,ChatGPT在生成对话时更加注重上下文的连贯性和个性化的表达,以实现更加自然的对话体验。

GPT-2是一种自然语言生成模型,其设计目标是生成与人类语言相似的文本。它使用了一个12层甚至更多的变压器神经网络,能够生成高质量的自然语言文本,包括新闻、故事、诗歌等。GPT-2在文本生成方面具有很高的可扩展性和灵活性,但在对话生成方面不如ChatGPT。

总之,ChatGPT和GPT-2是两种不同类型的模型,它们的应用场景和模型结构不同,各自具有不同的优势。ChatGPT更加注重对话体验的连贯性和个性化,而GPT-2则专注于生成高质量的自然语言文本。

4 请介绍ChatGPT与GPT3的区别。

ChatGPT和GPT-3是两个不同的模型,它们的主要区别在于应用场景、模型规模和性能表现。ChatGPT是一种基于GPT模型的对话生成模型,旨在通过对话模拟实现自然语言交互。ChatGPT是针对特定领域的对话生成任务进行微调的,它在生成对话时更加注重上下文的连贯性和个性化的表达,以实现更加自然的对话体验。

GPT-3是一种自然语言生成模型,它是目前规模最大的预训练模型之一,可以生成高质量的自然语言文本,包括文章、诗歌、对话等。GPT-3的模型规模比ChatGPT大得多,拥有13亿甚至更多的参数,因此它的生成质量和多样性比ChatGPT更高。GPT-3还支持一些其他的自然语言任务,例如翻译、问答、语义搜索等。

总之,ChatGPT和GPT-3是两种不同类型的模型,它们的应用场景、模型规模和性能表现不同,各自具有不同的优势。ChatGPT更适合特定领域的对话生成任务,而GPT-3则更加强大,适用于各种自然语言任务,包括对话生成、文本生成、翻译、问答等。