遵义城乡建设网站做网站赚钱的点在哪里

一、概述

1. 概念

第三方销售和单独采购都是指接到客户订单后,客户所需产品需要向供应商进行采购,该供应商一般是指外部的供应商,特殊情况下,才可能是集团内部的其他子公司,当是集团内其他子公司时,因为如果该子公司和我方属于同一个 SAP ERP系统中,则属于跨公司销售。因此跨公司销售和第三方销售唯一区别在于,货物供应商是否跟贸易公司同属于一个SAP Client。

2. 两者差异

第三方销售和单独采购都是根据销售订单触发生成采购申请,二者之间差异如下:

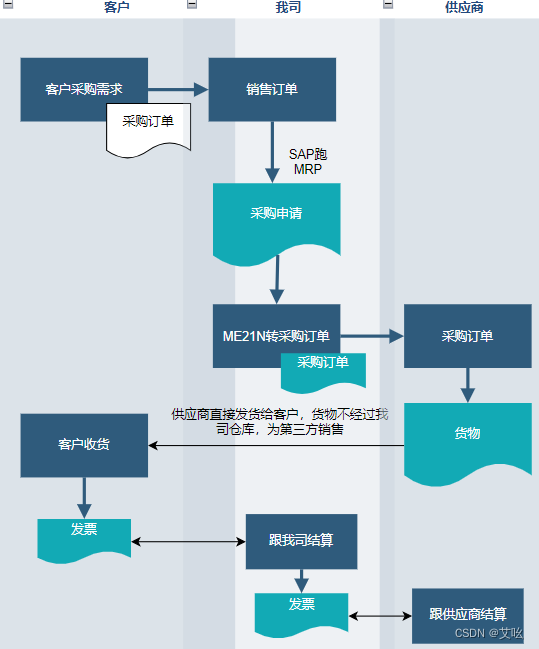

- 第三方销售(Third-Party)是指某公司接到客户的销售订单后,客户所需要的产品,直接向供应商进行采购,而后直接由该供应商负责进行送货到客户处然后供应商向我公司出具发票,我公司向客户出具发票。

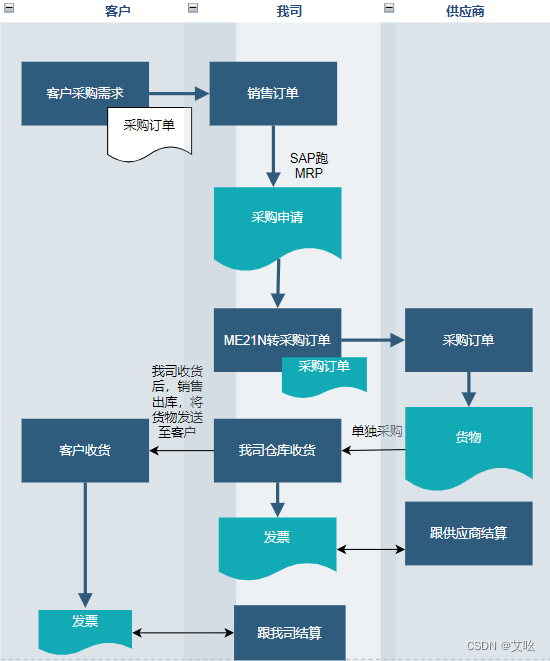

-单独采购(Individual Purchase)是指某公司接到客户的销售订单后,客户所需要的产品,直接向供应商进行采购,而后直接由该供应商负责进行送货到我方仓库,最后由我方送货到客户处或者客户自行提货。

3. 业务流程

3.1 流程概述

第三方销售及单独采购都是收到客户需求,我司创建销售订单,订单会自动创建采购申请,用户手工将采购申请转为采购订单,采购订单下给供应商。当供应商把货物送给客户后,我司参照采购订单收货,并做系统销售发货,向客户开具发票,完成销售功能。

3.2 业务流程图

单独采购

第三方销售与单独采购的唯一区别就是货物是否需要入我司仓库,若如我司仓库则为单独采购,因此单独采购也可当做标准的销售来做,即,收到客户需求,创建销售订单,跑MRP产生采购申请,采购申请转采购订单,采购订单入库,与供应商MIRO,将库存做交货单发送至客户,如此则销售和采购凭证为分开的,无关联性。

简单的业务流程图如上

4. 系统关键配置点

第三方销售订单(单独采购)和一般的销售订单的主要区别在于【计划行】,这一点由【计划行类别】决定的,而【计划行类别】又是由【项目类别】决定。

标准的第三方销售订单的【项目类别】是“TAS”,【计划行类别】是“CS”;而单独采购的【计划行类别】是“CB”。

保存销售订单时,如果包含一个或者多个第三方物料,系统会自动创建采购需求。每一个第三方物料行项目创建一个相应的采购需求行项目,系统在创建采购需求的时候,对每一个行项目自动确定一个供应商。

如果一个销售订单行项目有一个或多个计划行,系统就会按照每一个计划行创建一个采购需求行项目。

二、系统配置-第三方销售

以第三方销售为例

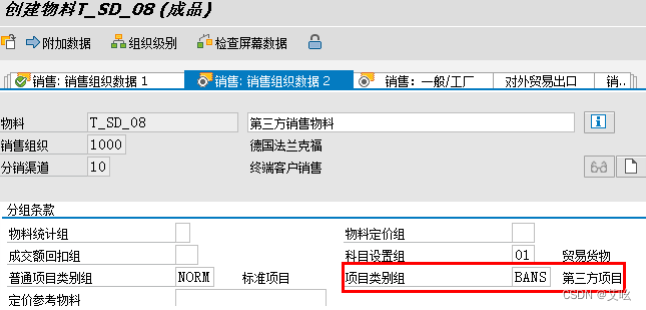

1. 物料主数据

销售视图,【项目类别组】选 BANS(该类别组为系统预设,也可以自己复制出一个项目类别组)。

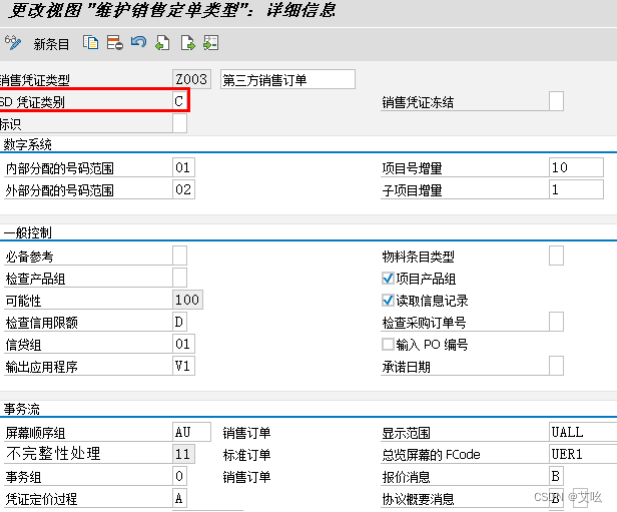

2. 销售凭证类型

参照 OR 订单类型复制 Z003。

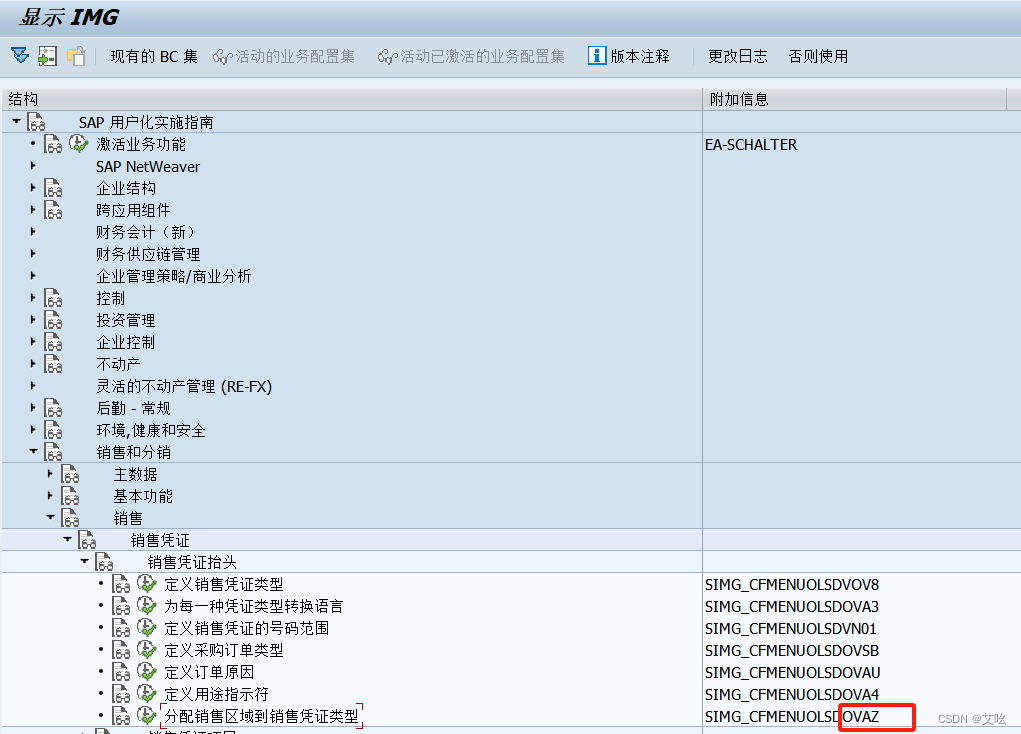

【IMG】Spro-销售与分销-销售-销售凭证-销售凭证抬头-定义销售凭证类型

没什么需要特别配置,待配置好发货类型和发票类型后,再来更改默认的【交货类型】和【开票类型】。

3. 分配销售区域到销售凭证项目类别

将新增的销售凭证 Z003 分配给销售区域 1000,10,00

4. 销售订单项目类别配置

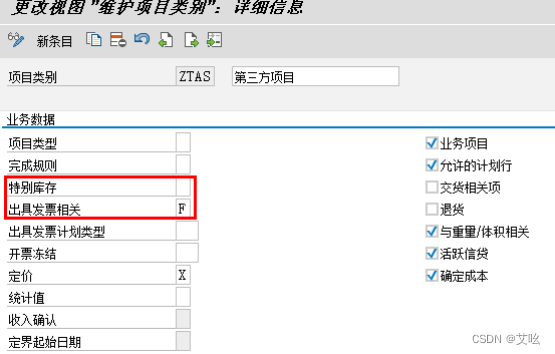

【IMG】Spro-销售与分销-销售-销售凭证-销售凭证项目-定义项目类别

参照项目类别 TAS 维护。

【出具发票相关】:选择“F”-表示参照销售订单来出具发票。

一般都是A-根据交货单开发票,因为第三方销售无需做发货单,有供应商直接送货给客户,因此按照销售订单开票。

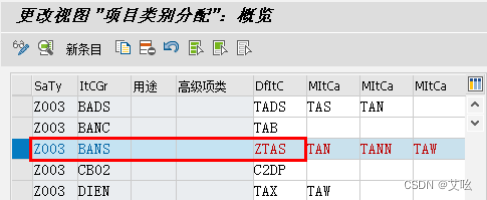

5. 分配项目类别

根据【销售凭证类型】+【项目类别组】(物料主数据)确定项目类别。

【IMG】SPRO-销售与分销-销售-销售凭证-销售凭证项目-分配项目类别

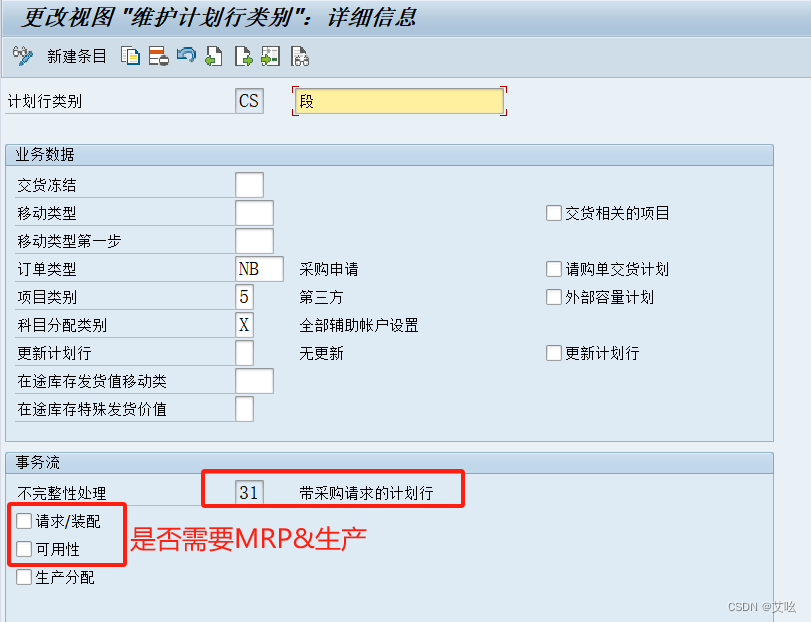

6. 定义计划行类别

【IMG】SPRO-销售与分销-销售-销售凭证-计划行-定义计划行类别

行项目类别分两种

CS(段):第三方销售。不需要做销售交货。

CB(单独采购订单):需要采购收货、销售交货。

在本例中,我们不做采购收货,所以参照 CS 来生成。

【移动类型】:如果行项目需要创建交货,这里维护交货的移动类型。

【订单类型】:采购申请的订单类型。

【项目类别】:指的是采购申请中的项目类别。

【科目分配类别】:采购申请中的类别

【与交货有关的项】:如果要创建交货单,必需选上这个勾。

【请购单交货计划】:如果要 MIGO 收货,建议勾上。

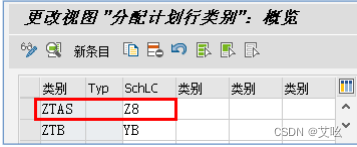

按照CS复制一个计划行Z8

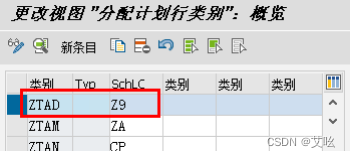

7. 分配计划行类别

【IMG】SPRO-销售与分销-销售-销售凭证-计划行-分配计划行类别

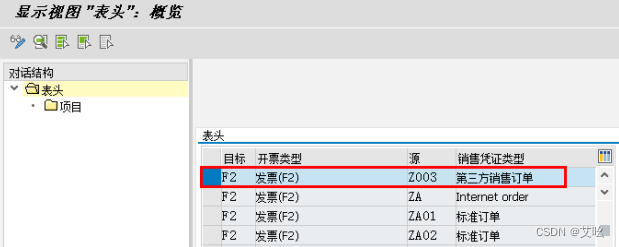

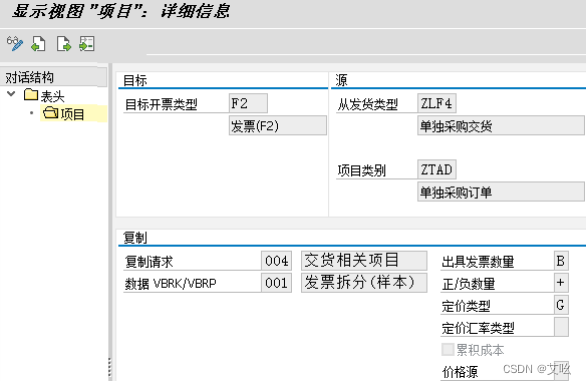

8. 为发票指定复制控制

发票使用默认的 F2 发票类型,也可以自己新增一个。

【IMG】SPRO-销售与分销-开票-开票凭证-维护开票凭证的复制控制 - (销售凭证到出具发票凭证)

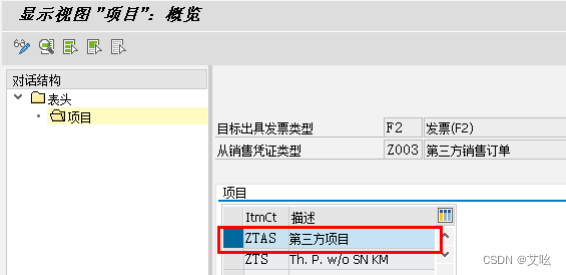

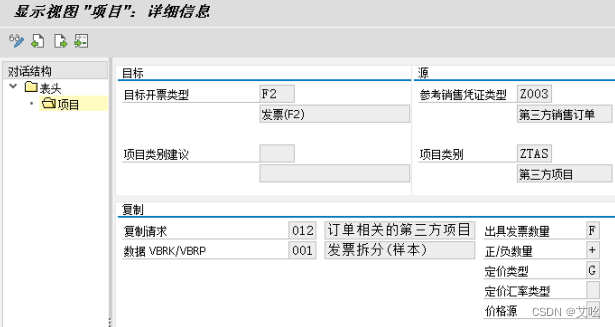

双击项目

双击【ZTAS 第三方项目】。

至此系统配置完成。

三、业务实操

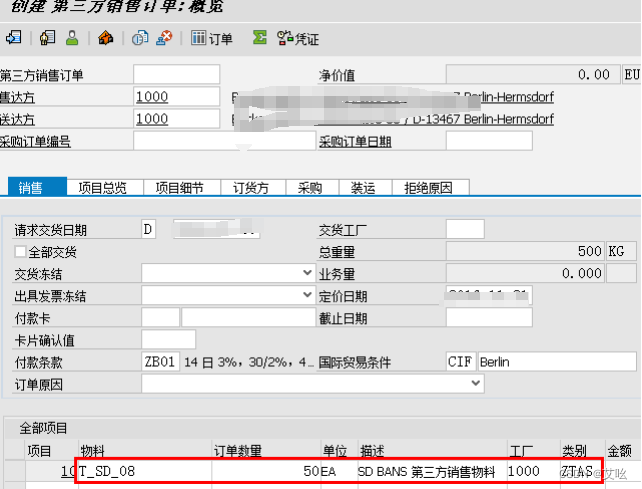

1. 创建销售订单

VA01 创建销售订单。

回车,进入凭证录入对话框,输入物料编码、订单数量、工厂。

回车,系统自动调出界面,要求输入【采购组】(也可以在物料主数据中配置默认的采购组。

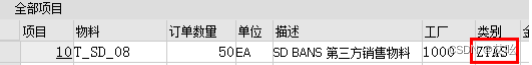

返回项目明细界面,【项目类别】是“ZTAS”。

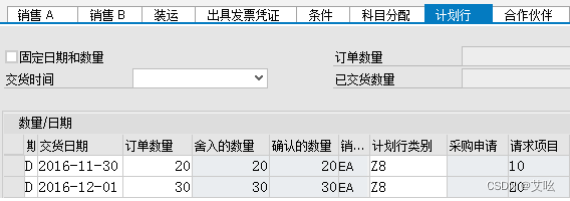

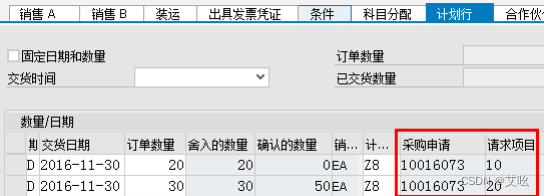

如下图所示,我们创建两个计划行,【计划行类别】为“Z8”。

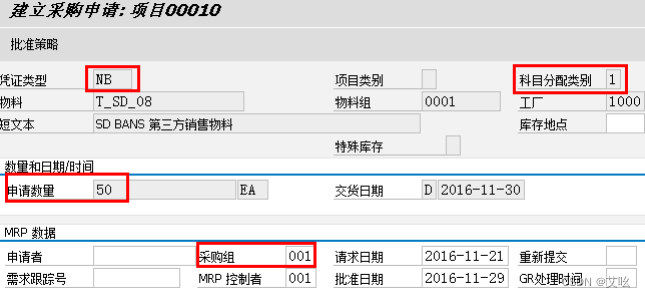

保存销售订单,VA02 查看销售订单,打开计划行界面,可以发现,能查到对应的【采购申请】。同一个申请,两个行项目。

2. 查看采购申请

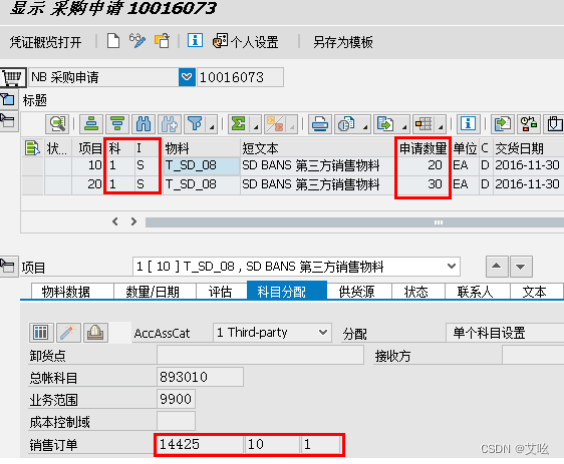

ME53N 查看采购申请。如下图,两个行项目,可以看到每一行对应的销售订单号、项目号、计划行号。

自动创建的【采购申请】不能手工删除,对销售订单的计划行删除后,对应的【采购申请】行项目会被自动标识删除标识

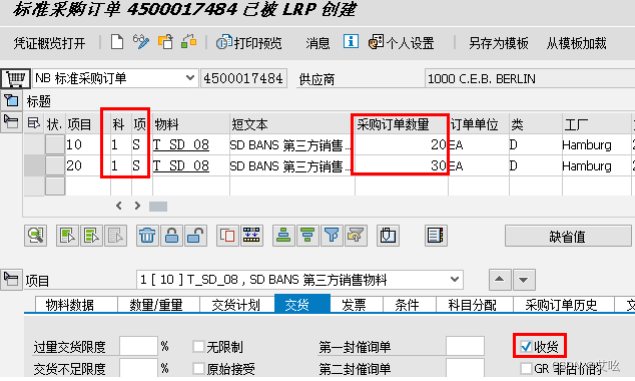

如下可以看到采购申请的交货地址是最终客户。

3. 创建采购订单

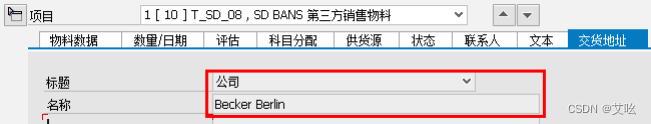

ME21N 创建采购订单。在行项目中,要勾选【收货】。

虽然选了收货,但 MIGO 并不会产生库存。如果不选【收货】VF01 将无法生成发票。

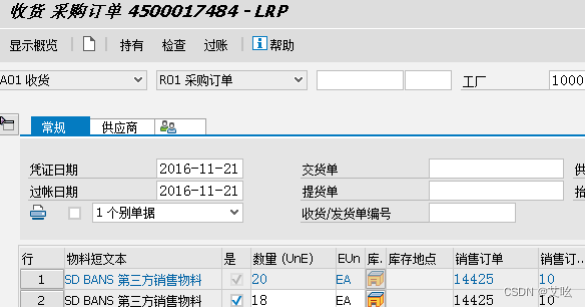

4. 采购收货

MIGO 进行收货。

如下图,其中一个行项目只收 18,部分收货。

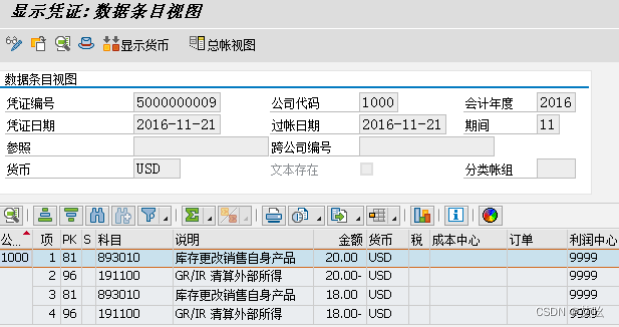

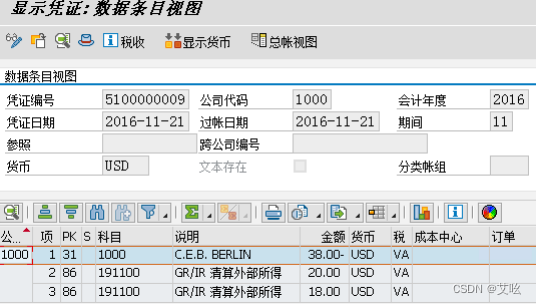

收货生成的会计凭证如下图所示:

收货时财务凭证:

借:主营业务成本(常规的是库存商品—有库存增加)

贷:采购应付暂估

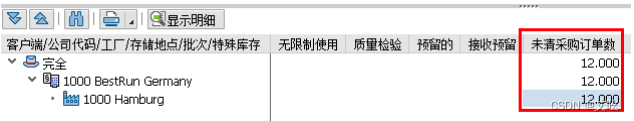

5. 库存查询

MMBE 查看库存。

如下图所示,可以看到未清的采购订单数。 并没有收货的 38 个库存。

或者MB51查库存

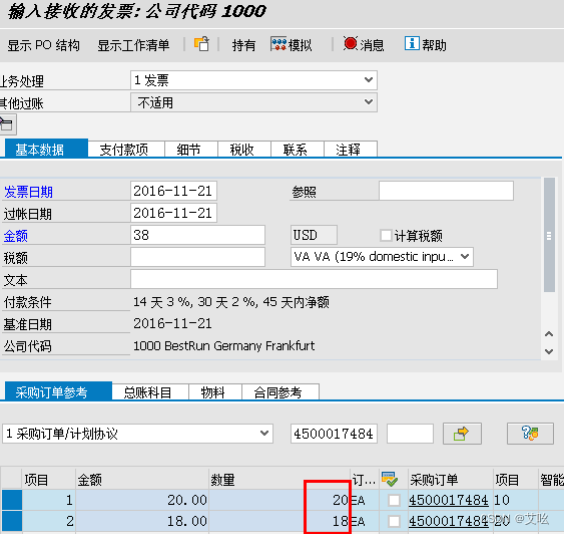

6. 采购开票

MIRO 对已收货部份开具采购发票,在这里我们只开 38 个数量。

采购发票对应的会计凭证如下所示:

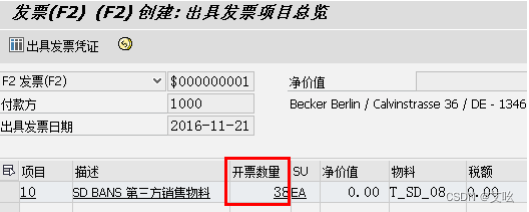

7. 销售开票

VF01 进行销售开票,输入销售凭证号码。

如下图看到,销售发票参照的是采购发票的数量。如果不开采购发票,销售发票无法开具。

四、系统配置-单独采购

系统配置主要的不同点在于:单独采购会先将货物收到我司仓库,再销售出库,因此行项目类别需要指定库存、计划行类别需要配置移动类型和交货相关,另外需要定义交货单相关的(交货类型、交货行类别、复制控制),有交货因此开票可通过交货开。

此处我们还是老规矩,从头到尾配置一遍,加深记忆

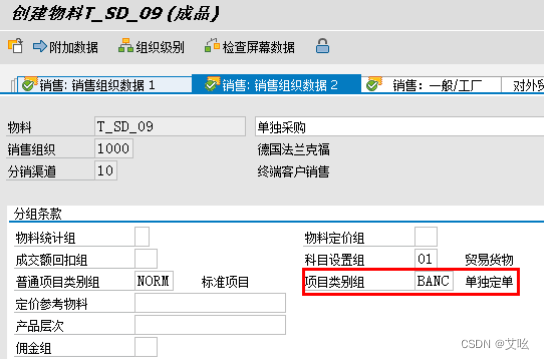

1. 物料主数据

销售视图,【项目类别组】选 BANC(也可以自己复制出一个项目类别组)。

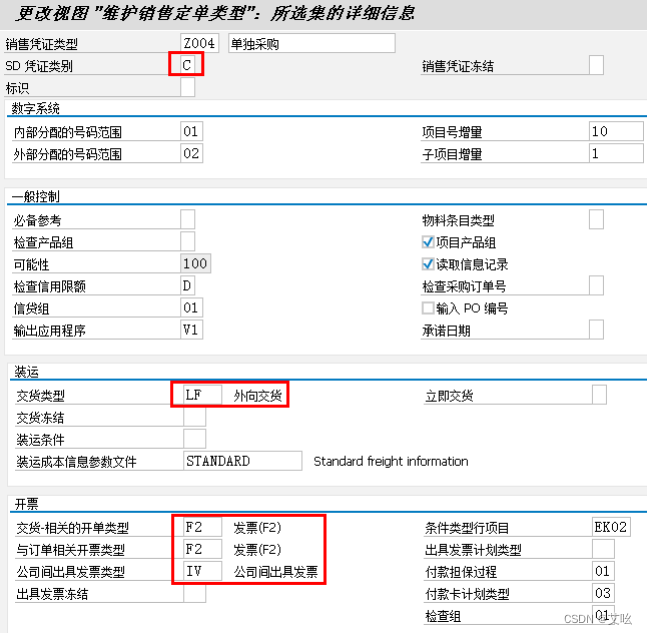

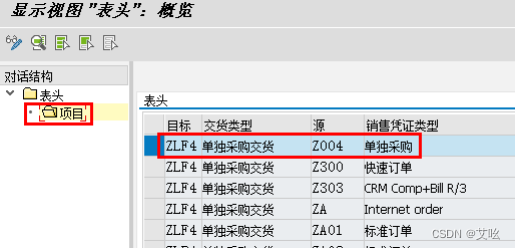

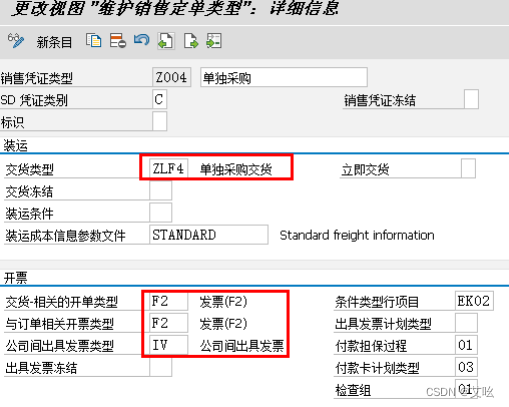

2. 销售凭证类型

参照 OR 订单类型复制 Z004。

【IMG】SPRO-销售与分销-销售-销售凭证-销售凭证抬头-定义销售凭证类型

3. 分配销售区域到销售凭证

复制销售类型,这一步一般默认也会复制,不需要手工分配。

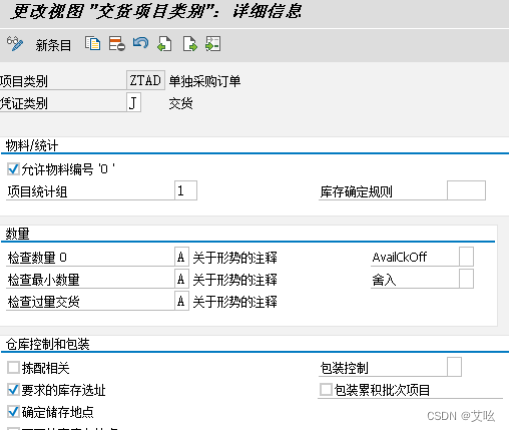

4. 销售订单项目类别配置

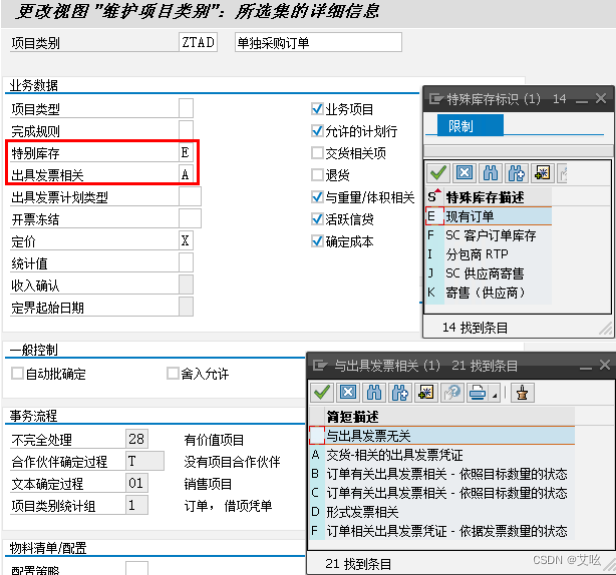

【IMG】SPRO-销售与分销-销售-销售凭证-销售凭证项目-定义项目类别

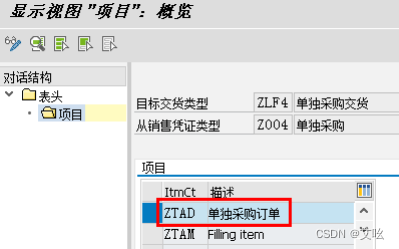

参照项目类别 TAB 维护,生成一个新的项目类别 ZTAD。

【特别库存】:选 E。表示收到订单库存。库存只针对这张订单。

【出具发票相关】:维护成 A-意思是参照发货来创建发票.

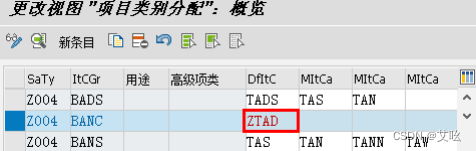

5. 分配项目类别

根据【销售凭证类型】+【项目类别组】(物料主数据)确定项目类别。

【IMG】SPRO-销售与分销-销售-销售凭证-销售凭证项目-分配项目类别

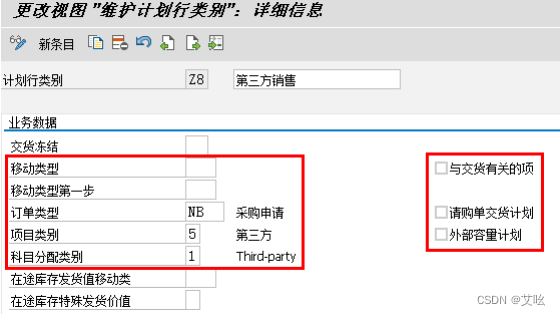

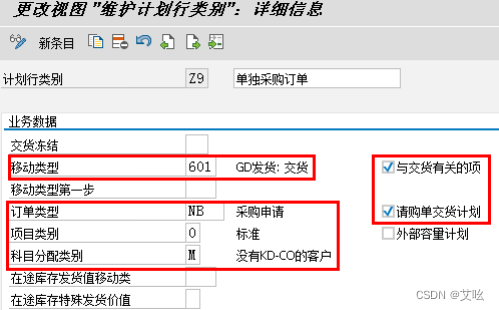

6. 定义计划行类别

【IMG】SPRO-销售与分销-销售-销售凭证-计划行-定义计划行类别

行项目类别分两种

CS(段):第三方销售。不需要做采购收货、销售交货。

CB(单独采购订单):需要采购收货、销售交货。

在本例中,我们需要做采购收货,所以参照 CB 来生成。

【移动类型】:如果行项目需要创建交货,这里维护交货的移动类型。

【订单类型】:采购申请的订单类型。

【项目类别】:指的是采购申请中的项目类别。

【科目分配类别】:采购申请中的类别,设置为 M。

【与交货有关的项】:如果要创建交货单,必需选上这个勾。

【请购单交货计划】:如果要 MIGO 收货,建议勾上。

7. 分配计划行类别

【IMG】SPRO-销售与分销-销售-销售凭证-计划行-分配计划行类别

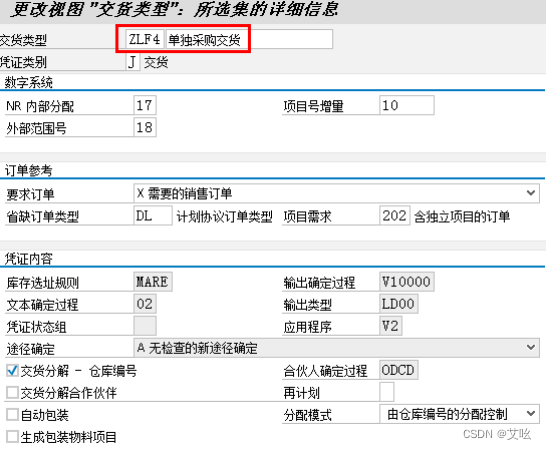

8. 定义交货类型

【IMG】SPRO-后勤执行-装运-交货-定义交货类型

参照 LF 定义一个新的交货类型,无需特别设置。

9. 定义交货的项目类别

交货项目类别参照 TAN 复制。

【IMG】SPRO-后勤执行-装运-交货-定义交货的项目类别

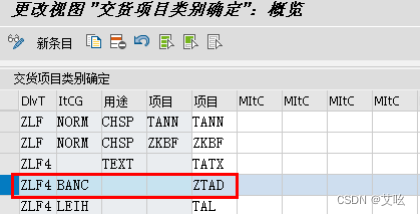

10. 在交货时定义项目类别确定

【IMG】SPRO-后勤执行-装运-交货-在交货时定义项目类别确定

11. 为交货指定复制控制

【IMG】Spro后勤执行装运复制控制为交货指定复制控制

双击项目

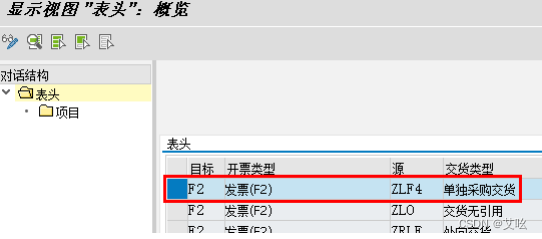

12. 为发票指定复制控制

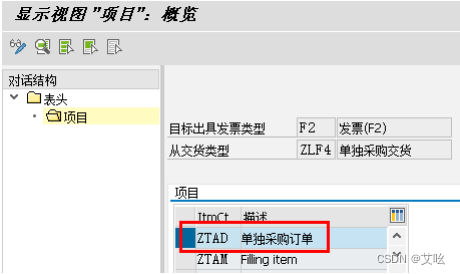

发票使用默认的 F2 发票类型,也可以自己新增一个。

Spro销售和分销开票开票凭证维护开票凭证的复制控制 (交货到出具发票凭证)

双击【项目】

双击【ZTAD 单独采购订单】。

13. 更改销售凭证类型默认的交货类型

Spro销售和分销销售销售凭证销售凭证抬头定义销售凭证类型

五、业务实操

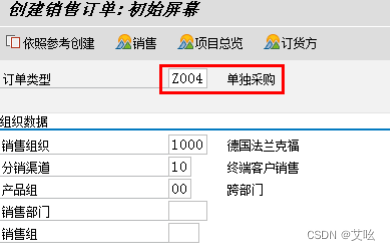

1. 创建销售订单

VA01 创建销售订单。

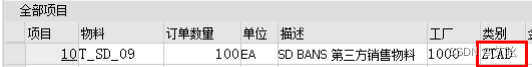

回车,输入物料编码、订单数量、工厂。

回车,系统自动调出界面,要求输入【采购组】(也可以在物料主数据中配置默认的采购组。

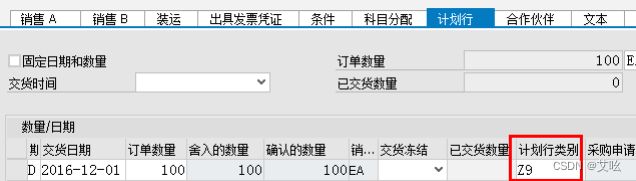

返回项目明细界面,【项目类别】是“ZTAD”。 如下图所示,我们创建计划行,【计划行类别】为“Z9”。

如下图所示,我们创建计划行,【计划行类别】为“Z9”。

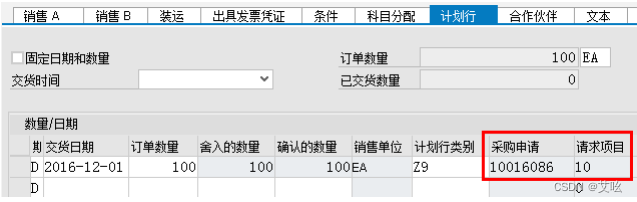

保存销售订单,VA02 查看销售订单,打开计划行界面,可以发现,能查到对应的【采购申请】。

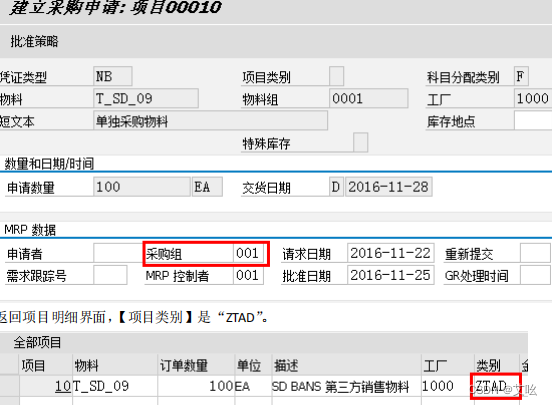

2. 查看采购申请

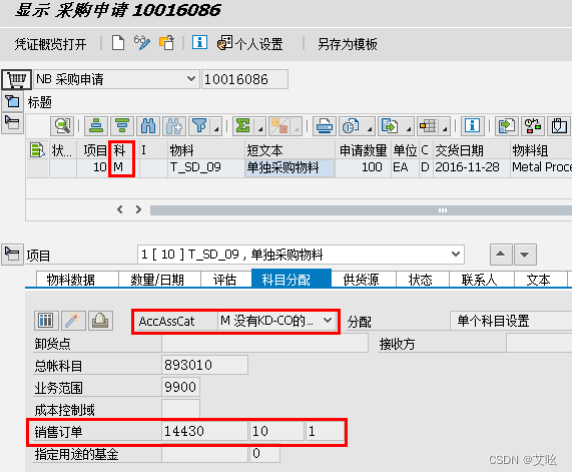

ME53N 查看采购申请。如下图所示,看到对应的销售订单号、项目号、计划行号。

自动创建的【采购申请】不能手工删除,对销售订单的计划行删除后,对应的【采购申请】行项目会被自动标识删除标识。

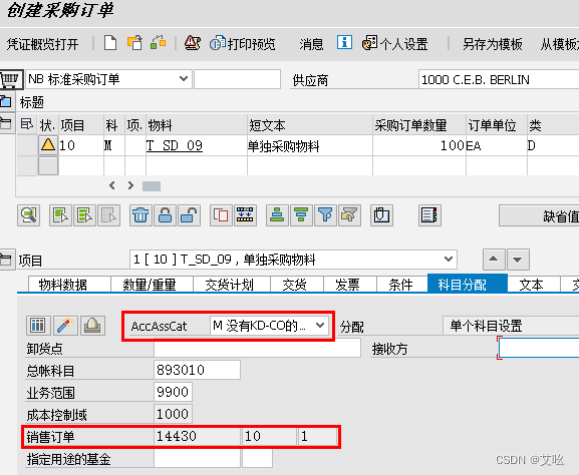

3. 创建采购订单

ME21N 创建采购订单。在行项目中,要 勾选【收货】。如果是不需要收货的模式,这里可以不勾。

4. 采购收货

MIGO 进行收货。

如下图,部分收货。

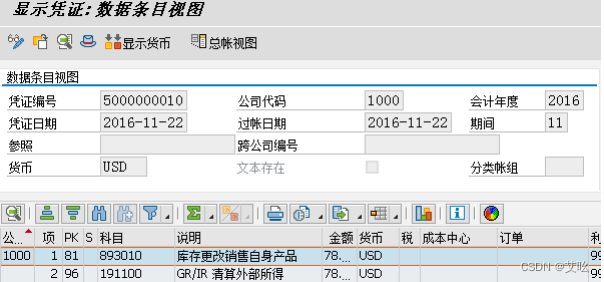

查看对应会计凭证如下:

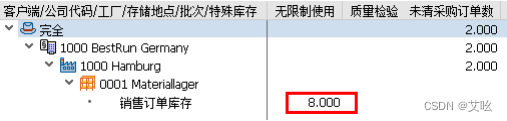

5. 库存查询

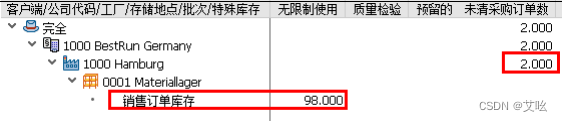

MMBE 查看库存。

如下图所示,可以看到这个销售订单的库存。

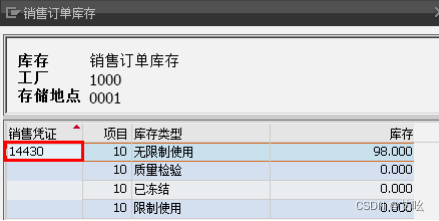

如下,库存是挂在销售订单下。

6. 销售交货

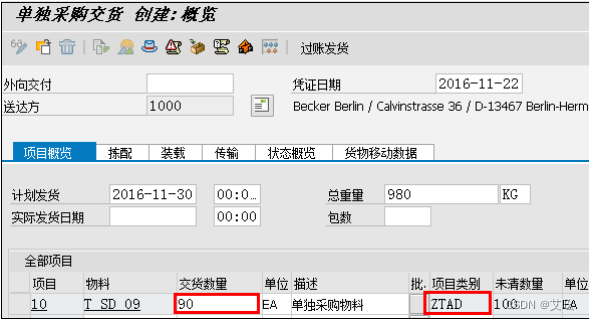

VL01N 进行创建销售交货单。

在这我们只创建 90 个数量的交货。过帐发货,创建发货凭证,扣减库存。

过账后重新查库存,库存已扣减

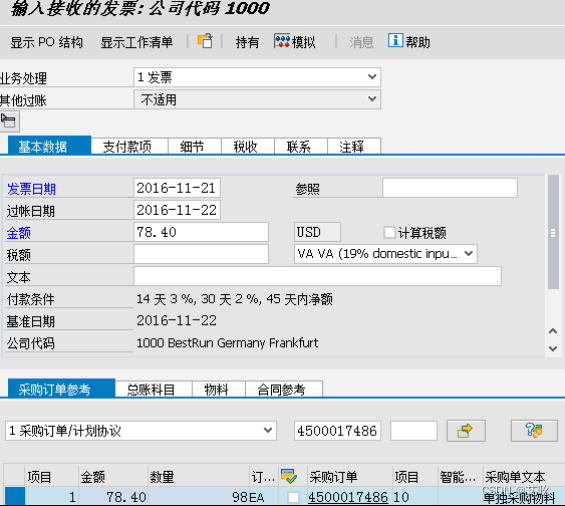

7. 采购开票

MIRO 开具采购发票,在这里我们只开 98 个数量。

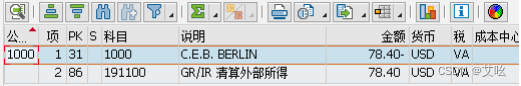

对应会计凭证如下

8. 销售开票

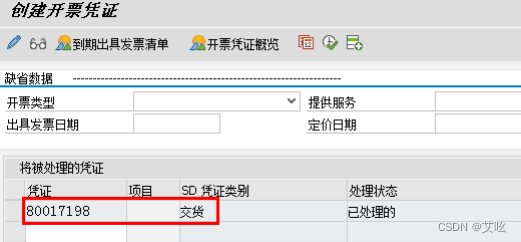

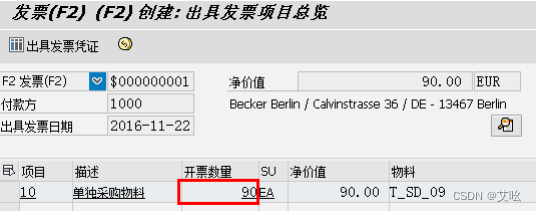

VF01 进行销售开票,输入交货单号

如下图看到,销售发票参照的发货单的数量。

最终的凭证流为: