网站建设与网站维护wordpress图片切换

1. 首先,我们需要安装和配置xinetd,安装的具体命令如下:

sudo apt-get install xinetd

2. 新建tftp工作目录,并添加读、写、执行权限(没有权限后面无法正常访问该文件夹),如下图所示。

![]()

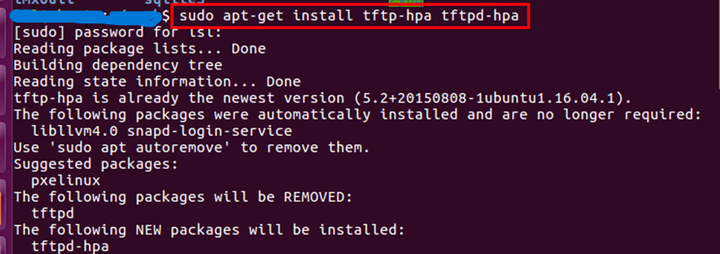

3. 安装 tftp-hpa 和 tftpd-hpa 服务程序,其命令如下图所示。

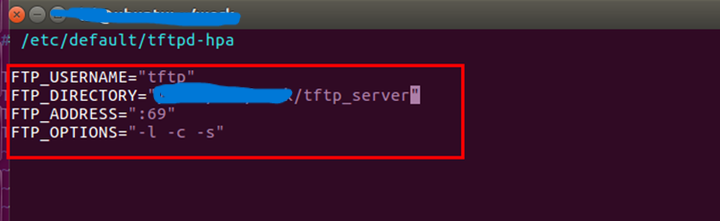

4. 打开 tftpd-hpa 配置文件,修改 tftp 目录为 TFTP 服务器工作目录,具体的命令以及细节如下:

sudo vi /etc/default/tftpd-hpa

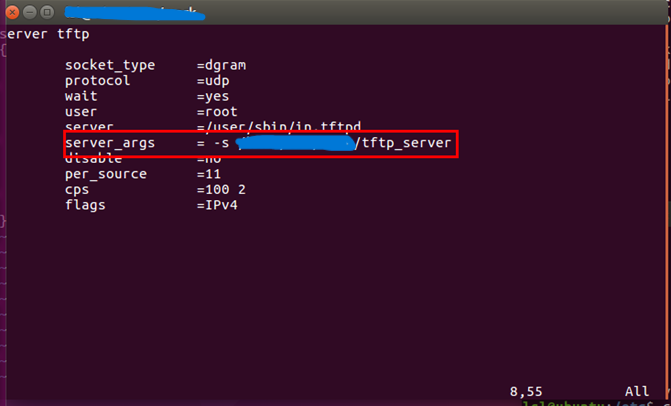

5. 执行以下指令打开/etc/xinetd.d/tftp 文件, 配置/etc/ xinetd.d/tftp 文件,将 tftp 路径设置为tftp服务目录。命令如下:

sudo vi /etc/xinetd.d/tftp

6. 重启服务

sudo service tftpd-hpa restart

sudo service xinetd restart