大型网站建设制作东莞网站建设总部地址

别问我都2202年了为什么还在用雷电4安卓7。我特么哪知道Xposed的相关资料这么难找啊,只能搜到一些老旧的资料,尝试在老旧的平台上实现了。

最初的Xposed框架现在已经停止更新了,只支持到安卓8。如果要在更高版本的安卓系统上使用Xposed得看看Xposed的分支EdXposed或者LSPosed。

我尝试在雷电9模拟器按照EdXPosed的步骤使用Magisk安装。后面卡在哪一步忘记了,反正最终没有成功,网上也没找到什么资料,然后就放弃了。

雷电4的安装步骤如下。其实跟其他教程大同小异。有一些资源不好找,我给打包起来了,免费分享:

- 下载安装雷电4模拟器,这个在官网下载就行了:https://www.ldmnq.com。我用的版本是4.0.83,不过版本应该无所谓,比我的版本新就行了。

- 下载framework sdk:https://download.csdn.net/download/tomatomas/86328376。

- 创建xposed文件夹,解压framework-xposed-v89-sdk25-x86到xposed文件夹内。

- 启动雷电模拟器,开启root权限

- 执行adb remount(adb工具需要下载,这个不懂的去查其他资料)

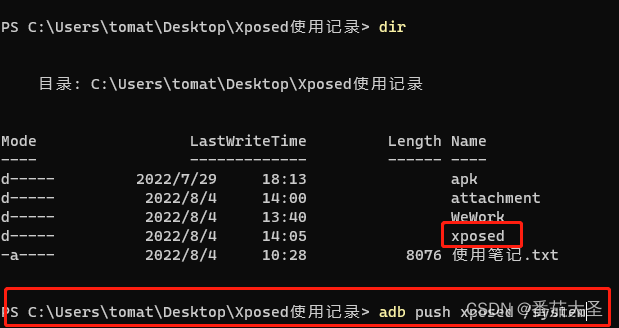

- 在xposed文件夹的上级路径下,执行adb push xposed /system,如下图。

- 执行adb shell,会进入android shell。

- cd /system/xposed。

- sh /script.sh。

- 上一步执行完之后打开XposedInstaller APP,应该可以看到xposed框架已激活。不行的话重启试试。

- 开发过程就不详说了,开发需要的XposedBridge.jar包可以在这里下载,理论上是不分版本的:https://download.csdn.net/download/tomatomas/86263817。