免费的推广网站有哪些wordpress挖主题

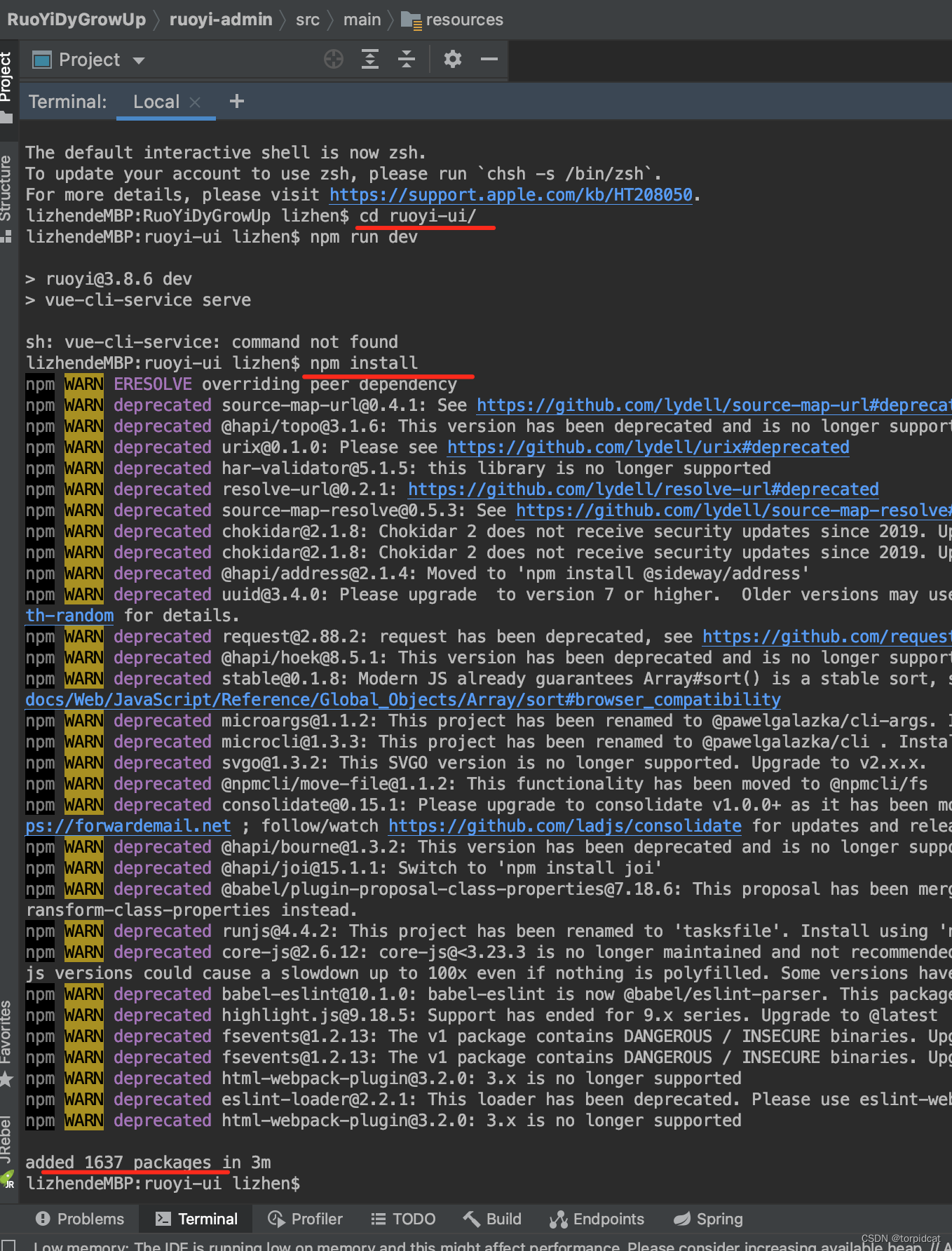

首次导入,需要先执行 npm install

#进入到前端模块目录下

cd ruoyi-ui

# 安装

npm install

启动后端项目

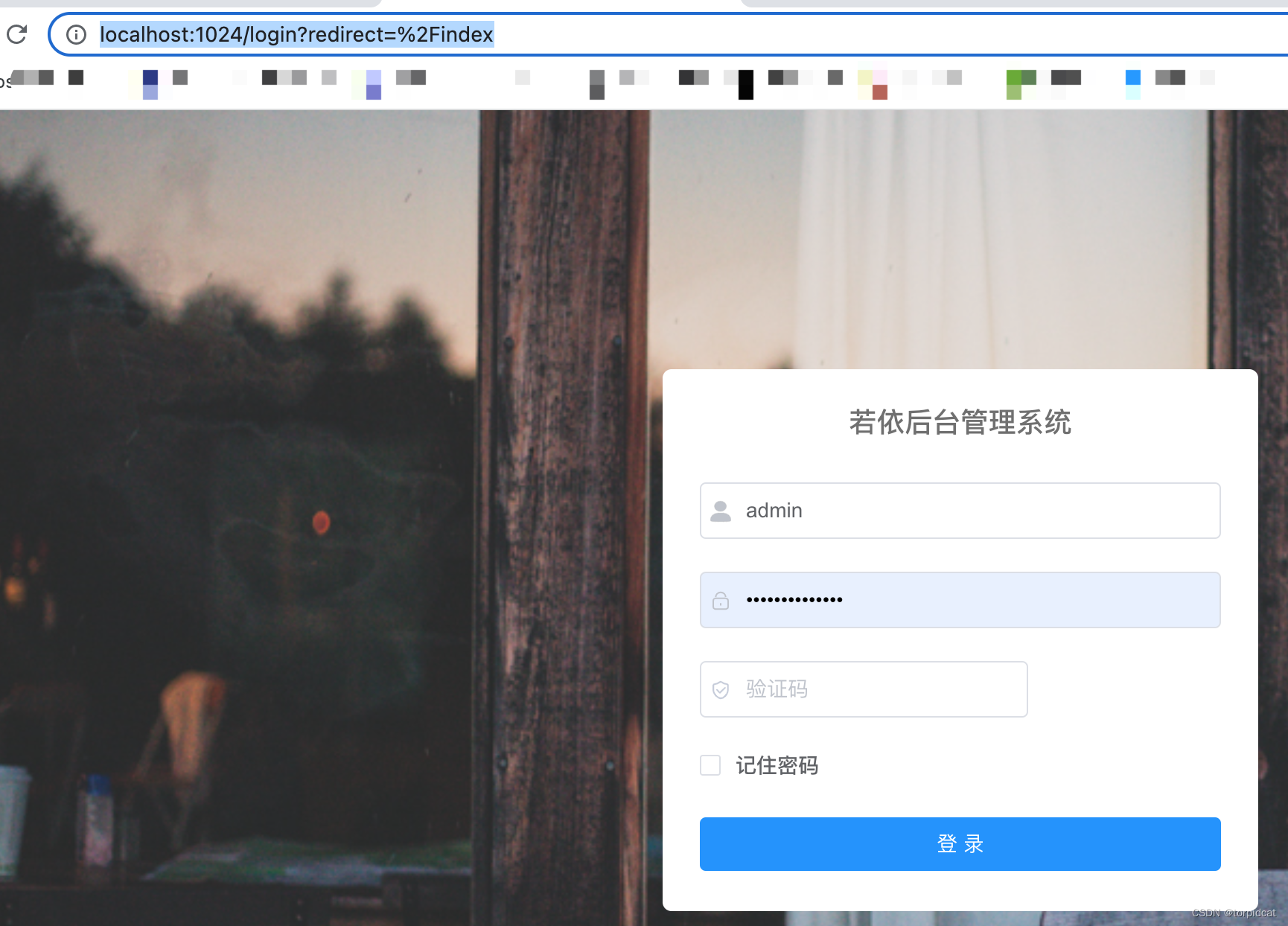

运行前端项目:运行成功后,会浏览器自动加载到前端首页(或者 浏览器访问打印的两个地址)

# 运行

npm run dev

部署:

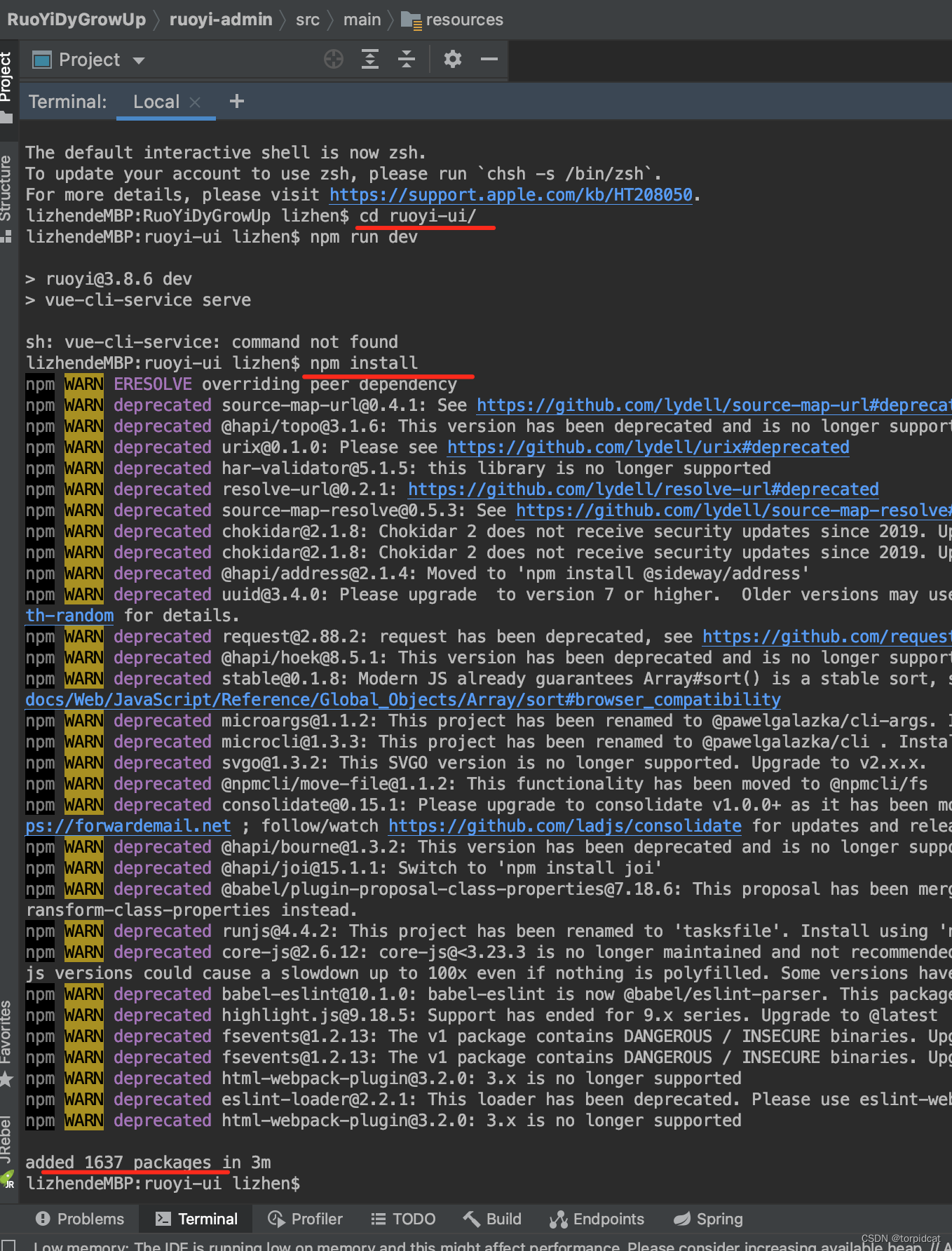

首次导入,需要先执行 npm install

#进入到前端模块目录下

cd ruoyi-ui

# 安装

npm install

启动后端项目

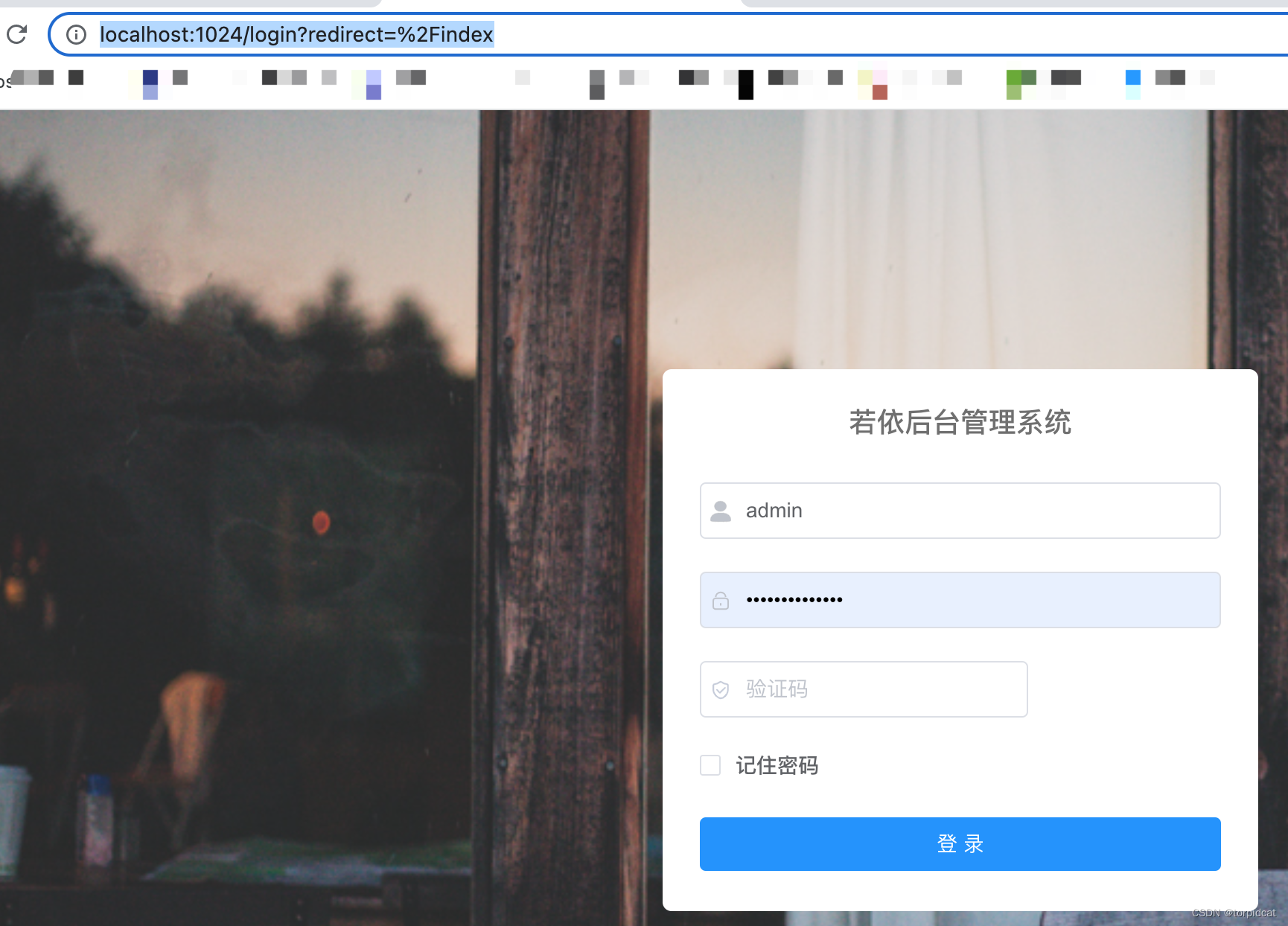

运行前端项目:运行成功后,会浏览器自动加载到前端首页(或者 浏览器访问打印的两个地址)

# 运行

npm run dev

部署: