拼多多cms网站怎么做沈阳建设工程信息网查询

大家好! 我是“声波电波还看今朝”成员的一位FAE Devin.wen,欢迎大家关注我们的账号。

今天给大家大概讲解“如何排查Qualcomm BT Audio”的疑难杂症(四):MIPS检查。

如果大家还没有注册我们大大通的账号,麻烦扫描如下的二维码来注册一下吧,方便我们后期问题讨论。

今天的内容给大家介绍在遇到音频卡顿或者静音的情况下,我们有什么好的方式去分析?

这里推荐的是首先我们就得查看芯片MIPS资源够不够,那么什么叫MIPS呢?

MIPS(Million Instructions Per Second):单字长定点指令平均执行速度 Million Instructions Per Second的缩写,每秒处理的百万级的机器语言指令数。

这是衡量CPU速度的一个指标。

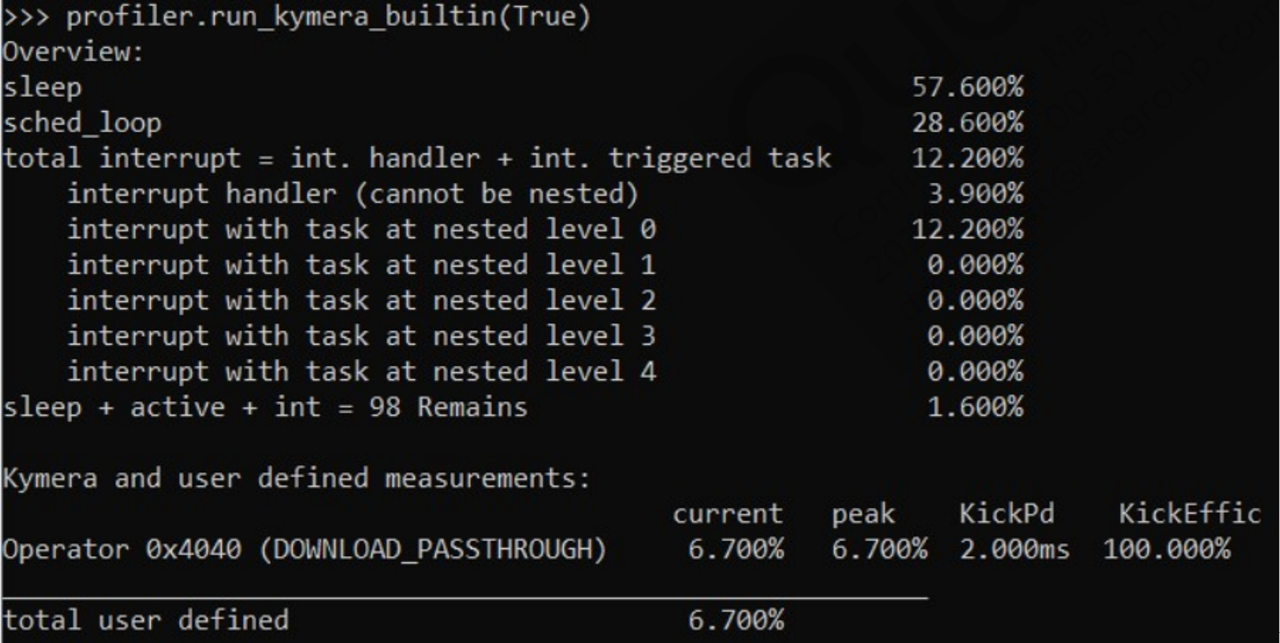

在ACAT模式下执行如下指令,就可以看出当前MIPS的使用情况:

- profiler.run_kymera_builtin(True)

- profiler.run_all()

- 当MIPS的资源超过80%时,就会有可能有卡顿或静音等现象。

如上图所示total user defined为 6.7%,如果高出80%,客户就得实际性的去减少MIPS的使用场景了,软件上没有好的方式去优化MIPS,只有关闭默写链路来减少MIPS的占用。

下篇博文预告:

下次的博文给大家描述Silence和Glith以及Distortion情况下如何分析和定位问题,欢迎大家登录大大通一起探讨和学习。

FAQ:

- 参考文档?

参考80-CG063-1_REV_AB_Debugging_with_ACAT.pdf

- ACAT的界面一直进不去,如何处理?

参考我该系列的第一个博文,ACAT的安装。

- 报如下错误如何解决:

Traceback (most recent call last):

File "ADK\audio\extensions\acat_tab\py\acat_tab.py", line 33, in <module> import ACAT ModuleNotFoundError: No module named 'ACAT'

意思是ACAT的工具还没有安装完成,这安装徐亚一定的时间,取决于电脑系统和网路。耐心等待就行。

- 如何下载到参考文档?

联系我们大联大的FAE,指导你们正确下载文档。

登录大大通,了解更多详情,解锁1500+完整应用方案,更有大联大700+FAE在线答疑解惑!