网站建设五行属什么昆明网站建设专家

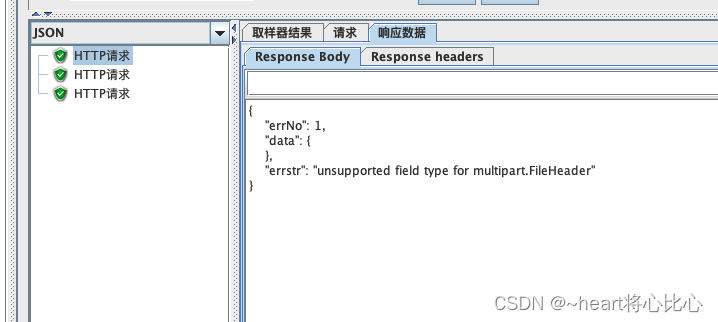

在使用jmeter测试接口的时候,提示errstr :"unsupported field type for multipart.FileHeader"如图所示

这是因为我们 在HTTP信息头管理加content-type参数有问题

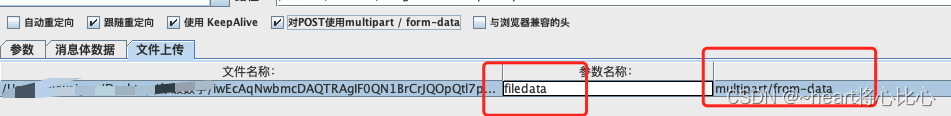

直接在HTTP请求中,勾选: use multipart/form-data for POST【中文:对post使用multipart/form-data for POST】,在Files Upload【中文:文件上传】中的文件名称,参数名和MIME类型如下:

这两个参数是不能乱写的,就要按照这样写