搭配服装网站源码手机兼职

这是关于App Inventor和Thunkable安全性的扩展,它提供MD5哈希,SHA1和SHA256哈希,AES加密/解密,RSA加密/解密,BASE64编码/解码方法。

权限

此扩展程序不需要任何权限。

事件

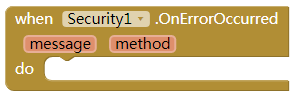

OnErrorOccured

抛出任何异常时将触发此事件。此事件中有两个变量:method和message。变量“method”是发生错误的方法的名称。变量“message”是例外的消息。

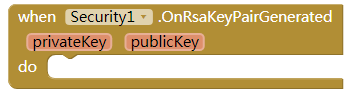

OnRsaKeyPairGenrated

当RSA密钥对成功生成时,将触发此事件。如果密钥对生成失败,则将触发“OnErrorOccured”事件而不是此事件。有两个变量,即RSA私钥和RSA公钥。

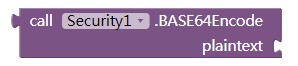

方法BASE64Encode

此方法用于BASE64编码一个字符串。输入 plaintext

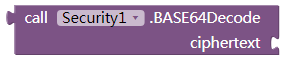

BASE64Decode

此方法用于BASE64解码字符串。输入 ciphertext

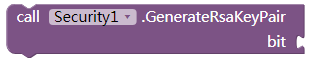

GenerateRsaKeyPair

此方法用于生成一对RSA加密/解密密钥(including a private key and a public key),输入密钥的大小,其单位为bit.it可以是512,1024,2048或4096.密钥越长,它就越安全。当已生成密钥对,该事件OnRsaKeyPairGenerated将触发和传递两个variable.At同时,属性RsaPublicKey和RsaPrivateKey将被自动设置。

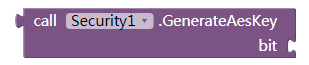

GenerateAesKey

此方法用于生成AES加密/解密的密钥。输入密钥的大小,其单位为bit,可以是128,192或256.密钥越长,它就越安全。它将返回一个字符串值。这是键值的BASE64编码结果。属性AesKey将自动设置。

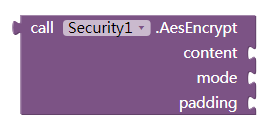

AesEncrypt

AES加密后使用属性AesKey和IV.Input内容,模式和填充返回结果。

- content:要加密的明文

- 填充:AES加密填充,也可以是PKCS5Padding,PKCS7Padding,ISO10126或ANSIX923

- 模式:AES加密方式,也可以是ECB,CBC,CTR,OFB或CFB

- IV:AES加密IV,它必须是字符串值,并且其长度必须是16个字符,如果选择ECB加密模式,则不需要此值,否则必须设置此属性。

拓展下载见原文:App Inventor 2 Encrypt.Security 安全性扩展:MD5哈希,SHA/AES/RSA/BASE64 - App Inventor 2 拓展 - 清泛IT社区,为创新赋能!