怎么做网络乞丐网站公司网站建设计入什么费用

这个不分也是挺难的,但是之前有详细的,解释了,之前的文章中有, 那么这里会简单提一下,然后,继续向下学习

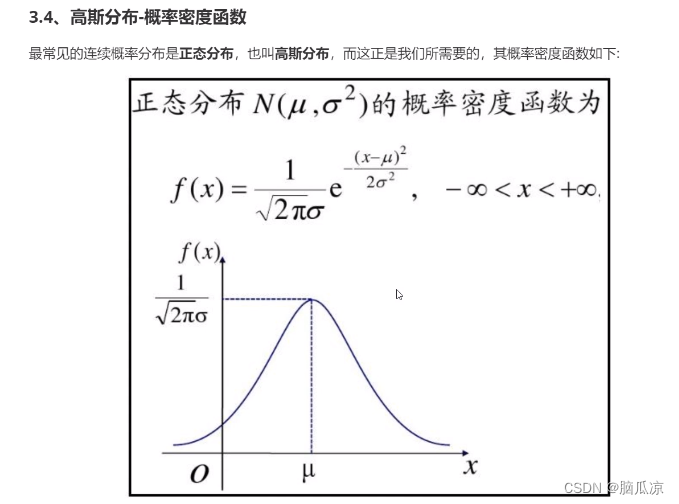

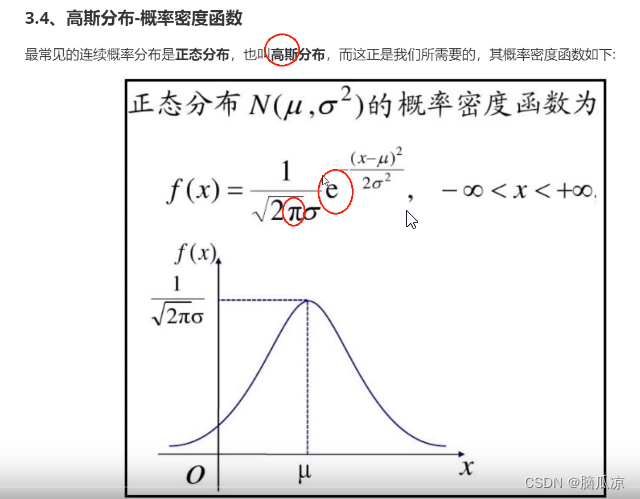

首先我们要知道高斯分布,也就是,正太分布, 这个可以预测x在多少的时候,概率最大

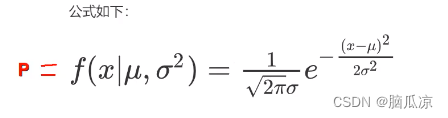

要知道在概率分布这个,高斯分布公式中,u代表平均值,然后西格玛代表标准差,知道了

这两个数以后,带入正态分布的公式,可以看到就可以求出y的值来

那么可以看到这里有派,还有e对吧,这两个自然界常数,拥有自然的规律....是上帝常数

可以看到

知道了u平均值,和西格玛,以后带入就可以知道x是多少的时候,对应的y是多少,y就可以代表概率.

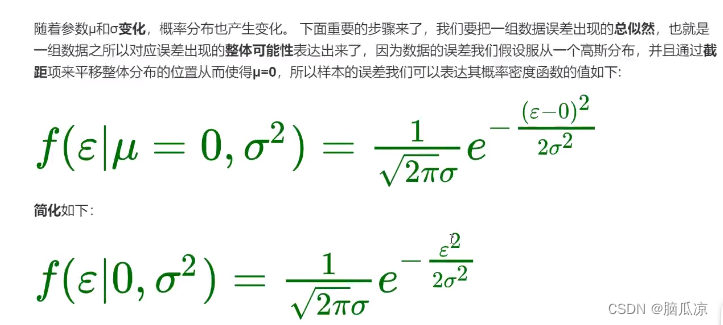

可以看到随着平均值和西格玛这个标准差的,变化,概率分布也产生了变化