安庆建设网站计算机网络技术专业主要学什么

在GitHub闲逛,偶然发现了东北编程语言:

东北编程语言是由Zhanyong Wan创造的,它使用东北方言词汇作为基本关键字。这种编程语言的特点是简单易懂,适合小学文化程度的人学习,并且易于阅读、编写和记忆。它的语法与其他编程语言有所不同,例如使用“唠唠”表示输出,使用“装”表示赋值,使用“走走”、“退退”、“走X步”、“退X步”表示变量的增减等。

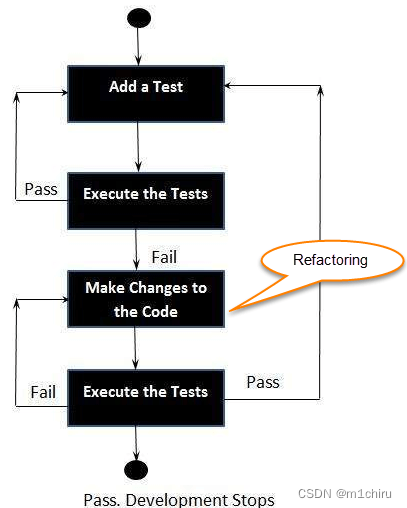

东北编程语言的开发采用了TDD(TreeNewBee-Driven Development)方式,这是一种先编写文案、再编写测试案例、最后实现功能的开发方式。这样做有两个好处:首先,每个功能都是有目的的,不值得的功能不会被包含在内;其次,每个功能都有文案负责吹嘘,确保开发者的辛劳得到认可。

东北编程语言是一种具有创新性和亲切感的编程语言,它使用东北方言词汇作为基本关键字,使得编程变得更加简单、有趣和有文化特色。

什么是测试驱动开发 (TDD)?

测试驱动开发 (TDD) 是一种软件开发方法,其中开发测试用例以指定和验证代码将执行的操作。简单来说,首先创建并测试每个功能的测试用例,如果测试失败,则编写新代码以通过测试并使代码简单且没有错误。

测试驱动开发从为应用程序的每个小功能设计和开发测试开始。TDD 框架指示开发人员仅在自动化测试失败时编写新代码。这样可以避免代码重复。TDD 的完整形式是测试驱动开发。

TDD 的简单概念是在编写新代码之前(在开发之前)编写并纠正失败的测试。这有助于避免代码重复,因为我们一次编写少量代码以通过测试。(测试只不过是我们需要测试以满足它们的需求条件)。

测试驱动开发是在实际开发应用程序之前开发和运行自动化测试的过程。因此,TDD 有时也称为测试优先开发。

东北编程语言是一种模拟东北方言的计算机编程语言,其特点主要包括以下几个方面:

- 使用东北方言的词汇:东北编程语言使用东北方言中的一些特定词汇来代替标准的编程术语,例如“唠唠”(输出)、“嘎哒”(这个)、“那啥”(那个)等。这些词汇的使用可以增加代码的可读性和趣味性。东北编程语言使用模拟东北方言的词汇来代替标准的编程术语。这些词汇的使用可以增加代码的可读性和趣味性,使得代码更加简洁易懂。同时,这些词汇也有助于提高代码的易记性和可维护性。

- 语法规则简化:东北编程语言的语法规则相对较为简单,易于学习和掌握。它省略了一些不必要的细节和繁琐的规则,使得代码更加简洁明了。东北编程语言简化了语法规则,省略了一些不必要的细节和繁琐的规则。例如,在东北编程语言中,变量名可以直接使用中文单词,而不需要遵循严格的命名规范。这样可以减少代码的冗余和复杂性,使代码更加简洁明了。

- 以人为本:东北编程语言强调以人为本的设计理念,旨在让程序员能够更加轻松愉快地编写代码。它关注程序员的需求和体验,通过模拟东北方言的词汇和语法规则来提高代码的可读性和趣味性,从而减轻程序员的工作压力。

- 工具支持:东北编程语言可以通过一些工具或软件来将代码翻译成标准的编程语言,从而实现类似的功能。这些工具可以帮助程序员快速地编写出易于理解和维护的代码,同时也可以提高程序员的工作效率。

东北编程语言通过以下方式简化语法规则:

- 变量声明简化:在东北编程语言中,变量声明可以省略类型声明,变量类型可以根据赋值自动推断。例如,“唠唠 x 嘎哒!”可以表示输出变量x的值,而不需要显式声明x的类型。

- 条件语句简化:东北编程语言简化了条件语句的语法,例如“如果那啥”可以表示if语句,“那啥”后面的代码块会在条件为真时执行。

- 循环语句简化:东北编程语言简化了循环语句的语法,例如“对于每个那啥”可以表示for循环,“那啥”后面的代码块会在循环中重复执行。

- 函数定义简化:东北编程语言简化了函数定义的语法,例如“定义一个那啥”可以表示定义一个函数,“那啥”后面的代码块是函数的实现。

- 操作符简化:东北编程语言简化了操作符的语法,例如“加那啥”可以表示加法操作,“那啥”后面的值是加法的另一个操作数。

东北编程语言中的循环语句简化主要是通过使用一些简化的词汇和语法规则来实现的。以下是一些常见的循环语句简化的示例:

- “对于每个那啥”可以表示for循环。例如,“对于每个数”,可以将代码块中的代码对列表或数组中的每个元素进行迭代。

- “当那啥的时候”可以表示while循环。例如,“当x不等于0的时候”,可以将代码块中的代码重复执行,直到条件满足为止。

- “直到那啥”可以表示do-while循环。例如,“直到x等于0”,可以将代码块中的代码重复执行,直到条件满足为止。