顺德高端网站设计五星级酒店网站建设

系列文章目录

华为数通学习(4)

目录

系列文章目录

华为数通学习(4)

前言

一,网段间通信

二,路由器的基本特点

三,路由信息介绍

四,路由表

五,路由表的来源有哪些

六,最优路由条目优选

问题思考:优先级Pre(Preference)和cost都是用来选路了,两者有何区别?

七,路由优先级 - 基本概念

八,常见路由类型的默认优先级如下:

场景问题:

九,路由优先级 – 比较过程

总结

前言

随着华为公司的不断发展,数据通信这门技术也越来越重要,很多人都开启了数据通信学习,本文就介绍了路由器的简单概述,是我们通过数通王国的第十二站(我们在文章中使用的是华为的ENSP软件)。

一,网段间通信

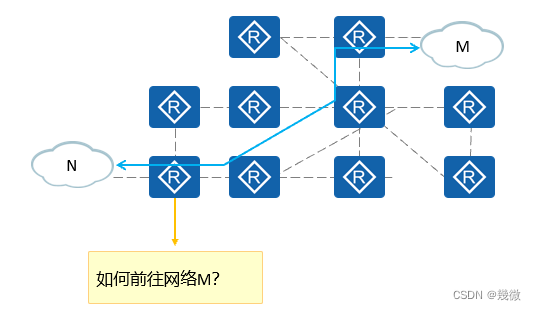

IP地址唯一标识了网络中的一个节点,每个IP地址都拥有自己的网段,各个网段可能分布在网络的不同区域。

为实现IP寻址,分布在不同区域的网段之间要能够相互通信,要有路由信息。

解释:路由从一个节点到另一个节点,中间有很多条线路,我们需要去选择一条开销最小,最便捷的一条路线

二,路由器的基本特点

理解:所谓的路由你可以把他理解为一张地图,指导着我们报文转发的路径信息,通过这个路由可以确认这个报文转发应该从那个接口出去,下一站点找到谁。路由设备是依据路由转发报文到目的网段的网络设备,最常见的路由设备:存放着路由表的路由器。路由设备维护着一张路由表,保存着路由信息。告诉路由器是如何转发的。总结:路由是路由器进行数据包转发的唯一根据,针对一个目标网段,存在路由则转发,无路由则丢包。

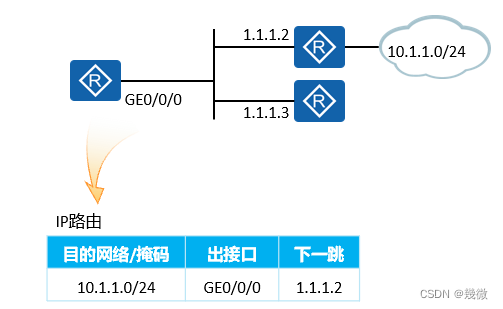

通俗理解:你要去哪里(目标网段),到达哪里要先找到下一站(下一跳IP地址)是谁,要达到下一站应该从哪个出口(接口)出去。

三,路由信息介绍

路由中包含以下信息:目的网络:标识目的网段掩码:与目的地址共同标识一个网段出接口:数据包被路由后离开本路由器的接口下一跳:路由器转发到达目的网段的数据包所使用的下一跳地址这些信息标识了目的网段、明确了转发IP报文的路径

四,路由表

路由器通过各种方式发现路由路由器选择最优的路由条目放入路由表中路由表指导设备对IP报文的转发路由器通过对路由表的管理实现对路径信息的管理

路由器两大功能:1、寻址 2、转发

五,路由表的来源有哪些

六,最优路由条目优选

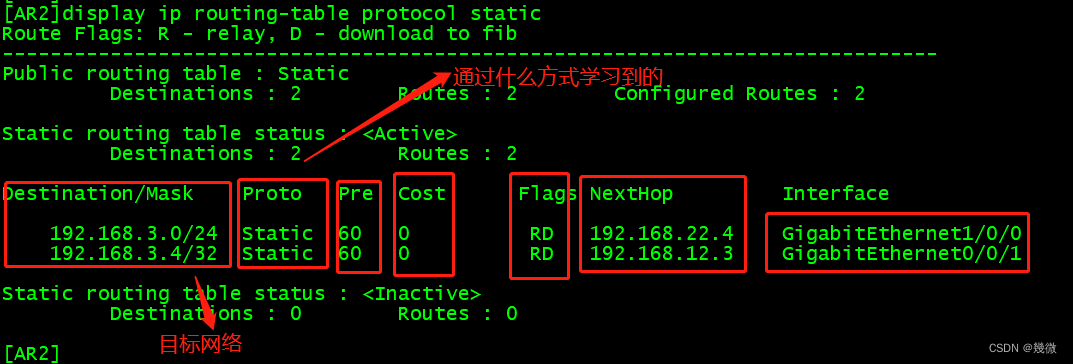

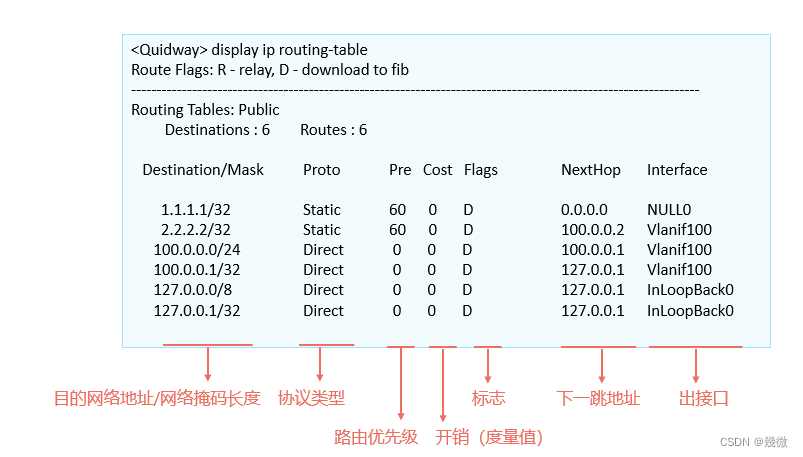

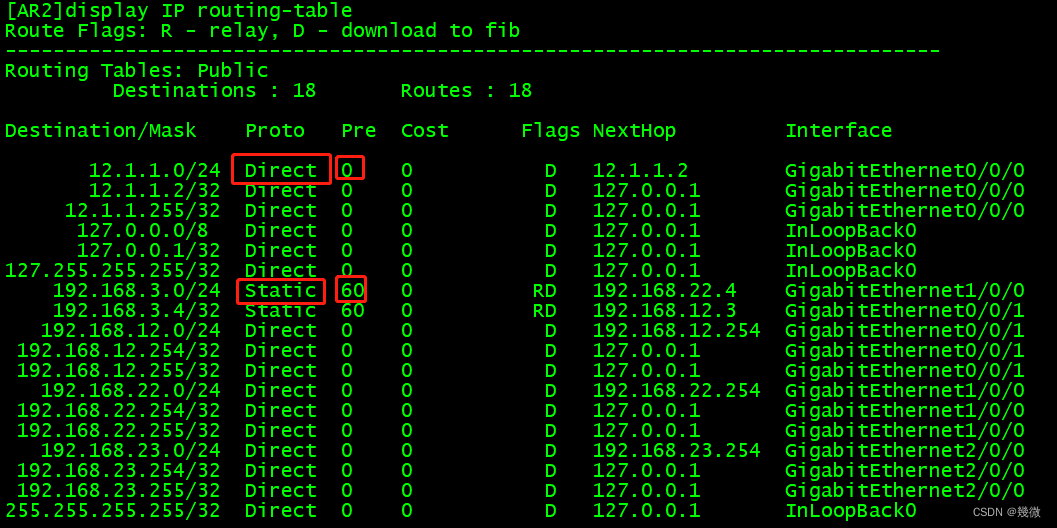

Destination/Mask:表示此路由的目的网络地址与网络掩码。将目的地址和子网掩码“逻辑与”后可得到目的主机或路由器所在网段的地址。例如:目的地址为1.1.1.1,掩码为255.255.255.0的主机或路由器所在网段的地址为1.1.1.0/24。Proto(Protocol):该路由的协议类型,也即路由器是通过什么协议获知该路由的。Pre(Preference):表示此路由的路由协议优先级。针对同一目的地,可能存在不同下一跳、出接口等多条路由,这些不同的路由可能是由不同的路由协议发现的,也可以是手工配置的静态路由。优先级最高(数值最小)者将成为当前的最优路由。Cost:路由开销。当到达同一目的地的多条路由具有相同的路由优先级时,路由开销最小的将成为当前的最优路由。NextHop:表示对于本路由器而言,到达该路由指向的目的网络的下一跳地址。该字段指明了数据转发的下一个设备。Interface:表示此路由的出接口。指明数据将从本路由器的哪个接口转发出去。

问题思考:优先级Pre(Preference)和cost都是用来选路了,两者有何区别?

七,路由优先级 - 基本概念

当路由器从多种不同的途径获知到达同一个目的网段的路由(这些路由的目的网络地址及网络掩码均相同)时,路由器会比较这些路由的优先级,优选优先级值最小的路由。解释:同一个目的网段的路由本质含义:这些路由的目的网络地址及网络掩码均相同(网络号相同)理解:只有网段和掩码不相同的时候,我们才会需要去。进行优劣的比较,如果是两条不同的路由就不需要去进行去比较了。所以前提条件就是同一目的网段的路由路由来源的优先级值(Preference)越小代表加入路由表的优先级越高。拥有最高优先级的路由将被添加进路由表。

八,常见路由类型的默认优先级如下:

场景问题:

工程师郑工到一家IDC机架进行设备故障排除时候,发现OSPF协议的优先级不是10,也不是150,请问存在什么样的可能性会出现类似现象?(10分)

答:可能性1:因为手工修改了。(5分)可能性2:这不是华为设备,比如思科设备OSPF协议默认优先级是110结论:不同厂商设备优先级也是可能不一样的;思科设备OSPF优先级为110:R2#show ip route ospf1.0.0.0/32 is subnetted, 1 subnetsO 1.1.1.1 [110/11] via 10.1.12.1, 00:00:08, FastEthernet0/0R2#

度量值就是开销值,也是cost,叫法不一样而已。

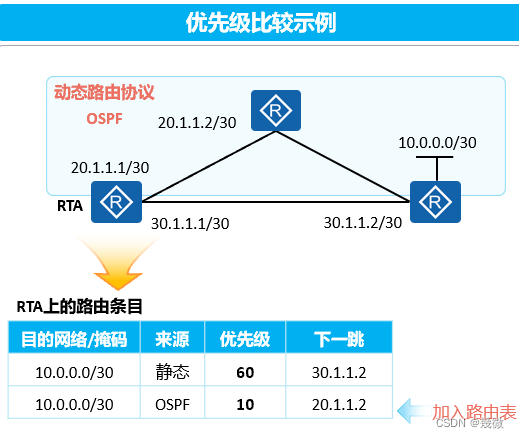

九,路由优先级 – 比较过程

RTA通过动态路由协议OSPF和手动配置的方式都发现了到达10.0.0.0/30的路由,此时会比较这两条路由的优先级,优选优先级值最小的路由。每一种路由协议都有相应的优先级。OSPF拥有更优的优先级,因此通过OSPF学习到的路由被添加到路由表中。

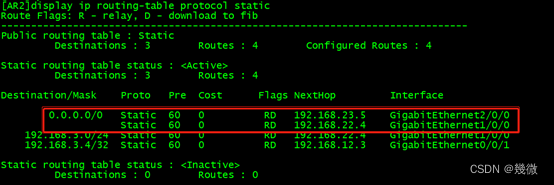

假设优先级和度量值都一样,会怎么处理这个情况:答:那就负载均衡了 同时放进路由表 典型代表:浮动静态路由就是例子[AR2]ip route-static 0.0.0.0 0 192.168.23.5[AR2]ip route-static 0.0.0.0 0 192.168.22.4

总结

恭喜你,你通过本章的学习了路由器的简单概述,华为数通还有很多宝藏等着你去探险,加油!只为成为更好的自己。