西安十大网站制作公司php语言做购物网站

【软件测试面试突击班】如何逼自己一周刷完软件测试八股文教程,刷完面试就稳了,你也可以当高薪软件测试工程师(自动化测试)

一 简介

1.什么是ant?

ant是构建工具

2.什么是构建

概念到处可查到,形象来说,你要把代码从某个地方拿来,编译,再拷贝到某个地方去等等操作,当然不仅于此,但是主要用来干这个

3.ant的好处

跨平台 --因为ant是使用java实现的,所以它跨平台

使用简单--与ant的兄弟make比起来

语法清晰--同样是和make相比

功能强大--ant能做的事情很多,可能你用了很久,你仍然不知道它能有多少功能。当你自己开发一些ant插件的时候,你会发现它更多的功能。

4.ant的兄弟make

ant做的很多事情,大部分是曾经有一个叫make的所做的,不过对象不同,make更多应用于c/c++ ,ant更多应用于Java。

Ant的主要目的就是把你想做的事情自动化,不用你手动一步一步做,因为里面内置了javac、java、创建目录、复制文件等功能,所以可以直接点击Ant文件,即可编译生成你的项目;

二· 构建ant环境

1 下载安装

(1)下载地址 http://ant.apache.org/bindownload.cgi

(2)解压到指定目录下即可

(3)配置环境变量(window中)

新增 ANT_HOME 变量添加:D:\apache-ant-1.10.3

Path 变量中添加:%ANT_HOME%\bin

classpath 变量中添加: %ANT_HOME%\bin

4.安装验证

验证安装结果,命令行输入ant -v ,出现版本信息则安装成功

Jmeter与Ant集成

集成的目的: 主要应用于接口的回归或者性能的简单查看功能。

作为先在jmeter中写好测试计划,保存为jmx文件,在cmd窗口对应路径下执行ant命令,会完成jmx计划的执行和生成jtl文件,并将jtl文件转化为html页面进行查看。

后续可扩展为接入jenkins集成,并邮件发送

三 Git的简介

(1)Git是一款免费、开源的分布式版本控制系统,用于敏捷高效地处理任何或小或大的项目。

(2)Git是一个开源的分布式版本控制系统,可以有效、高速的处理从很小到非常大的项目版本管理。

(3)Git 是 Linus Torvalds 为了帮助管理 Linux 内核开发而开发的一个开放源码的版本控制软件。

(4)官网地址为:https://git-scm.com/

git安装完成后,在菜单git-git bash,点击,显示一个类似命令行窗口的东西,说明git安装成功。

其中git 安装完毕后,需要进行ssh连接,才能使用。 。

四 Jenkins简介

Jenkins是一个功能强大的应用程序,允许持续集成和持续交付项目,无论用的是什么平台。这是一个免费的源代码,可以处理任何类型的构建或持续集成。集成Jenkins可以用于一些测试和部署技术。Jenkins是一种软件允许持续集成。

开源的java语言开发持续集成工具,支持CI,CD。

易于安装部署配置:可通过yum安装,或下载war包以及通过docker容器等快速实现安装部署,可方便web界面配置管理。

消息通知及测试报告:集成RSS/E-mail通过RSS发布构建结果或当构建完成时通过e-mail通知,生成JUnit/TestNG测试报告。

分布式构建:支持Jenkins能够让多台计算机一起构建/测试。

文件识别:Jenkins能够跟踪哪次构建生成哪些jar,哪次构建使用哪个版本的jar等。

丰富的插件支持:支持扩展插件,你可以开发适合自己团队使用的工具,如git,svn,maven,docker等。

jenkins安装

less /var/log/jenkins/jenkins.log //查询admin密码

访问 http://ip:8080/ 进行安装

jenkins相关目录:

rpm -ql jenkins #查看jenkins安装相关目录

安装目录/var/lib/jenkins

配置文件 /etc/sysconfig/jenkins

下面是配套学习资料,对于做【软件测试】的朋友来说应该是最全面最完整的备战仓库,这个仓库也陪伴我走过了最艰难的路程,希望也能帮助到你!

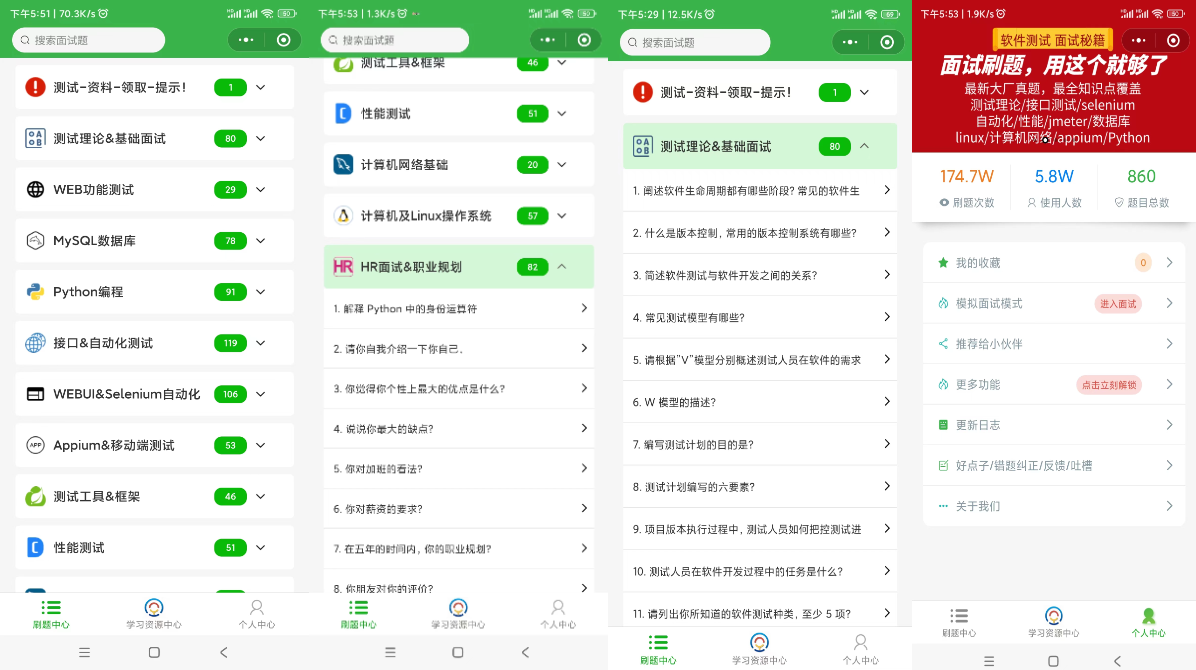

软件测试面试小程序

被百万人刷爆的软件测试题库!!!谁用谁知道!!!全网最全面试刷题小程序,手机就可以刷题,地铁上公交上,卷起来!

涵盖以下这些面试题板块:

1、软件测试基础理论 ,2、web,app,接口功能测试 ,3、网络 ,4、数据库 ,5、linux

6、web,app,接口自动化 ,7、性能测试 ,8、编程基础,9、hr面试题 ,10、开放性测试题,11、安全测试,12、计算机基础

文档获取方式:

这份文档,对于想从事【软件测试】的朋友来说应该是最全面最完整的备战仓库,这个仓库也陪伴我走过了最艰难的路程,希望也能帮助到你!