设计网站建网站建设商城

北京东昊力伟科技有限责任公司

温控仪、温度控制器

产品特点:

可外接温度传感器Pt100、Cu50、K、E、J、N、T、R、S、B兼容输入;PID控制输出、位式控制输出、继电器报警输出;控温能满足设定温度值的±0.2℃;既可用于加热控制、也可用于制冷控制;既可以摄氏度显示,也可以华氏度显示;具有PID参数自整定功能;无效消隐,参数设定值都有停电记忆。

温控仪、温度控制器

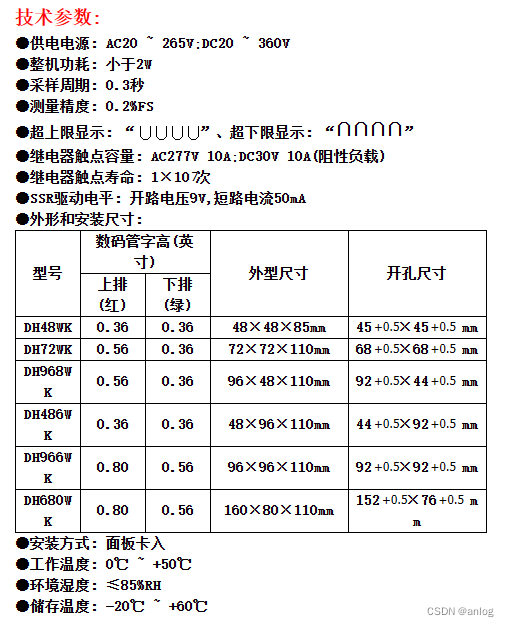

技术参数:

●供电电源: AC20 ~ 265V;DC20 ~ 360V

●整机功耗: 小于2W

●采样周期: 0.3秒

●测量: 0.2%FS

●上限显示: “∪∪∪∪”、下限显示: “∩∩∩∩”

●继电器触点容量: AC277V 10A;DC30V 10A(阻性负载)

●继电器触点寿命: 1×107次

●SSR驱动电平: 开路电压9V,短路电流50mA

●外形和安装尺寸:

| 型号 | 数码管字高(英寸) | 外型尺寸 | 开孔尺寸 | |

| 上排(红) | 下排(绿) | |||

| DH48WK | 0.36 | 0.36 | 48×48×85mm | 45+0.5×45+0.5 mm |

| DH72WK | 0.56 | 0.36 | 72×72×110mm | 68+0.5×68+0.5 mm |

| DH968WK | 0.56 | 0.36 | 96×48×110mm | 92+0.5×44+0.5 mm |

| DH486WK | 0.36 | 0.36 | 48×96×110mm | 44+0.5×92+0.5 mm |

| DH966WK | 0.80 | 0.56 | 96×96×110mm | 92+0.5×92+0.5 mm |

| DH680WK | 0.80 | 0.56 | 160×80×110mm | 152+0.5×76+0.5 mm |

●安装方式: 面板卡入

●工作温度: 0℃ ~ +50℃

●环境湿度: ≤85%RH

●储存温度: -20℃ ~ +60℃

温控仪、温度控制器

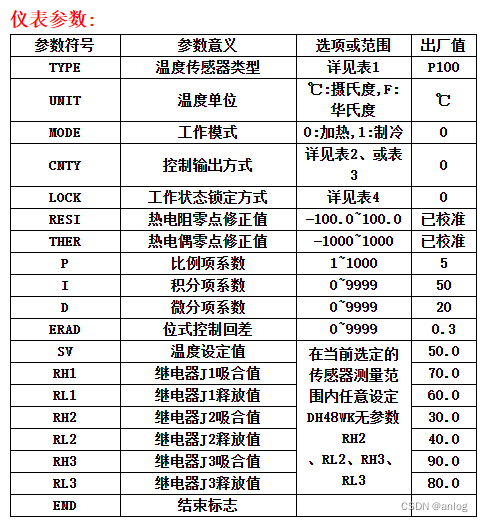

仪表参数:

| 参数号 | 参数意义 | 选项或范围 | 出厂值 |

| TYPE | 温度传感器类型 | 详见表1 | P100 |

| UNIT | 温度单位 | ℃:摄氏度,F:华氏度 | ℃ |

| MODE | 工作模式 | 0:加热,1:制冷 | 0 |

| CNTY | 控制输出方式 | 详见表2、或表3 | 0 |

| LOCK | 工作状态锁定方式 | 详见表4 | 0 |

| RI | 热电阻点修正值 | -100.0~100.0 | 已校准 |

| THER | 热电偶点修正值 | -1000~1000 | 已校准 |

| P | 比例项系数 | 1~1000 | 5 |

| I | 积分项系数 | 0~9999 | 50 |

| D | 微分项系数 | 0~9999 | 20 |

| ERAD | 位式控制回差 | 0~9999 | 0.3 |

| SV | 温度设定值 | 在当前选定的 传感器测量范 围内任意设定 DH48WK无参数RH2 、RL2、RH3、RL3 | 50.0 |

| RH1 | 继电器J1吸合值 | 70.0 | |

| RL1 | 继电器J1释放值 | 60.0 | |

| RH2 | 继电器J2吸合值 | 30.0 | |

| RL2 | 继电器J2释放值 | 40.0 | |

| RH3 | 继电器J3吸合值 | 90.0 | |

| RL3 | 继电器J3释放值 | 80.0 | |

| END | 结束标志 |

温控仪、温度控制器

表1、温度传感器类型:

| 传感器参数号 | 传感器类型名称 | 传感器测量范围 |

| P100 | Pt100 型热电阻 | -199.9℃ ~ 700.0℃ |

| Cu50 | Cu50 型热电阻 | -50.0℃ ~ 150.0℃ |

| K | K 型热电偶 | -200℃ ~ 1200℃ |

| E | E 型热电偶 | -200℃ ~ 1000℃ |

| J | J 型热电偶 | -200℃ ~ 1200℃ |

| N | N 型热电偶 | -200℃ ~ 1200℃ |

| T | T 型热电偶 | -200℃ ~ 400℃ |

| R | R 型热电偶 | 0℃ ~ 1600℃ |

| S | S 型热电偶 | 0℃ ~ 1600℃ |

| B | B 型热电偶 | 0℃ ~ 1800℃ |

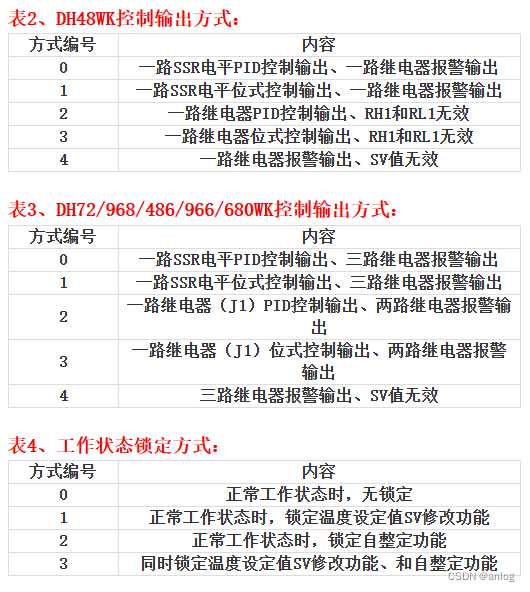

表2、DH48WK控制输出方式:

| 方式编号 | 内容 |

| 0 | 一路SSR电平PID控制输出、一路继电器报警输出 |

| 1 | 一路SSR电平位式控制输出、一路继电器报警输出 |

| 2 | 一路继电器PID控制输出、RH1和RL1无效 |

| 3 | 一路继电器位式控制输出、RH1和RL1无效 |

| 4 | 一路继电器报警输出、SV值无效 |

表3、DH72/968/486/966/680WK控制输出方式:

| 方式编号 | 内容 |

| 0 | 一路SSR电平PID控制输出、三路继电器报警输出 |

| 1 | 一路SSR电平位式控制输出、三路继电器报警输出 |

| 2 | 一路继电器(J1)PID控制输出、两路继电器报警输出 |

| 3 | 一路继电器(J1)位式控制输出、两路继电器报警输出 |

| 4 | 三路继电器报警输出、SV值无效 |

表4、工作状态锁定方式:

| 方式编号 | 内容 |

| 0 | 正常工作状态时,无锁定 |

| 1 | 正常工作状态时,锁定温度设定值SV修改功能 |

| 2 | 正常工作状态时,锁定自整定功能 |

| 3 | 同时锁定温度设定值SV修改功能、和自整定功能 |

特此记录

anlog

2023年10月18日