苏州网站建设选苏州梦易行深圳推广系统多少钱

一丶前言

FFmpeg是一个开源的音视频处理工具集,由多个命令行工具组成。它可以在跨平台的环境中处理、转换、编辑和流媒体处理音视频文件。

FFmpeg支持多种常见的音视频格式和编解码器,可以对音视频文件进行编码、解码、转码、剪辑、合并等操作。它具有广泛的功能,包括以下功能:

- 格式转换: FFmpeg可以将音视频文件从一种格式转换为另一种格式。无论是不同的容器格式(如MP4、AVI、MKV)还是不同的编解码器(如H.264、HEVC、AAC),FFmpeg都可以进行转换。

- 编解码: FFmpeg支持各种音视频编解码器,可以解码从不同设备或来源获取的音视频数据,并进行编码以生成各种格式的音视频文件。

- 剪辑和合并: FFmpeg可以对音视频文件进行剪辑和合并操作。您可以裁剪音视频文件的特定部分,合并多个音视频文件为一个文件,或者在同一时间轴上叠加音频和视频。

- 流媒体处理: FFmpeg支持流媒体相关的功能,如实时流媒体传输、音视频捕获和转发。它可以用于构建流媒体服务器、实现直播功能等。

- 滤镜和特效: FFmpeg提供了多种滤镜和特效,可以应用于音视频文件,如调整色彩、改变尺寸、添加水印等。

二丶Window安装

官方下载地址:Download FFmpeg

选择 Windows Builds By BtbN后会进入到github中,选择相应的windwos版本进行下载

GIT下载地址

git clone https://git.ffmpeg.org/ffmpeg.git ffmpeg

1.将压缩包解压

2.配置环境变量

3.检查是否配置成功win+R,然后输入ffmpge -version

三丶Linux安装

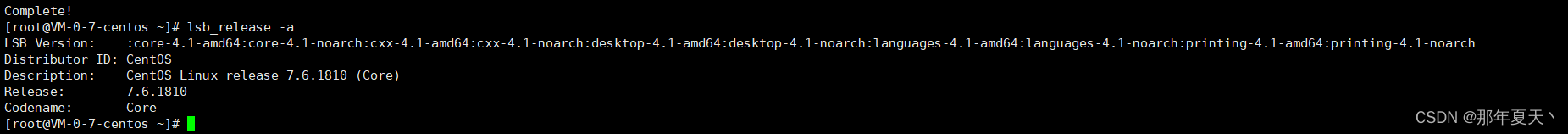

1.查看系统版本

yum install -y redhat-lsb

lsb_release -a

2.下载地址:John Van Sickle - FFmpeg Static Builds

可以先在本地下载,然后上传到服务器,获取事由wget命令,比如工作目录为/opt/ffmpeg,通过wget进行下载

cd /opt/ffmpegwget https://johnvansickle.com/ffmpeg/releases/ffmpeg-release-amd64-static.tar.xz

3、解压安装

1.解压

tar -xvJf ffmpeg-release-amd64-static.tar.xz

2.配置环境变量cd /usr/bin

ln -s /opt/ffmpeg/ffmpeg-4.4.1-amd64-static/ffmpeg ffmpeg

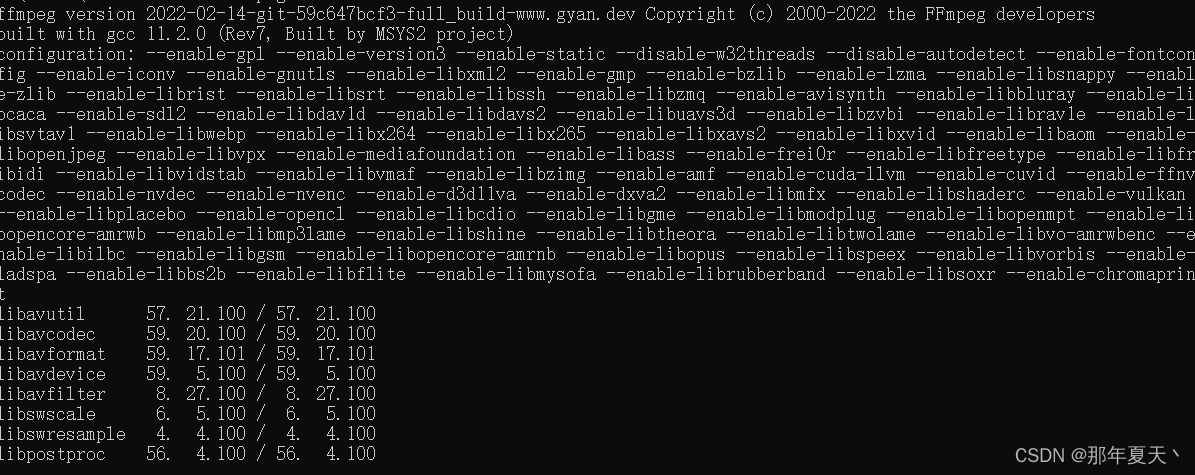

3.测试环境配置

ffmpeg -version

结尾:喜欢的朋友点赞收藏吧,下章直接分享我工作中常用干货