湖北省随州市建设厅网站如何在亚马逊开店

【JupyterLab】在 conda 虚拟环境中 JupyterLab 的安装与使用

- 1 JupyterLab 介绍

- 2 安装

- 2.1 Jupyter Kernel 与 conda 虚拟环境

- 3 使用

- 3.1 安装中文语言包(Optional)

- 3.2 启动

- 3.3 常用快捷键

- 3.3.1 命令模式下

- 3.4 远程访问个人计算机

- 3.4.1 局域网下

1 JupyterLab 介绍

官方文档: Link

JupyterLab 是 Project Jupyter 旗下其他笔记本编写应用程序(如 Jupyter Notebook 和 Jupyter Desktop)的同胞兄弟。与 Jupyter Notebook 相比,JupyterLab 提供了更先进、功能更丰富、可定制的体验。

2 安装

官方文档: Link

pip install jupyterlab

2.1 Jupyter Kernel 与 conda 虚拟环境

本人目前的建议是:在每个虚拟环境中都完整地安装 jupyterlab(在运行前一定要激活所需的虚拟环境)。

在使用时,用这个默认的 Kernel 即可,它调用的就是所在虚拟环境的 Python Interpreter。

可以用下面的代码运行验证一下:

import os

import sys

print(f"Python 版本信息: {sys.version}")

print(f"\n解释器路径: {sys.executable}")

print(f"\n当前工作目录: {os.getcwd()}")

此外,这篇问答 How to use Jupyter notebooks in a conda environment? 给出了 3 种不同的使用方式,想要尝试的话可以参考。

3 使用

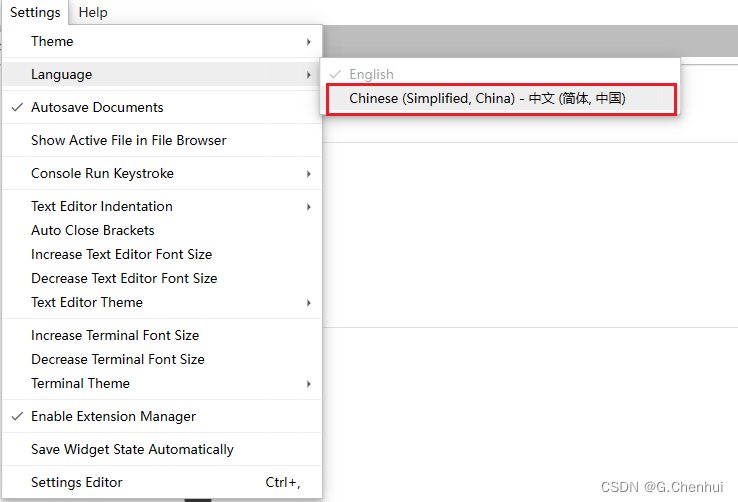

3.1 安装中文语言包(Optional)

官方文档: Link

pip install jupyterlab-language-pack-zh-CN

将页面切换为中文

3.2 启动

--no-browser: 禁止启动时自动打开浏览器--ip=<Unicode>: Jupyter 服务器监听的 IP 地址,默认为localhost--port=<Int>: Jupyter 服务器监听的端口--notebook-dir=<Unicode>: 工作目录(顶层)--app-dir=<Unicode>: 启动时所在的目录(包含于 notebook-dir)--pylab=<Unicode>: 默认为disabled,需要在 notebook 中使用%pylab或%matplotlib来启用 matplotlib

jupyter lab --notebook-dir=E:/ --preferred-dir E:/Documents/Somewhere/Else

3.3 常用快捷键

ESC: 切换到命令模式ENTER: 切换到编辑模式Ctrl+Enter: 运行 CellShift+Enter: 运行 Cell,并切换至下一个 Cell

3.3.1 命令模式下

a: 上方插入新 Cellb: 下方插入新 Celly: 将 Cell 转为 Codem: 将 Cell 转为 Markdownd+d: Restart Kernel

3.4 远程访问个人计算机

默认情况下,Jupyter 服务器在本地运行,地址为 127.0.0.1:8888,只能从 localhost 访问。

3.4.1 局域网下

jupyter lab --notebook-dir=E:/ --preferred-dir E:/Documents/Somewhere/Else --ip="192.168.31.177" --port=12345 --no-browser

待更ing