长沙教育类网站建设财经门户网站开发

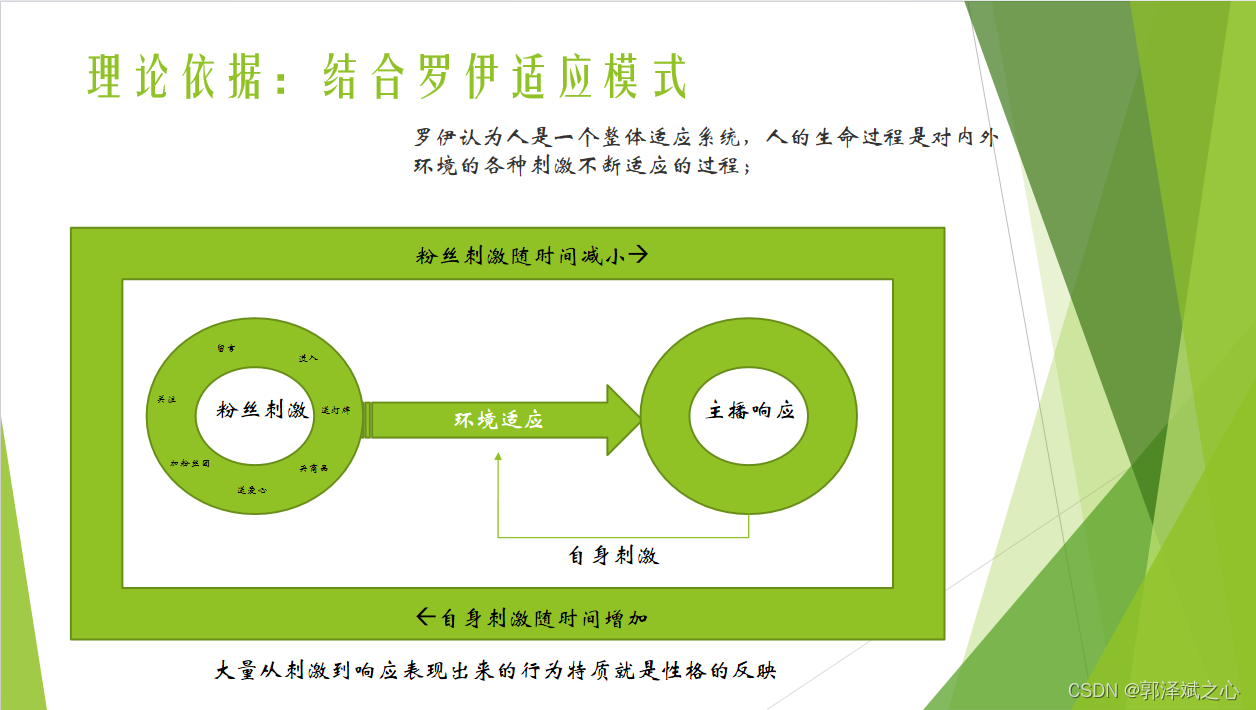

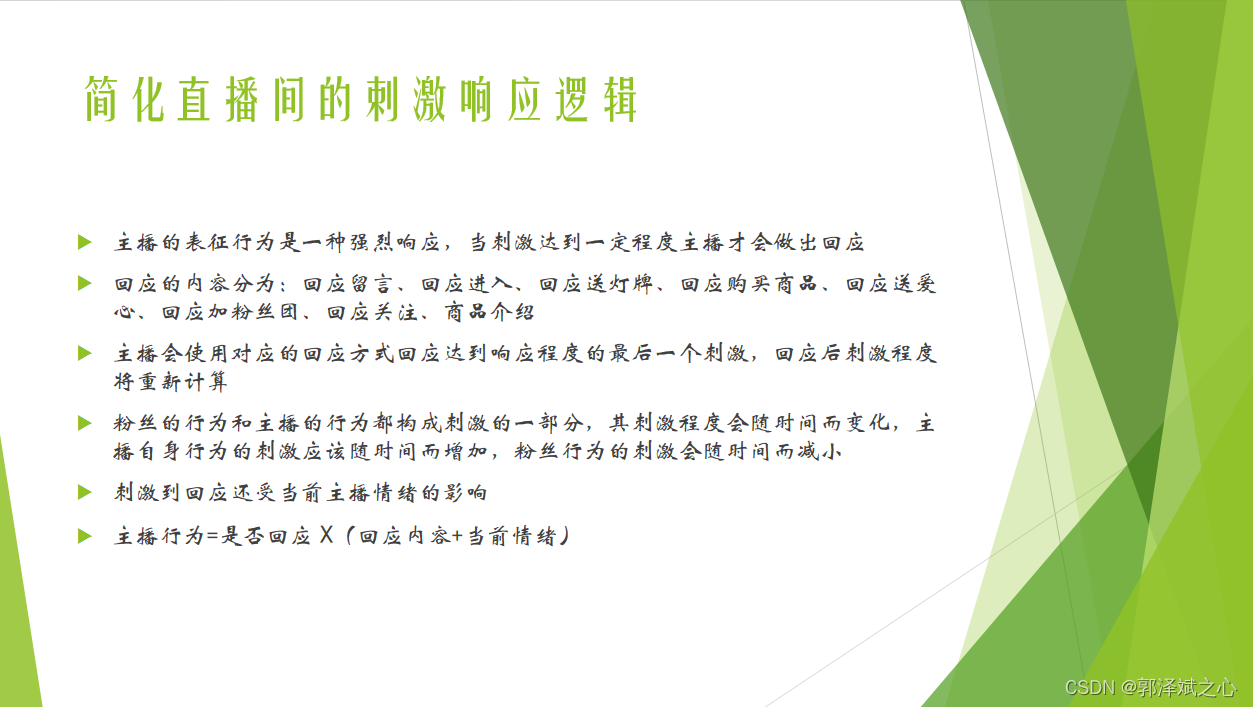

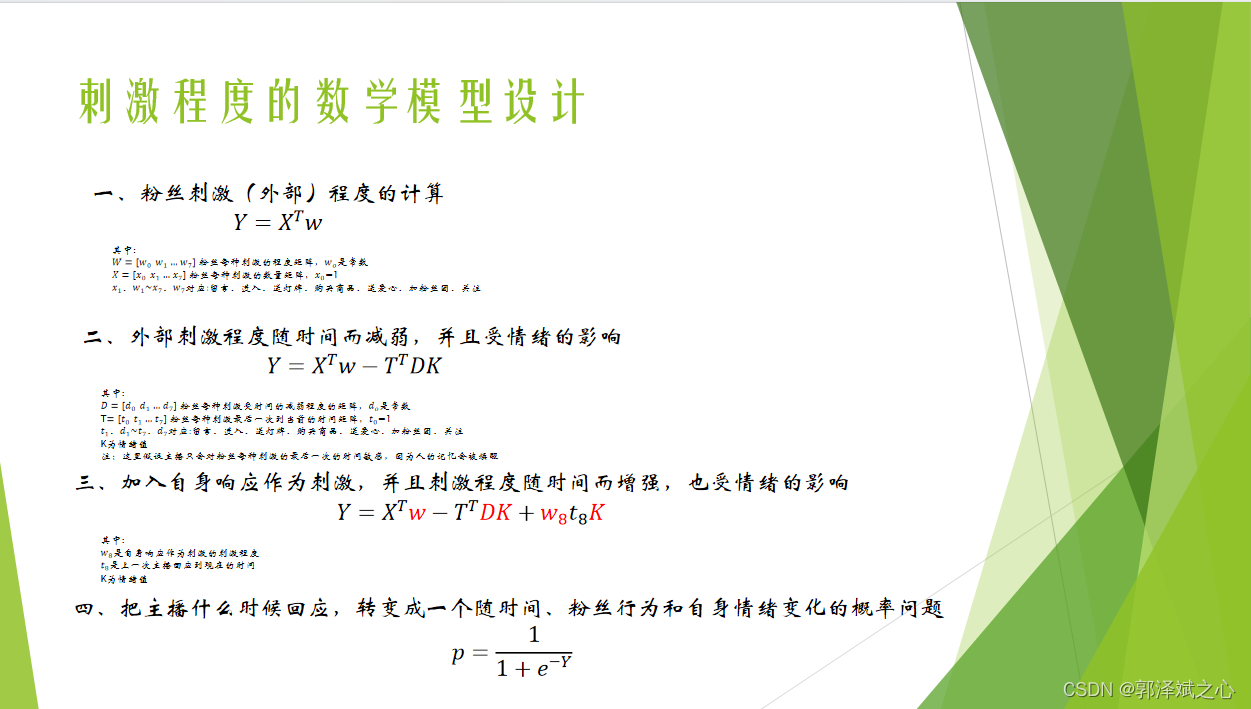

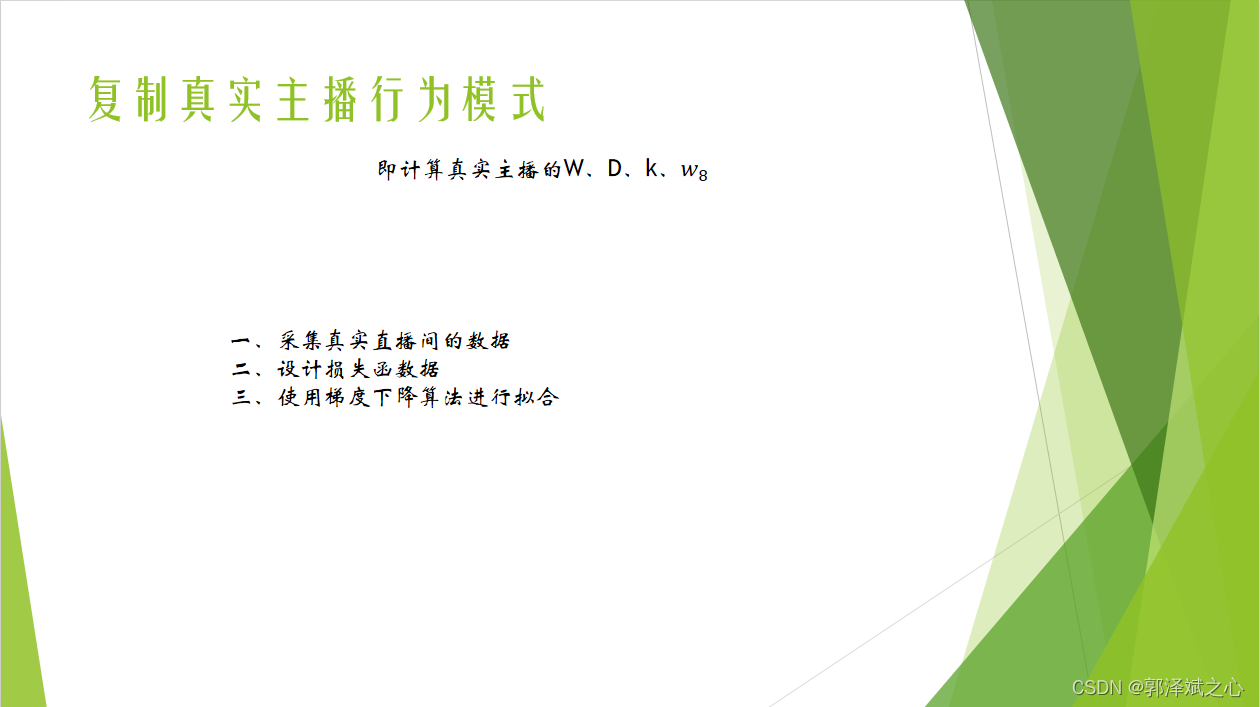

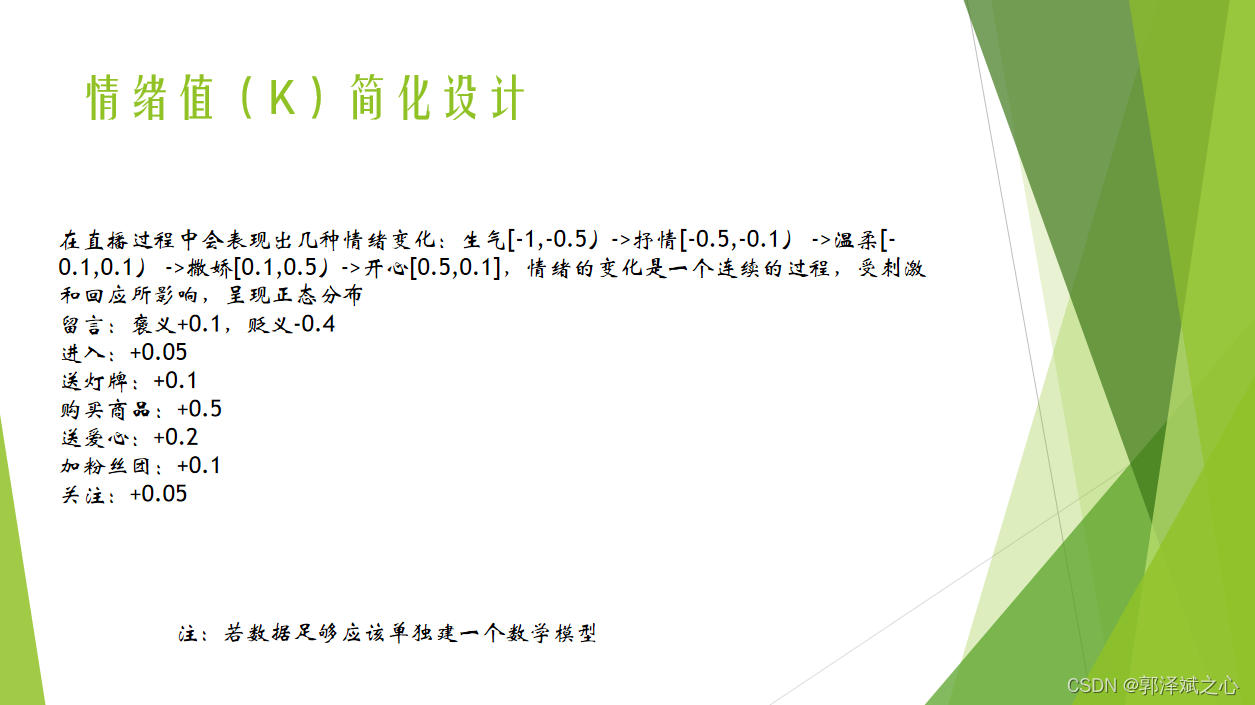

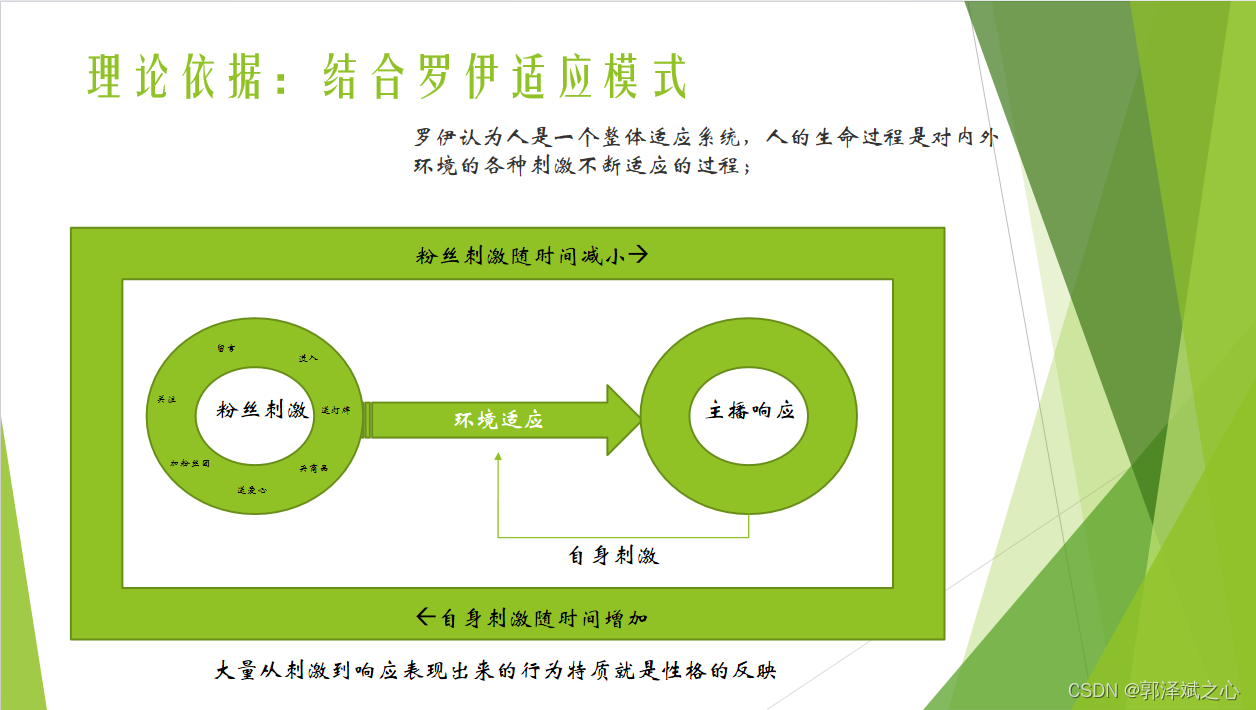

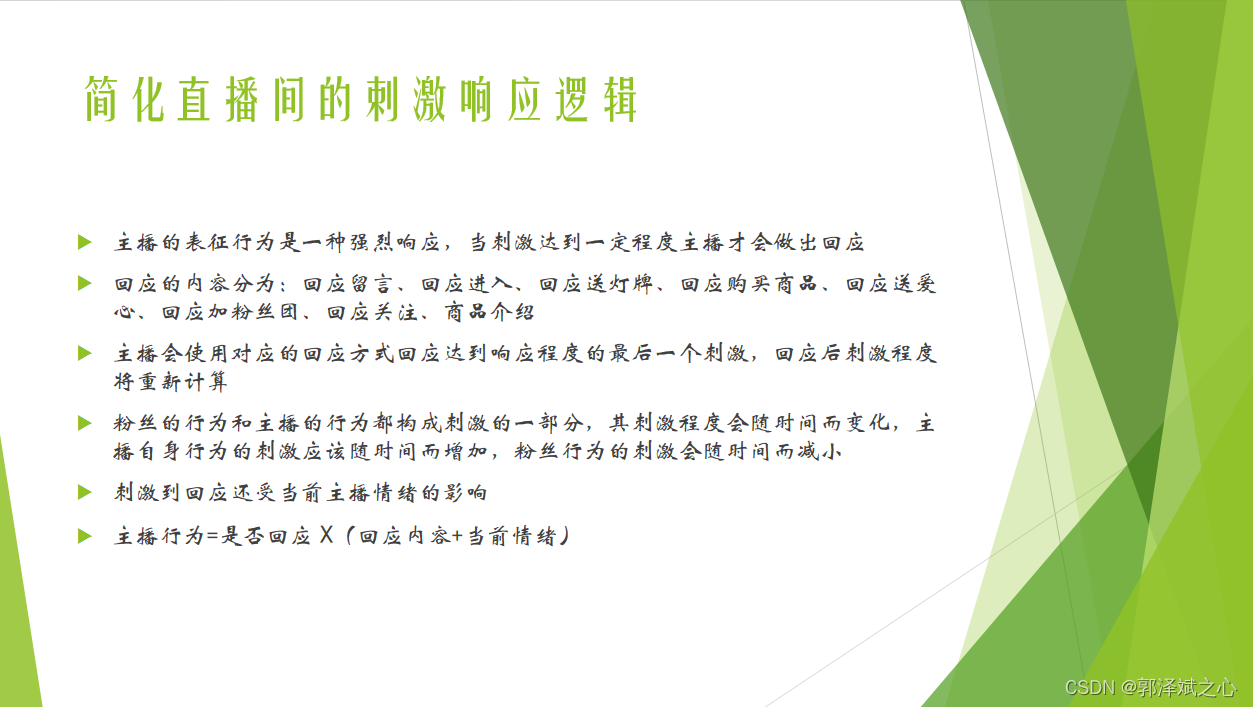

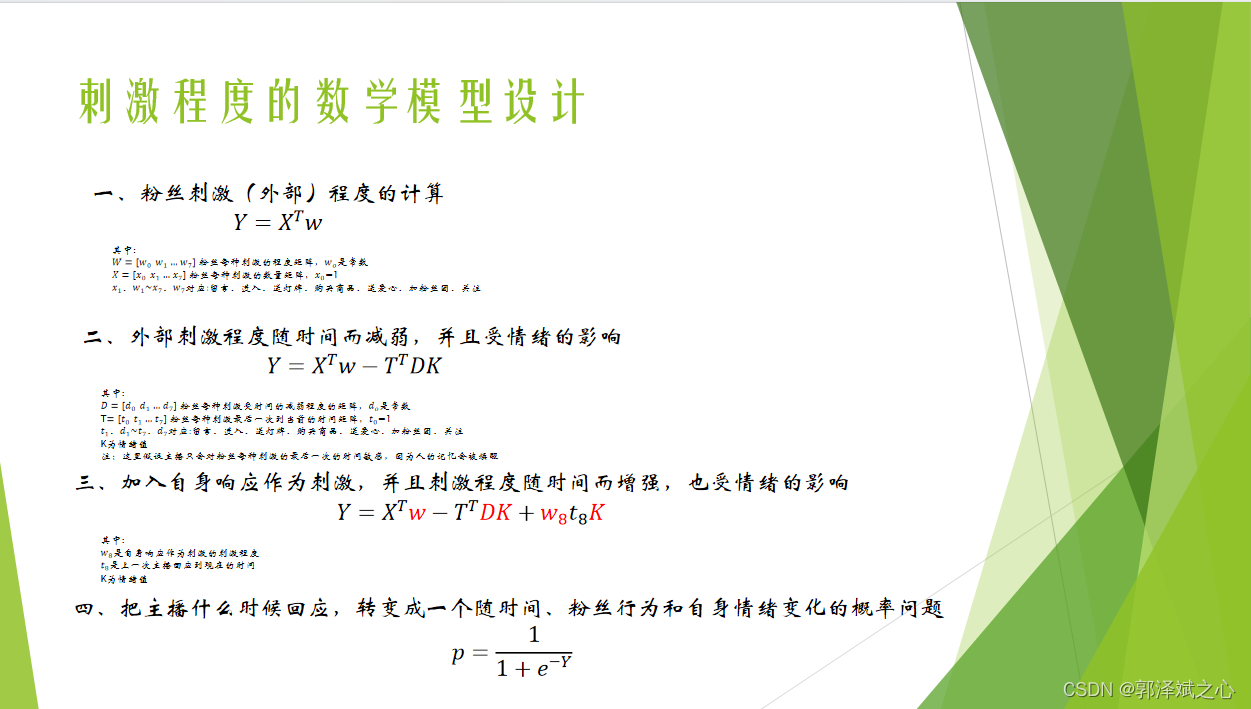

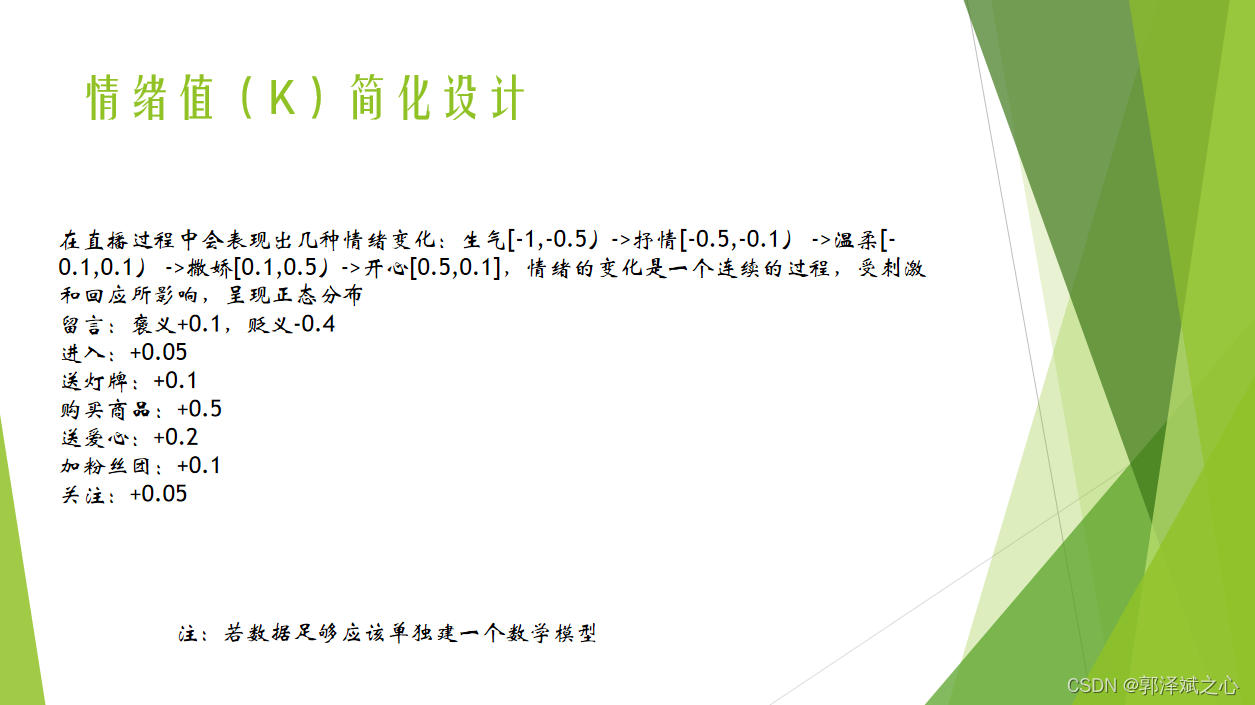

上面这份ppt写于Fay开源之前。当然,以现在的认知再去评价当时的设计,会发现有诸多的不严谨,甚至缺憾。比如,以单层的网络结构肯定无法拟合人性这个复杂的东西,人性也不是只受已知的几个参数所作用。但我现在想说的是,我们程序员不仅可以把更复杂的模型设计出来,也可以通过三维把最终效果呈现出来!

上面这份ppt写于Fay开源之前。当然,以现在的认知再去评价当时的设计,会发现有诸多的不严谨,甚至缺憾。比如,以单层的网络结构肯定无法拟合人性这个复杂的东西,人性也不是只受已知的几个参数所作用。但我现在想说的是,我们程序员不仅可以把更复杂的模型设计出来,也可以通过三维把最终效果呈现出来!